Aujourd’hui, la confiance dans la qualité des données est d’une importance cruciale, car les dirigeants de l’enseignement supérieur doivent répondre à diverses pressions politiques et économiques. Les collèges et les universités sont également scrutés à la loupe pour garantir leur responsabilité financière tout en servant au mieux les étudiants. Aujourd'hui plus que jamais, les équipes financières de l'enseignement supérieur ont besoin de données fiables, précises et actualisées pour prendre les bonnes décisions pour chaque école.

Les conseils d’administration des universités demandent également aux établissements d’assurer plus de transparence et de responsabilité. Cette demande signifie qu’il est plus important que jamais de disposer d’une stratégie claire pour une gestion continue et robuste de la qualité des données. Pourquoi? De meilleures décisions créent de meilleurs résultats. Et des données de haute qualité donnent aux établissements la confiance dans les données nécessaires pour prendre les bonnes décisions, ce qui, à son tour, alimente un meilleur soutien aux étudiants, des résultats plus précis et une réduction des risques.

Pourquoi la qualité des données est-elle importante ?

La recherche a montré que la qualité des données est importante. Selon Fenêtre, près de neuf organisations sur 10 (89 %) ont signalé les problèmes de qualité des données comme un obstacle ayant un impact important ou très important pour leur organisation. Les impacts entraînent un manque de confiance dans les données et une perte de temps dans les processus financiers et opérationnels.

En fait, de nombreuses institutions cherchent à s’orienter davantage vers les données. Selon La chronique de l'enseignement supérieur, 97 % des administrateurs d'université interrogés estiment que l'enseignement supérieur doit mieux utiliser les données et les analyses pour prendre des décisions stratégiques.

À mesure que les institutions deviennent plus complexes, il est également nécessaire de se concentrer sur la qualité des données. Comme le dit l’adage « garbage in, garbage out » (voir Figure 1), il est donc impératif de créer une base solide de données gouvernées pour une prise de décision basée sur les données. Il est impératif de disposer d’une source de données fiable dans toute l’institution pouvant être référencée pour aligner les équipes.

Qu’est-ce qui empêche une bonne qualité des données ?

Dans de nombreux cas, les institutions sont confrontées aux restrictions liées à des processus financiers déconnectés, à des systèmes existants et à des outils d’analyse inefficaces. Cette bureaucratie a alimenté un manque d’agilité, des processus lourds et une prise de décision cloisonnée. En termes simples, les solutions en place ne sont pas conçues pour fonctionner ensemble et rendent donc difficile la gestion de la qualité des données.

Il existe souvent peu ou pas de connectivité entre les systèmes, obligeant les utilisateurs à récupérer manuellement les données d'un système, à les transformer manuellement, puis à les charger dans un autre système, sans aucune traçabilité. Ce manque de capacités robustes en matière de qualité des données crée une multitude de problèmes. En voici quelques-uns :

- Mauvaise saisie des données avec une validation limitée, affectant la confiance dans les chiffres.

- Nombre élevé de tâches manuelles, réduisant la qualité globale des données et ajoutant de la latence aux processus.

- Aucune traçabilité des données, ce qui empêche les capacités d'exploration en profondeur et en arrière et ajoute du temps et des efforts manuels lors de l'accès à des informations exploitables pour chaque numéro.

La solution aux systèmes déconnectés peut être aussi simple que de passer à des outils et à des technologies plus récents. Pourquoi? Ils disposent d'une intégration plus efficace ainsi que d'une validation et d'un contrôle intégrés par rapport aux solutions précédentes, ce qui permettra de gagner du temps et de supprimer les tâches manuelles.

Quelle est la solution?

Certains pensent que la loi de Pareto – selon laquelle 20 % des données permettent 80 % des cas d’utilisation – s’applique à la qualité des données. Les établissements doivent donc franchir trois étapes avant d’adopter tout projet visant à améliorer la qualité des données financières :

- Définir la qualité : Déterminez ce que la qualité signifie pour le collège ou l’université, convenez de la définition et établissez des paramètres pour atteindre le niveau avec lequel tout le monde se sentira en confiance.

- Rationalisez la collecte de données : Assurez-vous que le nombre de systèmes disparates est minimisé et que les intégrations utilisent une technologie de classe mondiale avec une cohérence dans les processus d'intégration des données.

- Identifiez l’importance des données : Sachez quelles données sont les plus critiques pour l’organisation et commencez par là – avec les 20 % – et n’avancez que lorsque l’organisation est prête.

À la base, un système entièrement intégré Plateforme financière comme OneStream avec des données financières intégrées est essentiel pour que les collèges puissent conduire une transformation efficace dans la finance et dans les différentes fonctions et services. Quelles exigences clés doivent être prises en compte ? Voici quelques fonctions clés :

- Visibilité à 100 % depuis les rapports jusqu'aux sources de données, afin que toutes les données financières et opérationnelles soient visibles et facilement accessibles.

- Une source de vérité pour toutes les données financières et opérationnelles.

- Flux de travail guidés pour protéger les utilisateurs de la complexité et des oublis manuels.

Pourquoi OneStream pour la gestion de la qualité des données ?

La plate-forme unifiée de OneStream offre des capacités d'intégration de données de pointe avec des connexions transparentes à plusieurs sources, notamment les systèmes financiers, RH et étudiants. Ces fonctionnalités offrent une flexibilité et une visibilité inégalées sur le processus de chargement et d’intégration des données.

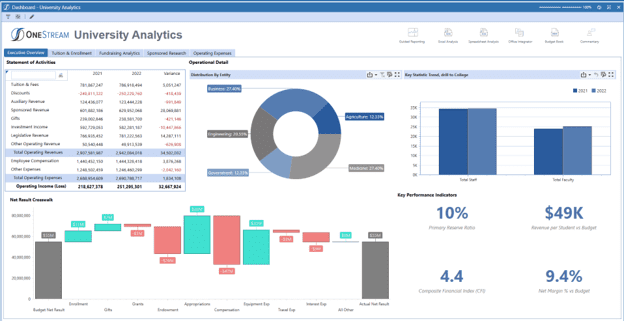

de OneStream gestion de la qualité des données est un élément essentiel de la plate-forme unifiée de OneStream (voir Figure 2). En fournissant des contrôles stricts pour garantir la confiance et la fiabilité de la qualité des données, la plateforme permet aux organisations d'effectuer les opérations suivantes :

- Gérez les risques liés à la qualité des données à l'aide de cartes d'intégration et de validations entièrement vérifiables à chaque étape du processus, de l'intégration au reporting.

- Automatisez les données via des connexions directes aux bases de données sources ou via n'importe quel format de fichier basé sur des caractères.

- Filtrez les rapports d’audit en fonction de seuils de matérialité – en garantissant des examens ponctuels à des moments appropriés du processus.

- Possibilité d'explorer, d'explorer en arrière et d'accéder aux détails des transactions pour une traçabilité complète de chaque numéro.

Conclusion

Les exigences d’exactitude, de transparence et de confiance sont omniprésentes dans les rapports, analyses et planifications financières et opérationnelles, étant donné le niveau de détail nécessaire pour guider les institutions. Par conséquent, les universités qui cherchent à créer une stratégie pour améliorer la gestion de la qualité des données devraient envisager une plate-forme logicielle CPM avec qualité des données financières intégrée pour obtenir des résultats plus précis et réduire les risques.

En savoir plus

Découvrez comment OneStream peut produire des données de meilleure qualité et améliorer la précision des résultats financiers de l'enseignement supérieur.

En savoir plusAujourd’hui, la confiance dans la qualité des données est d’une importance cruciale. Les exigences d'exactitude et de confiance sont omniprésentes dans les rapports, analyses et planifications financières et opérationnelles, étant donné le niveau de détail nécessaire pour guider l'entreprise. La croissance de l’intelligence artificielle (IA) et de l’apprentissage automatique (ML) exige également des données de qualité au niveau granulaire. Compte tenu de ces demandes, Le vieil adage « garbage in, garbage out » s’applique plus que jamais aujourd’hui.

Les dirigeants doivent constamment réagir à des changements variés et évolutifs et ont donc besoin de données fiables, précises et opportunes pour prendre les bonnes décisions concernant les actions nécessaires. Par conséquent, les organisations modernes doivent disposer d’une stratégie claire pour une gestion continue et solide de la qualité des données. Pourquoi? Eh bien, de meilleures décisions créent de meilleurs résultats. Et des données de haute qualité donnent aux organisations la confiance dans les données nécessaires pour prendre les bonnes décisions, générer de meilleures performances, des résultats plus précis et réduire les risques.

Pourquoi la qualité des données est-elle importante ?

La qualité des données est importante, comme le montrent les recherches. Selon Fenêtre, près de neuf organisations sur dix (10 %) ont signalé les problèmes de qualité des données comme un obstacle important ou très important. Ces impacts entraînent un manque de confiance dans les données et une perte de temps dans les processus financiers et opérationnels.

À mesure que les organisations se tournent vers des technologies plus modernes pour orienter de meilleures orientations futures, l’accent mis sur la gestion de la qualité des données dans les systèmes d’entreprise n’a fait que croître. Dans un rapport sur combler l’écart entre données et valeur, Accenture a déclaré que « sans confiance dans les données, les organisations ne peuvent pas construire une base de données solide ». Selon le rapport, seul un tiers des entreprises font suffisamment confiance à leurs données pour les utiliser efficacement et en tirer de la valeur.

Bref, l’importance de la qualité des données est de plus en plus évidente. À mesure que les organisations deviennent plus complexes et que les volumes de données augmentent toujours plus, l’attention se porte naturellement sur la qualité des données utilisées. Sans oublier qu’à mesure que des fonctionnalités plus avancées sont explorées et adoptées – telles que l’IA et le ML – les organisations doivent d’abord examiner leurs données, puis prendre des mesures pour garantir une qualité efficace des données. Pourquoi ces étapes sont-elles nécessaires ? En termes simples, les meilleurs résultats de l’IA, du ML et d’autres technologies avancées dépendent entièrement de données de bonne qualité et propres dès le départ.

Qu’est-ce qui empêche une bonne qualité des données ?

Dans de nombreux cas, les anciens systèmes CPM et ERP n'étaient tout simplement pas conçus pour fonctionner ensemble, ce qui rendait difficile la gestion de la qualité des données. De tels systèmes avaient également tendance à rester distincts en tant qu’applications cloisonnées, chacune ayant son propre objectif. Souvent, il existe peu ou pas de connectivité entre les systèmes, ce qui oblige les utilisateurs à récupérer manuellement les données d'un système, à les transformer manuellement, puis à les charger dans un autre système.

Ce manque de capacités robustes en matière de qualité des données crée une multitude de problèmes. En voici quelques-uns :

- Mauvaise saisie des données avec une validation limitée, affectant la confiance dans les chiffres.

- Nombre élevé de tâches manuelles, réduisant la qualité globale des données et ajoutant de la latence aux processus

- Aucune traçabilité des données, ce qui empêche les capacités d'exploration en profondeur et en arrière et ajoute du temps et des efforts manuels pour accéder à des informations exploitables pour chaque numéro.

La solution peut être aussi simple que de démontrer combien de temps peut être gagné en passant à des outils et des technologies plus récents. Grâce à de telles transitions, la réduction du temps investi peut améliorer considérablement la qualité du données via une intégration efficace avec à la fois une validation et un contrôle intégrés au système lui-même.

Quelle est la solution?

Certains pensent que la loi de Pareto – selon laquelle 20 % des données permettent 80 % des cas d'utilisation – s'applique à la qualité des données. Les organisations doivent donc franchir 3 étapes avant d’adopter tout projet visant à améliorer la qualité des données financières :

- Définir la qualité – Déterminez ce que la qualité signifie pour l’organisation, convenez de la définition et définissez des paramètres pour atteindre le niveau avec lequel chacun se sentira en confiance.

- Rationalisez la collecte de données – Assurez-vous que le nombre de systèmes disparates est minimisé et que les intégrations utilisent une technologie de classe mondiale avec une cohérence dans les processus d’intégration des données.

- Identifier l'importance des données – Sachez quelles données sont les plus critiques pour l’organisation et commencez par là – avec les 20 % – et n’avancez que lorsque l’organisation est prête.

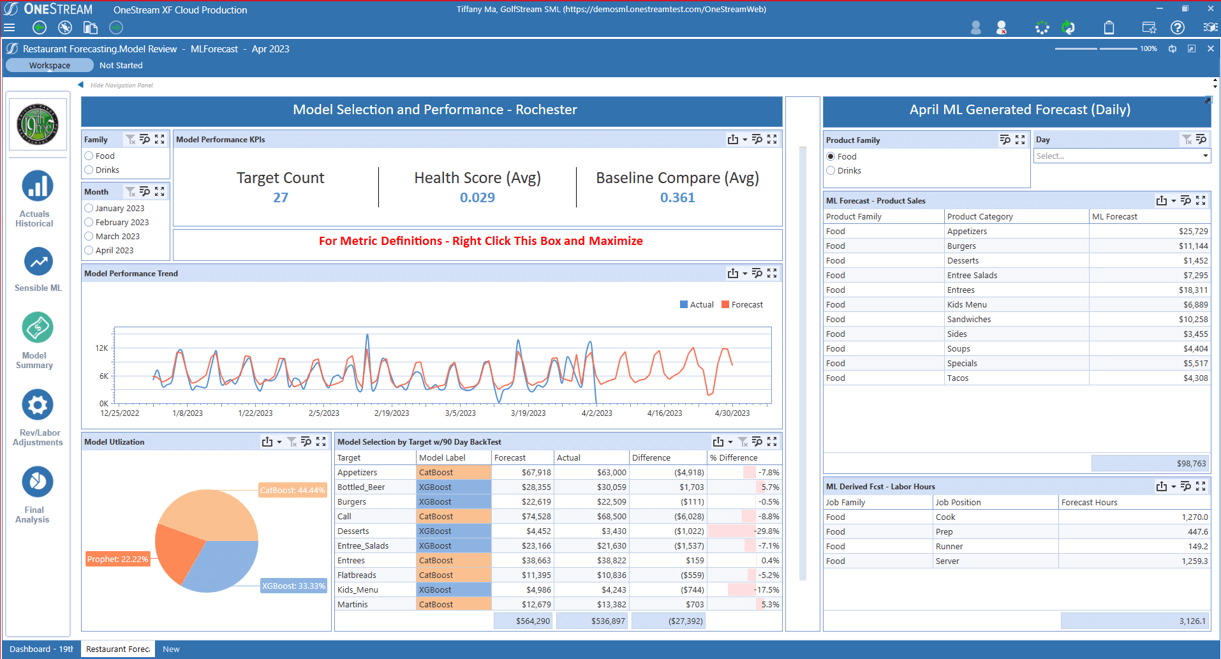

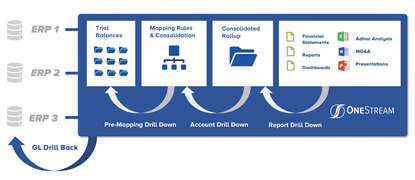

À la base, un système entièrement intégré Plateforme logicielle CPM avec intégré La qualité des données financières (voir Figure 1) est essentielle pour que les organisations puissent mener une transformation efficace au sein de la finance et des secteurs d'activité. Une exigence clé est de fournir une visibilité à 100 % depuis les rapports jusqu'aux sources de données, ce qui signifie que toutes les données financières et opérationnelles doivent être clairement visibles et facilement accessibles. Les processus financiers clés doivent être automatisés. De plus, l’utilisation d’une interface unique signifierait que l’entreprise pourrait utiliser ses données financières et opérationnelles de base avec une intégration complète à tous les ERP et autres systèmes.

Figure 1 : Gestion intégrée de la qualité des données financières dans OneStream

La solution doit également inclure des flux de travail guidés pour protéger les utilisateurs professionnels de la complexité. Comment? En les guidant de manière unique à travers tous les processus de gestion, de vérification, d'analyse, de certification et de verrouillage des données.

Pourquoi OneStream pour la gestion de la qualité des données ?

La plate-forme unifiée de OneStream offre des capacités d'intégration de données de pointe avec des connexions transparentes à plusieurs sources. Ces fonctionnalités offrent une flexibilité et une visibilité inégalées sur le processus de chargement et d’intégration des données.

de OneStream gestion de la qualité des données n'est pas un module ou un produit distinct, mais plutôt un élément essentiel de la plateforme unifiée de OneStream. La plateforme fournit des contrôles stricts pour garantir la confiance et la fiabilité de la qualité des données en permettant aux organisations d'effectuer les opérations suivantes :

- Gérez les risques liés à la qualité des données à l'aide de cartes d'intégration et de validations entièrement vérifiables à chaque étape du processus, de l'intégration au reporting.

- Automatisez les données via des connexions directes aux bases de données sources ou via n'importe quel format de fichier basé sur des caractères.

- Filtrez les rapports d’audit en fonction de seuils de matérialité – en garantissant des examens ponctuels à des moments appropriés du processus.

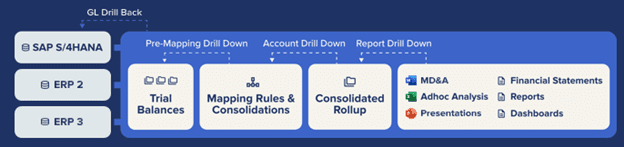

Le cadre d'intégration OneStream et les connecteurs prédéfinis offrent une intégration directe avec n'importe quel GL/ERP ouvert ou autre système source (voir Figure 1). Cette fonctionnalité offre des avantages clés :

- Processus d’intégration de système directs à la source rapides et efficaces.

- Possibilité d'explorer, d'explorer en arrière et d'accéder aux détails des transactions pour une traçabilité complète de chaque numéro.

- Intégration directe avec accès à plus de 250 systèmes ERP, HCM, CRM et autres (par exemple, Oracle, PeopleSoft, JDE, SAP, Infor, Microsoft AX/Dynamics et plus encore).

La clé du succès de nos clients

Voici un exemple d'organisation qui a rationalisé l'intégration des données et amélioré la qualité des données :

« Avant OneStream, nous devions analyser les données du projet dans tous les systèmes ERP individuels », a déclaré Joost van Kooten, contrôleur de projet chez Huisman. « OneStream contribue à rendre nos données auditables et extensibles. Cela nous permet de comprendre notre activité et de créer des processus standardisés au sein d’un système mondial. Nous faisons confiance aux données de OneStream, il n'y a donc aucun désaccord quant à leur exactitude. Nous pouvons nous concentrer sur le contrat, sans corriger les données.

Comme tous les clients OneStream, Huisman a constaté que la confiance que procure « une seule version de la vérité » est tout à fait possible avec OneStream.

En savoir plus

Si votre organisation financière est empêchée de libérer sa véritable valeur, il est peut-être temps d'évaluer vos systèmes et processus internes et de commencer à identifier les domaines à améliorer. Pour savoir comment procéder, lisez notre livre blanc Conquérir la complexité dans la clôture financière.

Télécharger la publicationIntroduction

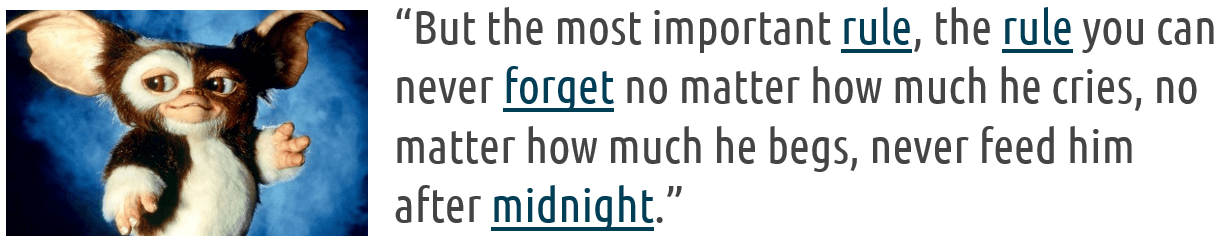

Dans le monde effervescent de l'intelligence artificielle (IA), un dicton résume parfaitement l'essence du travail - "ordures dedans, ordures de sortie". Pourquoi ? Ce mantra souligne une vérité souvent sous-estimée au milieu de l'excitation des technologies et algorithmes émergents utilisés dans les équipes FP&A : la qualité des données est un facteur décisif pour le succès ou l'échec de tout projet d'apprentissage automatique (ML).

Le Big Data, souvent appelé le « nouveau pétrole », alimente les moteurs ML sophistiqués qui guident la prise de décision dans les industries et les processus. Mais tout comme un vrai moteur ne peut pas fonctionner efficacement avec un carburant de qualité inférieure, les modèles ML entraînés sur des données de mauvaise qualité produiront sans aucun doute des résultats inférieurs. En d'autres termes, pour que l'IA dans les processus FP&A réussisse, la qualité des données est essentielle. Lisez la suite pour en savoir plus dans notre premier article de notre série AI for FP&A.

Comprendre l'importance de la qualité des données

Les data scientists dépensent 50%-80% de leur temps à collecter, nettoyer et préparer des données avant qu'elles ne puissent être utilisées pour créer des informations précieuses. Cet investissement en temps témoigne de la raison pour laquelle « ordures à l'intérieur, ordures à la sortie » n'est pas un avertissement mais une règle à respecter dans le domaine de l'IA et du ML. En particulier pour FP&A, cette règle montre pourquoi lésiner sur la qualité des données peut entraîner des prévisions inexactes, des résultats biaisés et une perte de confiance dans les systèmes révolutionnaires d'IA et de ML.

Libérer les données avec Sensible ML

À l'ère numérique actuelle, les entreprises ont un accès sans précédent à de vastes quantités de données. Les données constituent une base essentielle pour prendre des décisions commerciales importantes. Mais pour s'assurer que les données mises à la disposition des employés sont fiables, visibles, sécurisées et évolutives, les entreprises doivent investir considérablement dans des solutions de gestion des données. Pourquoi ? Des données de qualité inférieure peuvent déclencher des résultats catastrophiques qui pourraient coûter des millions. Si les données utilisées pour former les modèles ML sont incomplètes ou inexactes, cela peut entraîner des prédictions inexactes avec des décisions commerciales conséquentes qui entraînent une perte de revenus. Par exemple, si de mauvaises données entraînent des prévisions incorrectes sur la demande, cela pourrait conduire l'entreprise à produire trop peu ou trop de produit, ce qui entraînerait des pertes de ventes, des coûts d'inventaire excessifs ou des expéditions urgentes et des heures supplémentaires.

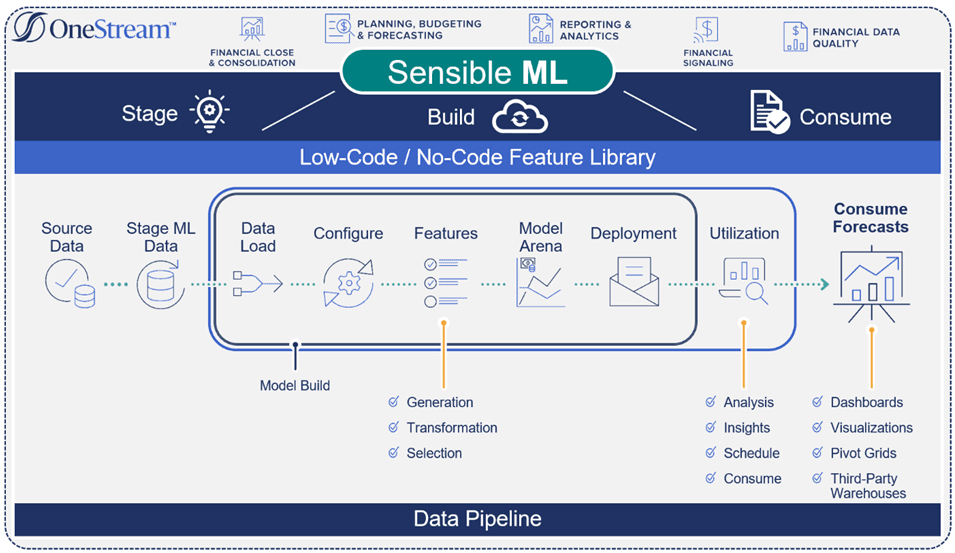

Contrairement à « la plupart » des méthodes de prévision analytique prédictive, qui génèrent des prévisions basées sur des résultats historiques et des statistiques, de OneStream ML sensé intègre vrai perspectives d'affaires. Ces informations incluent des facteurs tels que les événements, les prix, les données concurrentielles et la météo, qui contribuent tous à des prévisions plus précises et plus solides (voir Figure 1).

Figure 1 : Flux de processus de ML raisonnable

Gestion des données de bout en bout

Les données FP&A et opérationnelles jouent un rôle central dans le succès de tout scénario de prévision d'apprentissage automatique. Cependant, pour créer des flux de données spécialement conçus pour évoluer efficacement et offrir des expériences utilisateur exceptionnelles, des solutions avancées, telles que Sensible ML, sont nécessaires. Sensible ML peut accélérer et automatiser les décisions cruciales tout au long du cycle de vie des données, de la source de données à la consommation (voir Figure 2).

Les capacités avancées de flux de données encouragent ce qui suit :

- La confiance dans l' gouvernance des données en garantissant la confidentialité des données, le respect des normes organisationnelles et une traçabilité transparente de la lignée des données.

- Enrichi données internes avec des sources externes en ajoutant des variables externes qui alimentent les améliorations (par exemple, les détaillants ajoutent des variables externes aux données existantes pour mieux profiler et reconnaître les besoins des clients en matière de recommandations, de vente incitative et de vente croisée).

- Accéléré informatique en surveillant en permanence la qualité, l'actualité et le contexte prévu des données.

Figure 2 : Pipeline de ML raisonnable

Sensible ML exploite les capacités de gestion de données intégrées de OneStream pour ingérer les données sources et l'intuition commerciale. Comment? Les connecteurs intégrés récupèrent automatiquement des données externes telles que la météo, les taux d'intérêt et d'autres indicateurs macroéconomiques qui peuvent être utilisés dans le processus de création de modèles. Alors que Sensible ML teste ensuite automatiquement les sources de données externes sans aucune intervention de l'utilisateur, les utilisateurs décident finalement quelles données utiliser.

Utilisation de Sensible ML intégré Qualité des données

Sensible ML peut apporter des données opérationnelles détaillées à partir de n'importe quelle source, y compris les systèmes de point de vente (POS), les entrepôts de données (DW), les systèmes de planification des ressources d'entreprise (ERP) et les données de cube multidimensionnelles.

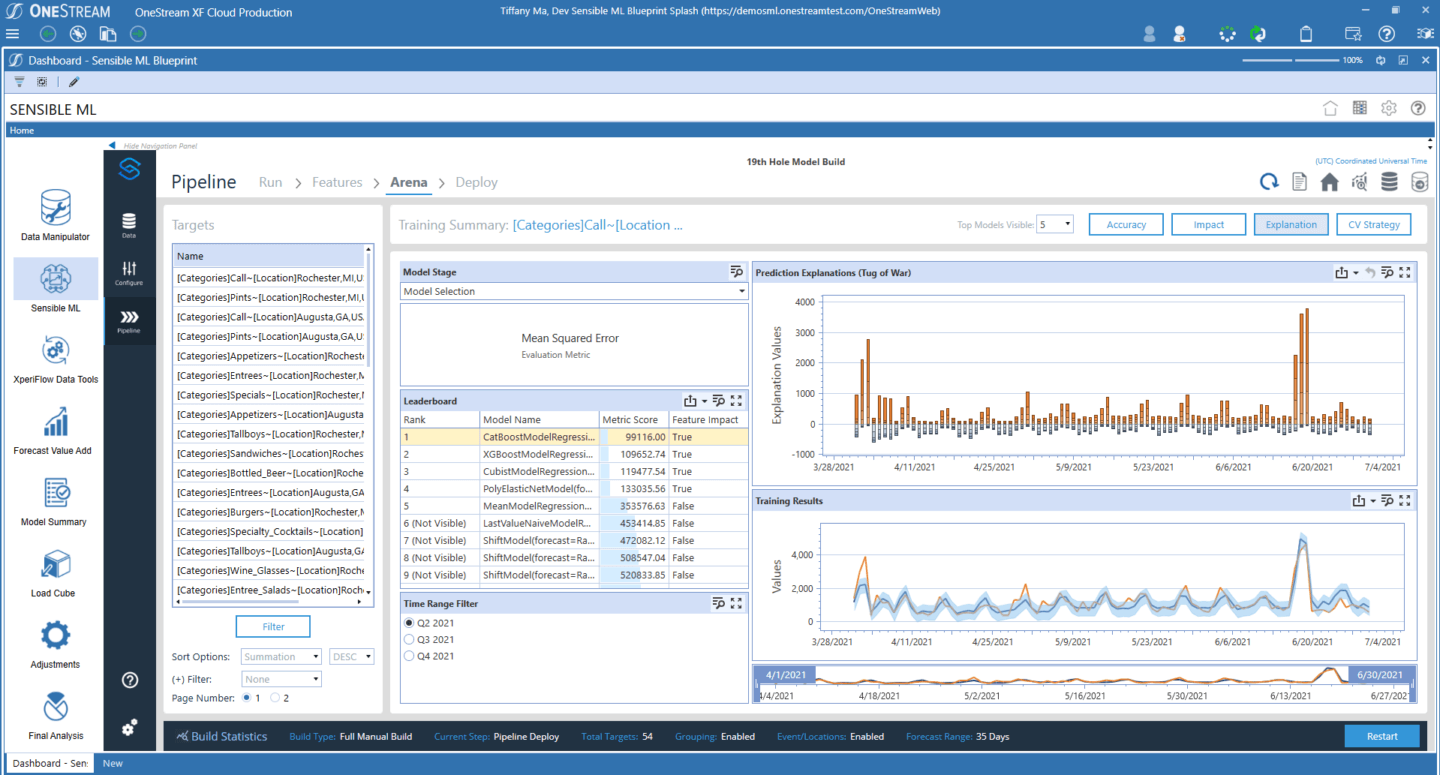

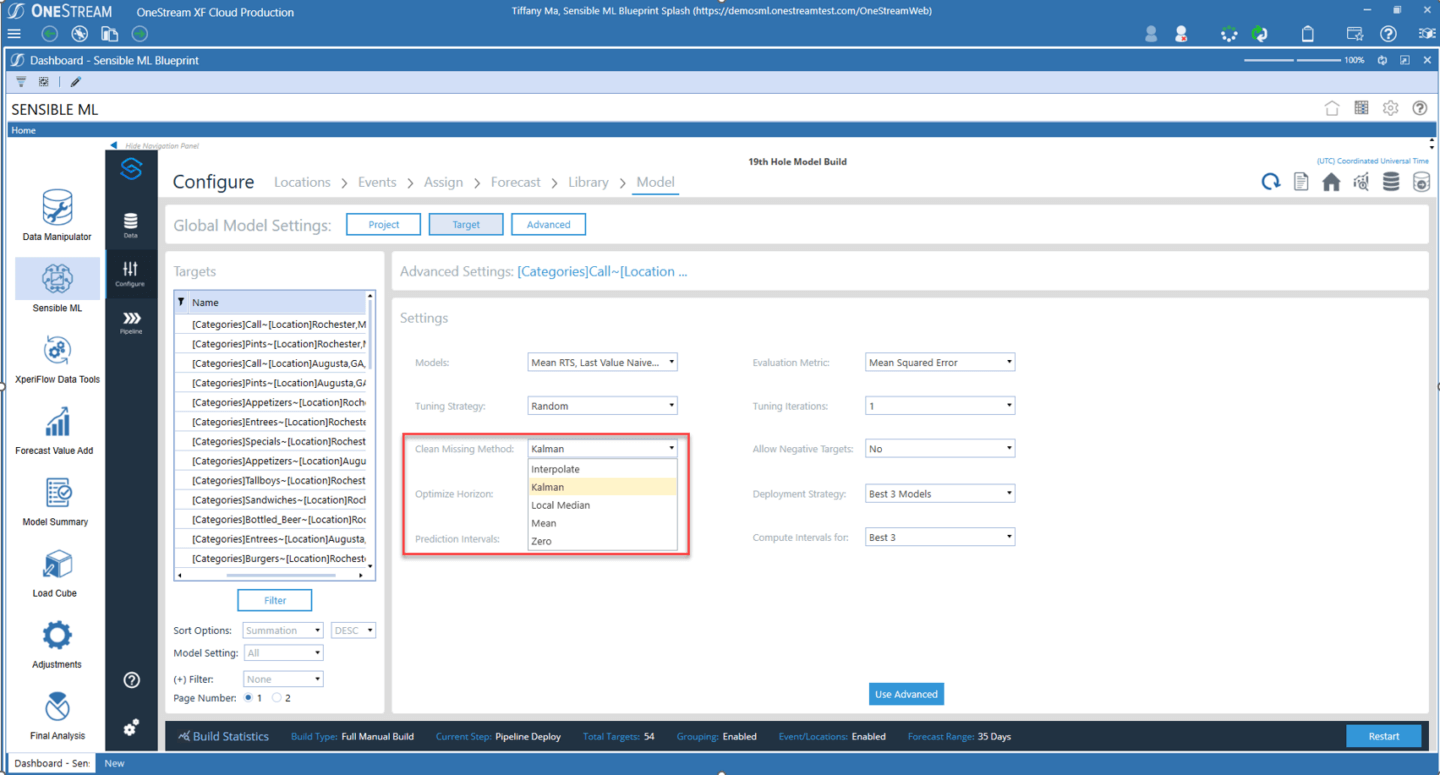

Les capacités de qualité des données de Sensible ML offrent certaines des capacités les plus robustes disponibles sur le marché FP&A. Ces fonctionnalités incluent des validations et des confirmations avant et après le chargement des données, un audit complet et une flexibilité totale dans la manipulation des données. De plus, la gestion des données de Sensible ML surveille le comportement typique de la conservation des données, puis envoie des alertes en cas d'anomalies (voir figure 3). Voici quelques exemples:

- Fraîcheur des données – Les données sont-elles arrivées au moment où elles auraient dû ?

- Volume de données – Y a-t-il trop ou trop peu de lignes ?

- Schéma de données – L'organisation des données a-t-elle changé ?

Figure 3 : Nettoyage automatique des données de Sensible ML

Dans Sensible ML, une interface intuitive propose des listes déroulantes avec les méthodes de nettoyage des données les plus performantes et les plus efficaces, permettant aux utilisateurs professionnels de toutes les compétences d'exécuter l'intégralité du pipeline de données du début à la fin.

Conclusion

Assurer la qualité des données n'est pas seulement une case à cocher dans le parcours d'apprentissage automatique. Au contraire, la qualité des données est le fondement sur lequel repose tout l'édifice. Alors que les limites de ce qui est possible avec ML sont continuellement repoussées, l'adage séculaire « Garbage in, garbage out » s'appliquera toujours. Les entreprises doivent donc s'efforcer d'accorder à la qualité des données l'attention qu'elle mérite. Après tout, l'avenir de l'apprentissage automatique ne se résume pas à des algorithmes plus complexes ou à des calculs plus rapides. La production de modèles précis, justes et fiables - ceux construits sur la base de données de haute qualité - est également essentielle pour un ML efficace.

En savoir plus

Pour en savoir plus sur le flux de données de bout en bout et sur la façon dont FP&A interagit avec les données, restez à l'écoute pour d'autres articles de notre série de blogs Sensible ML. Vous pouvez également télécharger notre livre blanc ici.

Partout dans le monde, les organisations s'appuient sur les données pour prendre des décisions éclairées et améliorer leurs résultats grâce à la gestion des données. Mais avec la grande quantité de données aujourd'hui, les choses peuvent rapidement devenir incontrôlables et engendrer des gremlins de données (c'est-à-dire de petites poches de données déconnectées et non gouvernées) qui font des ravages dans l'organisation.

Rappelez-vous ces adorables créatures qui se sont transformées en créatures destructrices et espiègles lorsqu'elles ont été nourries après minuit dans le film d'horreur comique de 1984 Gremlins? (voir Figure 1)

De la même manière, les gremlins de données - alias "dette technique" – peut survenir si vos systèmes ne sont pas flexibles pour permettre aux services financiers de fonctionner. Gérer efficacement les données pour empêcher les gremlins de données de faire des ravages est crucial dans toute organisation moderne - et cela nécessite d'abord de comprendre la montée des gremlins de données.

Avez-vous des gremlins de données ?

Comment les gremlins de données apparaissent-ils et comment prolifèrent-ils si rapidement ? Les premiers débuts ont commencé avec Excel. Les employés des finances et des opérations recevraient de grandes piles de rapports de barres vertes (voir la figure 2). Vous ne vous en souvenez pas ? Ils ressemblaient à l'image ci-dessous et étaient classés et empilés dans de grandes pièces.

Lorsque vous aviez besoin de données, vous extrayiez le rapport, retapiez les données dans Excel, ajoutiez une mise en forme et des calculs, imprimiez la feuille de calcul et la déposiez dans la boîte de réception de votre patron. Votre patron passerait alors en revue et ferait des suggestions et des ajouts jusqu'à ce qu'il soit convaincu (un terme relatif ici !) Que le partage de la feuille de calcul avec la haute direction serait utile, et le tour est joué, un gremlin est né.

Et les gremlins sont mauvais pour l'organisation.

La montée des gremlins de données

Les gremlins de données ne sont pas un phénomène nouveau, mais un phénomène qui peut avoir de graves répercussions sur l'organisation, entraînant une perte de temps et de ressources, une perte de revenus et une réputation endommagée. Pour cette raison, il est essentiel d'avoir une stratégie de gestion des données robuste pour empêcher les gremlins de données de causer des ravages.

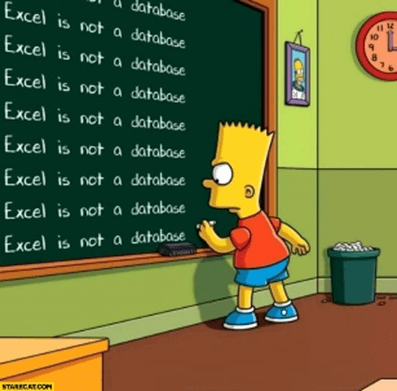

Au fur et à mesure que les systèmes et l'intégration devenaient plus sophistiqués et que les grands livres généraux devenaient un registre fiable, les gremlins de données auraient dû disparaître. Mais ont-ils? Non, même pas un peu. En fait, les gremlins de données ont augmenté plus rapidement que jamais, en partie à cause de la montée du bouton le plus populaire sur n'importe quel rapport, n'importe où à l'époque - vous l'avez deviné - le "Exporter vers .CSV" bouton. La création de nouveaux gremlins est devenue encore plus facile et plus rapide, et la direction a commencé à demander de plus en plus d'analyses qui pourraient facilement être créées dans des feuilles de calcul (voir Figure 3). Pour répondre à la demande de 2006, Microsoft augmenté le nombre de lignes de données qu'une seule feuille pourrait avoir à un million de lignes. Un million! Et les gens ont applaudi !

Cependant, des erreurs ont été enterrées dans ces feuilles de calcul d'un million de lignes, pas seulement dans certaines feuilles de calcul, mais dans presque TOUTES. Les feuilles de calcul n'avaient pas de gouvernance globale et ne pouvaient en aucun cas être vérifiées automatiquement. En conséquence, ces erreurs vivraient pendant des mois et des années. Tout consultant qui a expérimenté ces feuilles de calcul confirmera les histoires de personnes ajoutant "+1,000,000 XNUMX XNUMX" à une formule en tant qu'ajustement de dernière minute, puis oubliant de supprimer l'ajout plus tard. Les grandes entreprises ont signalé des numéros incorrects dans la rue et des personnes ont perdu leur emploi à cause de ces erreurs.

Au fil du temps, les outils sont devenus plus sophistiqués - de MS Excel et MS Access à solutions de planification départementales tel que Anaplan, Essbase, Vena Solutions, Workday Adaptive et autres. Pourtant, aucun n'est à la hauteur du niveau de fiabilité que le service informatique est chargé d'atteindre. Les contrôles et les audits ne sont rien comparés à ce que la planification des ressources d'entreprise (ERP) fournissent. Alors pourquoi de tels outils continuent-ils à proliférer ? Qui les nourrit après minuit, pour ainsi dire ? La vraie raison est que ces systèmes de planification ministérielle sont comme un marteau. Chaque fois qu'un nouveau modèle ou un besoin d'analyse surgit, c'est "Construisons un autre cube". Même si cette structure de données particulière n'est pas la meilleure réponse, les Finances ont un marteau, et ils vont marteler quelque chose avec. Et pourquoi devraient-ils faire leur diligence pour comprendre la prolifération des Gremlins ? (voir la figure 4)

La relation peut être décrite comme « compliquée ». Les ERP et les entrepôts de données sont des environnements sécurisés et gérés, mais n'offrent presque aucune flexibilité aux finances ou aux opérations pour effectuer des rapports ou des analyses sophistiqués qui n'ont pas été créés pour eux par le service informatique. Les demandes de nouveaux rapports sont effectuées, souvent par le biais d'un système de tickets, et plus l'informatique est efficace pour satisfaire ces demandes, plus la file d'attente des tickets s'allonge. Soudain, l'équipe ne fait plus que rendre compte, et cela laisse la finance se demander : "Comment diable y a-t-il une équipe de personnes dans l'informatique qui ne se concentre pas sur l'amélioration de l'efficacité de l'entreprise ?"

La réponse suggérée par les méga-éditeurs d'ERP est d'arrêter de faire cela. Les utilisateurs finaux n'ont pas vraiment besoin de ces données, de ce niveau de granularité ou de cette flexibilité. Ils doivent apprendre à simplifier et à ne pas se soucier de choses insignifiantes. Par exemple, les utilisateurs finaux n'ont pas besoin de visibilité sur ce qui se passe dans une consolidation juridique ou une prévision sophistiquée. « Faites-nous simplement confiance. Nous le ferons », déclarent les fournisseurs d'ERP.

Voici le problème: financier est chargé de fournir les bonnes données au bon moment avec la bonne analyse. Quel est le résultat du simple fait de « faire confiance » aux fournisseurs d'ERP ? Encore plus de gremlins de données. Plus de rapprochements manuels. Moins de sécurité et de contrôle sur les données les plus critiques pour l'entreprise. En d'autres termes, une organisation peut facilement dépenser 30 millions de dollars pour un système ERP sécurisé et bien conçu qui ne résout pas le problème du gremlin, ce qui explique pourquoi les organisations doivent contrôler le processus de gestion des données.

L'importance de maîtriser la gestion des données et de réduire la dette technique

Une gestion efficace des données permet aux entreprises de prendre des décisions éclairées sur la base de données précises et fiables. Mais contrôle gestion des données est ce qui empêche les gremlins de données et réduit la dette technique. Les problèmes de qualité des données sont perpétués par les gremlins et peuvent survenir lorsque des pratiques de gestion des données appropriées ne sont pas en place. Ces problèmes peuvent inclure des données incomplètes, incohérentes ou inexactes, entraînant des conclusions incorrectes, une mauvaise prise de décision et un gaspillage de ressources.

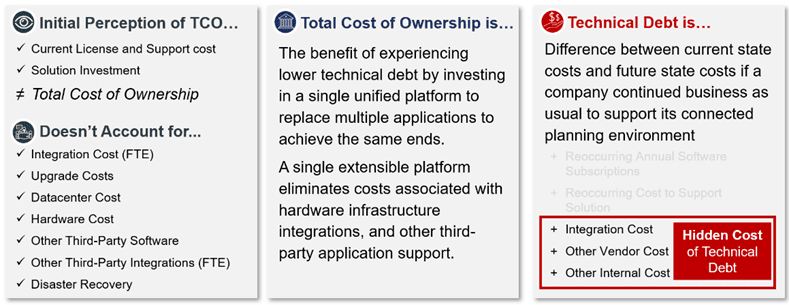

L'un des plus grands oublis dans le traitement des gremlins de données est de se concentrer uniquement sur le retour sur investissement (ROI) et de rejeter la dette technique entièrement chargée (voir la figure 5). De nombreuses équipes financières utilisent des mesures de performance telles que le coût total de possession (TCO) et le retour sur investissement pour déterminer que la solution est bonne pour l'organisation, mais l'organisation plonge rarement plus profondément - au-delà des mesures de performance pour inclure des opportunités de réduction des déchets de mise en œuvre et de maintenance. Malheureusement, cette vision des mesures de performance ne tient pas compte des complexités cachées et des coûts associés aux impacts négatifs de la croissance du gremlin de données.

La dette technique est AUTRES que le coût total de possession

Malheureusement, les gremlins de données peuvent survenir à n'importe quelle étape du processus de gestion des données, de la collecte des données à l'analyse et à la création de rapports. Ces gremlins peuvent être causés par divers facteurs, tels qu'une erreur humaine, des problèmes système ou même une activité malveillante. Par exemple, un gremlin de données peut être un champ manquant ou incorrect dans une base de données, entraînant des calculs ou des rapports inexacts.

Vous voulez une preuve? Pensez simplement au processus long et lent dans lequel vous et votre équipe vous engagez lorsque vous recherchez des informations entre des sources et des outils fragmentés plutôt que d'analyser les résultats et d'aider vos partenaires commerciaux à agir. Ce processus interminable vous semble-t-il familier ?

La bonne nouvelle est qu'une autre option existe. L'unification de ces multiples processus et outils peut fournir plus d'automatisation, supprimer les complexités du passé et répondre aux diverses exigences de l'organisation, même la plus complexe, à la fois aujourd'hui et à l'avenir. La clé est de créer un environnement flexible mais gouverné qui permet de créer des problèmes et de nouvelles analyses dans le cadre - pas de Gremlins.

Lumière du soleil sur les Data Gremlins

Chez OneStream, nous avons vécu et géré cette relation compliquée pendant toute notre carrière. Nous avons même créé des gremlins à l'époque où la réponse à tout était "créer une autre feuille de calcul". Mais nous avons éliminé les gremlins dans les feuilles de calcul uniquement pour les remplacer par des applications ou des cubes départementaux qui sont simplement des gremlins plus gros et plus méchants. Nos cicatrices de bataille nous ont appris que les gremlins, bien que faciles à utiliser et à gérer, ne sont pas la réponse. Au lieu de cela, ils prolifèrent et causent des problèmes plus récents et plus difficiles à résoudre de réconciliation sans fin des données.

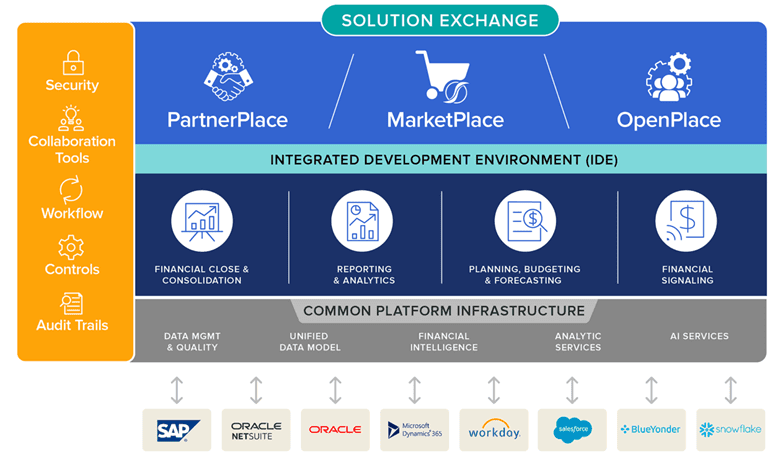

Pour cette raison, OneStream a été conçu et construit dès le départ pour éliminer les gremlins, y compris leur besoin futur (voir la figure 6). OneStream combine toute la sécurité, la gouvernance et l'audit nécessaires pour garantir l'exactitude des données - et fait tout en un seul endroit sans avoir besoin de se déplacer hors site tout en permettant d'exploiter la flexibilité à l'intérieur du cadre défini de manière centralisée. Dans OneStream, les organisations peuvent tirer parti de la dimensionnalité extensible pour fournir de la valeur aux utilisateurs finaux afin qu'ils « fassent leur travail » sans avoir à pousser le Bouton "Exporter vers .CSV".

OneStream est aussi une plateforme au sens le plus vrai du terme. La plate-forme fournit une intégration directe des données aux données sources, un retour à ces données et des outils de création de rapports et de tableaux de bord flexibles et faciles à utiliser.

Cela permet au service informatique d'éliminer les coûts sans valeur ajoutée liés à la création de rapports ET les gremlins, le tout d'un seul coup.

Enfin, notre plateforme est la seule plateforme EPM permettant aux organisations de développer leurs fonctionnalités directement sur la plateforme. C'est exact - OneStream est un plate-forme de développement complète où les organisations peuvent tirer parti de toutes les ressources de la plate-forme d'intégration et de reporting nécessaires pour que les organisations fournissent leur propre propriété intellectuelle (PI). Ils peuvent même chiffrer l'adresse IP dans la plate-forme ou la partager avec d'autres.

OneStream, en d'autres termes, permet aux organisations de gérer efficacement leurs données. Dans notre livre électronique sur gestion de la qualité des données financières, nous avons partagé les 3 principaux objectifs d'une gestion efficace de la qualité des données financières avec CPM :

- Intégration simplifiée des données – L'intégration directe à n'importe quel système GL/ERP ouvert permet aux utilisateurs d'accéder aux données sources.

- Amélioration de l'intégrité des données – Des validations et des confirmations puissantes avant et après le chargement des données qui garantissent que les bonnes données sont disponibles à chaque étape du processus.

- Transparence accrue – Transparence à 100 % et pistes d'audit pour les données, les métadonnées et la visibilité des modifications de processus, du rapport à la source.

Conclusion

Les gremlins de données peuvent perturber les opérations commerciales et entraîner de graves implications commerciales, ce qui rend essentiel pour les organisations de contrôler leurs processus de gestion des données avant l'émergence de gremlins de données. En développant une stratégie de gestion des données, en investissant dans des systèmes de gestion des données robustes, en effectuant des audits réguliers des données, en formant les employés aux meilleures pratiques de gestion des données et en disposant d'un plan de reprise après sinistre, les organisations peuvent prévenir les problèmes liés aux données et assurer la continuité des activités.

En savoir plus

Pour en savoir plus sur la façon dont les organisations sortent de leurs gremlins de données, téléchargez notre livre blanc intitulé "Unifiez la planification connectée ou faites face aux coûts cachés. »

L'apprentissage automatique (ML) a le potentiel de révolutionner la gestion des performances d'entreprise (EPM) en fournissant aux organisations des informations en temps réel et des capacités prédictives à travers les processus de planification et de prévision. Avec la capacité de traiter de grandes quantités de données, les algorithmes ML peuvent aider les organisations à identifier des modèles, des tendances et des relations qui passeraient autrement inaperçus. Et à mesure que la technologie continue d'évoluer et de s'améliorer, des avantages encore plus importants sont susceptibles d'émerger à l'avenir, car la finance exploite la puissance du ML pour atteindre ses objectifs financiers.

Rejoignez-nous alors que nous examinons Sensible ML pour EPM - L'avenir de la finance au bout des doigts.

Le passage à la finance intelligente

Pour les directeurs financiers, il n'est plus question de savoir si l'intelligence artificielle (IA) et le ML joueront un rôle dans les processus de planification d'entreprise. Aujourd'hui, la question se concentre plutôt sur la façon d'opérationnaliser le ML de manière à obtenir des résultats et une échelle optimaux. La réponse est là où les choses se compliquent.

Pourquoi ? L'agilité commerciale est essentielle dans le monde en évolution rapide de la planification. Pour penser vite et agir en premier, les organisations doivent surmonter des défis couvrant la nécessité de développer rapidement l'activité, de prévoir avec précision la demande future, d'anticiper les circonstances imprévues du marché et plus encore. Pourtant, les volumes croissants de données dans l'ensemble de l'organisation rendent difficile pour les décideurs de se concentrer sur les données nécessaires et d'extrapoler les informations appropriées pour avoir un impact positif sur les cycles de planification et les résultats. Pour aggraver encore le problème, de nombreux processus et outils d'analyse avancés n'exploitent que des données historiques de haut niveau, obligeant les décideurs à refaire des prévisions à partir de zéro chaque fois que des changements imprévisibles du marché se produisent.

Mais avec l'IA et le ML, les analystes métier peuvent analyser et corréler les variables internes/externes les plus pertinentes. Et les variables contribuent ensuite à la précision et aux performances des prévisions dans les processus de vente, de chaîne d'approvisionnement, de RH et de marketing qui comprennent les plans et les résultats financiers.

Ces dynamiques soulignent pourquoi le moment est venu pour la finance intelligente.

Au cours des prochaines semaines, nous partagerons un blogue série discutant de la voie vers une planification intelligente alimentée par ML. Voici un aperçu des sujets clés de notre série Sensible ML for EPM :

- 1 partie: 4 forces motrices du changement. Ces forces ont le potentiel d'accélérer le ML et d'éloigner les organisations de l'analyse descriptive et diagnostique (expliquant ce qui s'est passé et pourquoi) vers l'analyse prédictive et prescriptive.

- Partie 2 : Augmenter la précision et la transparence. Aujourd'hui plus que jamais, les organisations cherchent à devenir plus agiles, précises et transparentes dans leurs plans financiers pour rester compétitives. Et Sensible ML peut vous aider. Il permet aux utilisateurs plus proches de l'entreprise d'intégrer l'intuition commerciale dans le modèle, ce qui peut augmenter la précision et garantir que toutes les informations disponibles sont prises en compte. (voir schéma 1)

- Partie 3 : Capacités clés pour une planification intelligente. Sensible ML est différent de « la plupart » des capacités de prévision de l'analyse prédictive (examen des résultats et des statistiques antérieurs et génération de prévisions basées sur ce qui s'est passé dans le passé). Spécifiquement, ML senséa la capacité non seulement d'examiner les résultats antérieurs, mais également de prendre en compte des intuitions commerciales supplémentaires - telles que les événements, les prix, les informations sur la concurrence et la météo - pour aider à générer des prévisions plus précises/robustes.

- Partie 4 : Témoignages de clients. Chaque client doit être une référence et une réussite. L'énoncé de mission de OneStream guide tout ce que nous faisons. Examiner de plus près les clients qui ont tiré parti de l'exploitation de Sensible ML peut aider toute organisation à obtenir de véritables informations prédictives.

Où que vous en soyez dans votre parcours financier, notre série Sensible ML for EPM est conçue pour partager les informations issues de l'expérience de l'équipe d'experts du secteur de OneStream. Nous reconnaissons, bien sûr, que chaque organisation est unique - veuillez donc évaluer ce qui est le plus important pour vous en fonction des besoins spécifiques de votre organisation.

Conclusion

L'aspiration des plans propulsés par ML n'est pas nouvelle. Mais pour rester compétitifs face au rythme croissant des changements et des perturbations technologiques, les responsables financiers doivent penser différemment pour enfin vaincre les complexités inhérentes à la planification d'entreprise traditionnelle. Le ML a le potentiel d'améliorer considérablement l'EPM en fournissant aux organisations des informations en temps réel et des analyses prédictives. Cependant, les organisations doivent surmonter des défis (par exemple, assurer une bonne qualité des données et sélectionner le bon algorithme ML) pour réussir. Alors que le ML continue d'évoluer, de plus en plus d'organisations sont susceptibles de tirer parti de sa puissance pour obtenir de meilleurs résultats financiers et opérationnels.

Plusieurs défis attendent les organisations de toutes tailles, mais l'une des décisions les plus importantes sera de mettre en œuvre la bonne solution ML - une solution capable d'aligner efficacement tous les aspects de et la planification de votre patrimoine et élever l'organisation vers ses objectifs stratégiques. Sensible ML répond à cet appel. Il apporte puissance et sophistication aux organisations pour favoriser la transparence et augmenter la vitesse des processus de prévision avec une transparence et un alignement sans précédent sur les performances de l'entreprise.

En savoir plus

Pour en savoir plus sur la valeur de Sensible ML, téléchargez notre livre blanc intitulé "Le Sensible Machine Learning au service de l’EPM" en cliquant ici. Et n'oubliez pas de vous connecter pour d'autres articles de notre série de blogs sur l'apprentissage automatique !

Aujourd'hui, la confiance dans la qualité des données est plus que jamais nécessaire. Les dirigeants doivent constamment réagir à une multitude de changements et recevoir des données précises et opportunes pour prendre les bonnes décisions sur les mesures à prendre. Il est donc plus important que jamais que les organisations aient une stratégie claire pour la gestion continue de la qualité des données financières (FDQM). Pourquoi? Eh bien, de meilleurs résultats résultent de meilleures décisions. Et des données de haute qualité donnent aux organisations la confiance nécessaire pour bien faire les choses. Cette confiance dans les données conduit finalement à de meilleures performances et réduit les risques.

Pourquoi la qualité des données est-elle importante ?

La qualité des données est importante pour plusieurs raisons essentielles, comme le montrent les recherches. Selon Gartner[1], la mauvaise qualité des données coûte aux entreprises en moyenne 12.9 millions de dollars par an. Ces coûts s'accumulent non seulement en raison du temps perdu des ressources dans les processus financiers et opérationnels, mais aussi - et plus important encore - des opportunités de revenus manquées.

Alors que les organisations se tournent vers une meilleure technologie pour aider à prendre une meilleure direction future, l'accent mis sur la gestion de la qualité des données financières dans les systèmes d'entreprise n'a fait qu'augmenter. Gartner a également prédit que, d'ici 2022, 70 % des organisations suivraient rigoureusement les niveaux de qualité des données via des métriques, améliorant la qualité de 60 % pour réduire considérablement les risques et les coûts opérationnels.

Dans un rapport sur la réduction de l'écart entre les données et la valeur, Accenture[2] a déclaré que "sans confiance dans les données, les organisations ne peuvent pas construire une base de données solide". Selon le rapport, seulement un tiers des entreprises font suffisamment confiance à leurs données pour les utiliser efficacement et en tirer de la valeur.

En bref, l'importance de la qualité des données devient de plus en plus claire pour de nombreuses organisations, créant ainsi un argument convaincant en faveur d'un changement de rapport financier évaluations de logiciels. Il y a maintenant un réel élan pour briser les barrières historiques et aller de l'avant avec une confiance renouvelée.

Éliminer les obstacles à la qualité des données

La gestion de la qualité des données financières a été difficile, voire pratiquement impossible à réaliser pour de nombreuses organisations. Pourquoi? Eh bien, dans de nombreux cas, les anciens systèmes de gestion des performances d'entreprise (CPM) et ERP n'étaient tout simplement pas conçus pour fonctionner ensemble naturellement et avaient plutôt tendance à rester séparés en tant qu'applications cloisonnées, chacune ayant son propre objectif. Il existe peu ou pas de connectivité entre les systèmes, de sorte que les utilisateurs sont souvent obligés de recourir à la récupération manuelle des données d'un système, à la transformation manuelle des données, puis à leur chargement dans un autre système, ce qui prend beaucoup de temps et risque de réduire la qualité des données.

Il y a aussi souvent un manque de contrôles front-office qui entraîne une foule de problèmes :

- Mauvaise saisie des données et validation limitée.

- Architecture de données inefficace avec plusieurs systèmes informatiques hérités.

- Manque de soutien commercial pour la valeur de la transformation des données.

- Une attention inadéquate au niveau de la direction empêche une organisation de jeter les bases efficaces pour qualité des données financières.

Tout cela contribue à des obstacles importants à la garantie d'une bonne qualité des données. Voici les 3 principaux obstacles :

- Plusieurs systèmes déconnectés – Les systèmes multiples et les applications cloisonnées rendent difficile la fusion, l'agrégation et la normalisation des données en temps opportun. Des systèmes individuels sont ajoutés à des moments différents, utilisant souvent une technologie différente et des structures dimensionnelles différentes.

- Données de mauvaise qualité – Les données des systèmes sources sont souvent incomplètes, incohérentes ou obsolètes. De plus, de nombreuses méthodes d'intégration copient simplement les données complètes avec toutes les erreurs existantes - sans aucune validation ni gouvernance.

- Adhésion de l'exécutif – Le fait de ne pas obtenir l'adhésion de la direction peut être dû à la perception ou à l'approche. Après tout, une stratégie efficace de qualité des données nécessite de la concentration et des investissements. Avec autant de projets concurrents dans toute organisation, les arguments en faveur d'une stratégie doivent être convaincants et démontrer efficacement la valeur que la qualité des données peut apporter.

Pourtant, même lorsque ces obstacles sont reconnus, amener les équipes des finances et des opérations à abandonner leurs outils logiciels de reporting financier et leurs méthodes de travail traditionnelles peut être extrêmement difficile. Les obstacles, cependant, ne sont souvent pas aussi difficiles à surmonter que certains le croient.

La solution peut être aussi simple que de démontrer combien de temps peut être économisé en passant à de nouveaux outils et technologies. Grâce à de telles transitions, la réduction de l'investissement en temps peut se traduire par une amélioration spectaculaire de la qualité de la données grâce à une intégration efficace avec validation et contrôle intégrés au système lui-même.

La solution

Certains pensent que la loi de Pareto s'applique à la qualité des données : en règle générale, 20 % des données permettent 80 % des cas d'utilisation. Il est donc essentiel qu'une organisation suive ces 3 étapes avant de se lancer dans tout projet d'amélioration de la qualité des données financières :

- Définir la qualité – Déterminez ce que la qualité signifie pour l'organisation, mettez-vous d'accord sur la définition et définissez des mesures pour atteindre le niveau avec lequel tout le monde se sentira en confiance.

- Rationalisez la collecte de données – Assurez-vous que le nombre de systèmes disparates est minimisé et que les intégrations utilisent une technologie de classe mondiale avec cohérence avec les processus de collecte de données.

- Identifier l'importance des données – Sachez quelles données sont les plus critiques pour l'organisation et commencez par là – avec les 20 %. Passez ensuite à autre chose lorsque l'organisation est prête.

À la base, un système entièrement intégré Plateforme logicielle CPM avec intégré La qualité des données financières (voir Figure 1) est essentielle pour que les organisations conduisent une transformation efficace dans l'ensemble des finances et des secteurs d'activité. Une exigence clé est de fournir une visibilité à 100 % des rapports aux sources de données, ce qui signifie que toutes les données financières et opérationnelles doivent être clairement visibles et facilement accessibles. Les processus financiers clés doivent être automatisés et l'utilisation d'une interface unique signifie que l'entreprise peut utiliser ses données financières et opérationnelles de base avec une intégration complète à tous les ERP et autres systèmes.

La solution doit également inclure des flux de travail guidés pour protéger les utilisateurs professionnels de la complexité en les guidant de manière unique à travers tous les processus de gestion, de vérification, d'analyse, de certification et de verrouillage des données.

OneStream offre tout cela et plus encore. Avec une base solide en matière de qualité des données financières, OneStream permet aux organisations d'intégrer et de valider des données provenant de plusieurs sources et de prendre des décisions en toute confiance sur la base de résultats financiers et opérationnels précis. La gestion de la qualité des données financières de OneStream n'est pas un module ou un produit distinct, mais intégré dans le cœur de la plate-forme OneStream - fournissant des contrôles stricts pour offrir la confiance et la fiabilité nécessaires pour garantir des données de qualité.

Dans notre livre électronique sur Mise en qualité des données financières , nous avons partagé les 3 objectifs suivants pour une gestion efficace de la qualité des données financières avec CPM :

- Simplifiez l'intégration des données – Intégration directe à n'importe quel système GL/ERP ouvert et permettre aux utilisateurs d'accéder aux données sources.

- Améliorer l'intégrité des données – Des validations et confirmations puissantes avant et après le chargement des données garantissent que les bonnes données sont disponibles à chaque étape du processus.

- Augmenter la transparence – 100 % de transparence et pistes d'audit pour les données, les métadonnées et la visibilité des modifications de processus, du rapport à la source.

La clé du succès de nos clients

Voici un exemple d'une organisation qui a rationalisé la collecte de données et amélioré la qualité des données dans le processus de clôture financière, de consolidation et de reporting en exploitant la plate-forme unifiée de OneStream.

MEC Holding GmbH – dont le siège est à Bad Soden, en Allemagne – fabrique et fournit des consommables et des services de soudage industriels, des systèmes de coupage et des instruments médicaux pour les équipementiers en Allemagne et à l'étranger. La société opère à travers trois unités : Castolin Eutectic Systems, Messer Cutting Systems et BIT Analytical Instruments.

MEC compte 36 pays faisant des rapports mensuels, dont plus de 70 entités et 15 devises locales, de sorte que le processus de consolidation financière et de reporting comprend un volume élevé d'activités interentreprises. Avec OneStream, la collecte de données est désormais beaucoup plus facile grâce aux flux de travail guidés qui guident les utilisateurs tout au long de leurs tâches. Les utilisateurs téléchargent eux-mêmes les balances de vérification au lieu de les envoyer à l'entreprise, ce qui accélère le processus et garantit la qualité des données. De plus, le nouveau système était très facile à apprendre et à adopter pour les utilisateurs avec une formation limitée.

MEC a constaté que la confiance d'avoir « une version de la vérité » est tout à fait possible avec OneStream.

En savoir plus

Si votre organisation financière est empêchée de libérer sa véritable valeur, il est peut-être temps d'évaluer vos systèmes et processus internes et de commencer à identifier les domaines à améliorer. Pour savoir comment, lisez notre livre blanc sur la conquête de la complexité dans la clôture financière.

La gestion de la qualité des données financières (FDQM) a souvent été développée comme une simple réflexion après coup ou présentée comme une simple option par la plupart des fournisseurs de gestion de la performance d'entreprise (CPM). En réalité, il devrait être le fondement de tout système CPM. Pourquoi? Eh bien, disposer de capacités FDQM robustes réduit non seulement les erreurs et leurs conséquences, mais également les temps d'arrêt causés par les interruptions de processus et les coûts associés à l'inefficacité.

Avoir un FDQM efficace signifie fournir des contrôles d'audit stricts ainsi que des processus standard, définis et reproductibles pour une confiance et une fiabilité maximales dans tout processus utilisateur professionnel. Un FDQM efficace permet également à une organisation de raccourcir les cycles de clôture financière et de budgétisation et de fournir des informations critiques aux utilisateurs finaux plus rapidement et plus facilement.

Continuant notre Réimaginer le blog de fermeture série ici, nous examinons pourquoi la gestion de la qualité des données financières est une exigence essentielle dans l'environnement de reporting d'entreprise d'aujourd'hui. Une mauvaise qualité des données peut entraîner des erreurs ou des omissions dans les états financiers, ce qui entraîne souvent des pénalités de conformité, une perte de confiance des parties prenantes et potentiellement une réduction de la valeur marchande.

Intérêt croissant pour la gestion de la qualité des données financières

Les organisations réalisent maintenant que la FDQM est essentielle. Pourquoi? Les équipes financières doivent s'assurer non seulement que les rapports financiers sont diffusés avec précision, mais également que toutes les données et orientations prospectives sont pleinement étayées par des résultats réels de « qualité ».

Une vieille expression utilisée autour de l'information financière capture bien cette idée : « si vous mettez des ordures dedans, vous en sortez.

Un manque de capacités d'intégration de données robustes crée une multitude de problèmes. En voici quelques-uns :

- Des étapes manuelles qui gaspillent des ressources et du temps

- Risque d'erreurs

- Mauvaises décisions financières

- Manque de traçabilité

- Manque d'auditabilité

Dans de nombreux cas, les systèmes CPM et ERP existants n'étaient tout simplement pas conçus pour fonctionner ensemble naturellement et ont tendance à rester séparés en tant qu'applications en silos, chacune ayant son propre objectif. Souvent, il existe peu ou pas de connectivité entre les systèmes, et les utilisateurs sont obligés de recourir à la récupération manuelle des données d'un système, à la transformation manuelle des données, puis à leur chargement dans un autre système.

Alors que les organisations deviennent de plus en plus complexes et que les volumes de données augmentent de plus en plus, il est naturel de porter attention à la qualité des données saisies. Sans oublier que, à mesure que des capacités plus avancées sont explorées et adoptées, telles que l'intelligence artificielle (IA) et l'apprentissage automatique (ML), les organisations sont obligées d'examiner d'abord leurs données, puis de prendre des mesures pour garantir une qualité efficace des données. Pourquoi ces étapes sont-elles nécessaires ? En termes simples, les meilleurs résultats de l'IA, du ML et d'autres technologies avancées dépendent entièrement de données de bonne qualité et propres dès le départ.

Quelle est la solution?

Une plate-forme CPM/EPM entièrement intégrée avec FDQM en son cœur est essentielle pour que les organisations mènent une transformation efficace dans la finance et les secteurs d'activité. Une exigence clé est une visibilité à 100 % des rapports aux sources – toutes les données financières et opérationnelles doivent être clairement visibles et facilement accessibles. Les processus financiers clés doivent être automatisés et l'utilisation d'une interface unique signifierait que l'entreprise peut utiliser ses données financières et opérationnelles de base avec une intégration complète à tous les ERP et autres systèmes.

La solution doit également inclure des workflows guidés pour protéger les utilisateurs métier de la complexité en les guidant de manière unique à travers tous les processus de gestion, de vérification, d'analyse, de certification et de verrouillage des données.

Les utilisateurs doivent être en mesure d'obtenir un FDQM et une vérification efficaces grâce à une collecte et à une analyse de données normalisées et simplifiées avec des rapports à chaque étape du flux de travail. Les flux de travail doivent être guidés pour fournir des processus standard, définis et reproductibles pour une confiance et une fiabilité maximales dans un processus métier piloté par les utilisateurs. Quel est le résultat final ? La simplification des processus métier et la réduction des erreurs et des inefficacités dans l'ensemble de l'entreprise.

Pourquoi OneStream ?

Les bases solides de OneStream dans l'arène FDQM permettent une flexibilité et une visibilité inégalées dans le processus de chargement et d'intégration des données.

de OneStream Mise en qualité des données financières n'est pas un module ou un produit séparé, mais fait partie intégrante de la plate-forme unifiée de OneStream - fournissant des contrôles stricts pour garantir la confiance et la fiabilité de la qualité de vos données. Comment? Le risque lié à la qualité des données financières est géré à l'aide de cartes d'intégration système entièrement vérifiables, et des validations sont utilisées pour contrôler les soumissions à partir de sites distants. Les données peuvent être chargées via des connexions directes aux bases de données source ou via n'importe quel format de fichier. Les rapports d'audit peuvent être filtrés en fonction de seuils d'importance relative, ce qui garantit des examens ponctuels aux étapes appropriées du processus.

Essentiellement, la plate-forme unifiée de OneStream offre des capacités d'intégration de données de pointe avec des connexions transparentes à plusieurs sources.

Les connecteurs d'intégration OneStream offrent une intégration directe avec n'importe quel GL/ERP ouvert ou d'autres systèmes source, offrant les avantages suivants :

- Fournit des processus d'intégration de système directs à la source rapides et efficaces avec l'automatisation des processus robotiques (RPA) intégrée.

- Exploration en avant, en arrière et en amont jusqu'aux détails des transactions, y compris les écritures de journal.

- Fournit une intégration directe avec un retour en arrière sur plus de 250 systèmes ERP, HCM, CRM et autres (par exemple, Oracle, PeopleSoft, JDE, SAP, Infor, Microsoft AX/Dynamics, etc.).

100% de réussite client

Assurance-vie AAA mis en œuvre OneStream pour répondre à tous leurs besoins en matière de consolidation financière, de reporting, de budgétisation et d'analyse. Depuis, AAA Life a rationalisé le processus de clôture financière et a considérablement amélioré non seulement la visibilité des données, mais également la transparence des résultats. Ils peuvent désormais explorer les chiffres calculés ou consolidés de OneStream jusqu'au système ERP transactionnel pour obtenir des réponses rapides aux questions critiques.

Le rêve d'une « version unique de la vérité » est tout à fait possible avec OneStream.

En savoir plus

Pour en savoir plus sur la façon dont vous pouvez repenser la clôture financière avec la puissance inégalée de la plateforme financière intelligente de OneStream, téléchargez notre livre blanc. Et n'oubliez pas de vous connecter pour d'autres articles de notre série de blogs Re-Imagining the Financial Close.

Les directeurs financiers et les contrôleurs d'aujourd'hui doivent gérer leurs données et processus financiers critiques à l'échelle de l'entreprise aussi efficacement que possible. Ces données doivent être opportunes, précises et facilement accessibles pour des rapports et des analyses perspicaces afin de maintenir un avantage concurrentiel. Par conséquent, leurs solutions de gestion des performances d'entreprise (CPM) doivent être robustes, évolutives et s'intégrer pleinement à leurs systèmes ERP, HCM, CRM et autres.

Que vous recherchiez une solution EPM ou que vous cherchiez à passer à une nouvelle solution, la capacité d'exploration en amont de OneStream est la fonctionnalité dont vous n'aviez jamais pensé avoir besoin.

De nombreux fournisseurs prétendent gérer des consolidations complexes, mais il existe plusieurs différences significatives entre le moteur sous-jacent nécessaire pour exécuter agrégation de données financières et le moteur utilisé pour exécuter l'agrégation directe ou les consolidations simples. Tout fournisseur qui utilise Microsoft Analysis Services, Oracle Essbase, Cognos, TM1, SAP Hanna ou un moteur d'agrégation simple similaire devra relever de nombreux défis pour relever consolidation financière exigences. Examinons cela de plus près.