Heutzutage ist das Vertrauen in die Datenqualität von entscheidender Bedeutung, da Hochschulleiter auf verschiedene politische und wirtschaftliche Zwänge reagieren müssen. Auch Hochschulen und Universitäten stehen unter der Lupe, um finanzielle Verantwortung zu gewährleisten und gleichzeitig den Studierenden bestmöglich zu dienen. Höhere Finanzteams benötigen heute mehr denn je vertrauenswürdige, genaue und aktuelle Daten, um für jede Schule die richtigen Entscheidungen zu treffen.

Universitätsvorstände fordern die Institutionen außerdem auf, für mehr Transparenz und Rechenschaftspflicht zu sorgen. Diese Forderung bedeutet, dass eine klare Strategie für ein kontinuierliches, robustes Datenqualitätsmanagement wichtiger denn je ist. Warum? Bessere Entscheidungen führen zu besseren Ergebnissen. Und hochwertige Daten geben Institutionen das Vertrauen in die Daten, um richtige Entscheidungen zu treffen – was wiederum zu einer besseren Unterstützung der Studierenden, genaueren Ergebnissen und einem geringeren Risiko führt.

Warum ist Datenqualität wichtig?

Untersuchungen haben gezeigt, dass Datenqualität ist wichtig. Gemäß FensterFast neun von zehn Organisationen (10 %) gaben an, dass Datenqualitätsprobleme ein schwerwiegendes oder sehr schwerwiegendes Hindernis für ihr Unternehmen darstellten. Die Auswirkungen führen zu einem Mangel an Vertrauen in die Daten und zur Verschwendung von Ressourcenzeit bei Finanz- und Betriebsprozessen.

Tatsächlich streben viele Institutionen danach, stärker datengesteuert zu werden. Entsprechend Die Chronik der Hochschulbildung97 % der befragten Hochschulverwalter glauben, dass die Hochschulbildung Daten und Analysen besser nutzen muss, um strategische Entscheidungen zu treffen.

Da Institutionen immer komplexer werden, wächst auch die Notwendigkeit, sich auf die Datenqualität zu konzentrieren. Gemäß dem Sprichwort „Müll rein, Müll raus“ (siehe Abbildung 1) ist die Schaffung einer soliden Grundlage verwalteter Daten für eine datengesteuerte Entscheidungsfindung unerlässlich. Um die Teams aufeinander abzustimmen, ist es unerlässlich, in der gesamten Einrichtung eine Quelle vertrauenswürdiger Daten zu haben, auf die verwiesen werden kann.

Was verhindert eine gute Datenqualität?

In vielen Fällen sind Institutionen mit den Einschränkungen getrennter Finanzprozesse, veralteter Systeme und ineffizienter Analysetools konfrontiert. Dieser bürokratische Aufwand hat zu mangelnder Agilität, umständlichen Prozessen und isolierten Entscheidungen geführt. Vereinfacht gesagt sind die vorhandenen Lösungen nicht darauf ausgelegt, zusammenzuarbeiten, was das Datenqualitätsmanagement erschwert.

Zwischen den Systemen besteht oft nur eine geringe oder gar keine Konnektivität, sodass Benutzer Daten manuell von einem System abrufen, die Daten manuell umwandeln und sie dann in ein anderes System laden müssen, ohne dass eine Rückverfolgbarkeit entsteht. Dieser Mangel an robusten Datenqualitätsfunktionen führt zu einer Vielzahl von Problemen. Hier sind nur einige davon:

- Schlechte Dateneingabe mit eingeschränkter Validierung, was das Vertrauen in die Zahlen beeinträchtigt.

- Eine hohe Anzahl manueller Aufgaben führt zu einer Verschlechterung der Gesamtdatenqualität und erhöhter Latenz bei den Prozessen.

- Keine Datenherkunft, was Drill-Down- und Drill-Back-Funktionen verhindert und zusätzlichen Zeit- und manuellen Aufwand beim Zugriff auf umsetzbare Informationen für jede Zahl verursacht.

Das Lösung für getrennte Systeme kann so einfach sein wie der Umstieg auf neuere Tools und Technologien. Warum? Im Vergleich zu früheren Lösungen verfügen sie über eine effektivere Integration sowie eine integrierte Validierung und Kontrolle, was Zeit spart und manuelle Aufgaben überflüssig macht.

Was ist die Lösung?

Einige glauben, dass das Pareto-Gesetz – dass 20 % der Daten 80 % der Anwendungsfälle ermöglichen – für die Datenqualität gilt. Daher müssen Institute drei Schritte unternehmen, bevor sie ein Projekt zur Verbesserung der Qualität von Finanzdaten annehmen:

- Qualität definieren: Bestimmen Sie, was Qualität für die Hochschule oder Universität bedeutet, einigen Sie sich auf die Definition und legen Sie Maßstäbe fest, um das Niveau zu erreichen, mit dem sich alle sicher fühlen.

- Optimieren Sie die Datenerfassung: Stellen Sie sicher, dass die Anzahl unterschiedlicher Systeme minimiert wird und die Integrationen erstklassige Technologie mit Konsistenz in den Datenintegrationsprozessen nutzen.

- Identifizieren Sie die Bedeutung von Daten: Wissen Sie, welche Daten für das Unternehmen am kritischsten sind, und beginnen Sie dort – mit den 20 % – und fahren Sie erst fort, wenn das Unternehmen dazu bereit ist.

Im Kern ein voll integriertes Finanzplattform wie OneStream mit integrierten Finanzdaten ist für Hochschulen von entscheidender Bedeutung, um eine effektive Transformation im Finanzwesen sowie in verschiedenen Funktionen und Diensten voranzutreiben. Welche zentralen Anforderungen sollten berücksichtigt werden? Hier sind einige Schlüsselfunktionen:

- 100 % Transparenz von Berichten bis hin zu Datenquellen, sodass alle Finanz- und Betriebsdaten sichtbar und leicht zugänglich sind.

- Eine Quelle der Wahrheit für alle Finanz- und Betriebsdaten.

- Geführte Arbeitsabläufe, um Benutzer vor Komplexität und manuellen Versehen zu schützen.

Warum OneStream für Datenqualitätsmanagement?

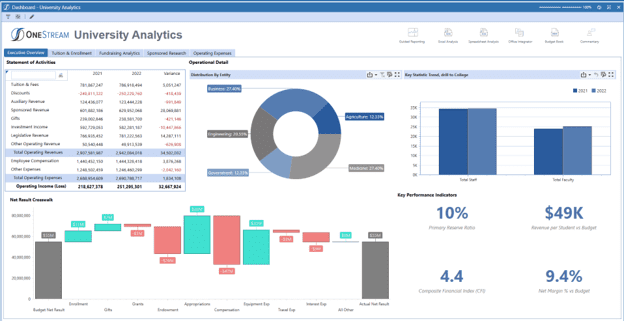

Die einheitliche Plattform von OneStream bietet marktführende Datenintegrationsfunktionen mit nahtlosen Verbindungen zu mehreren Quellen, einschließlich Finanz-, Personal- und Studentensystemen. Diese Funktionen bieten beispiellose Flexibilität und Einblick in den Datenlade- und Integrationsprozess.

OneStreams Datenqualitätsmanagement ist ein zentraler Bestandteil der einheitlichen Plattform von OneStream (siehe Abbildung 2). Durch die Bereitstellung strenger Kontrollen zur Schaffung von Vertrauen und Zuverlässigkeit in der Datenqualität ermöglicht die Plattform Unternehmen Folgendes:

- Verwalten Sie Datenqualitätsrisiken mithilfe vollständig überprüfbarer Integrationskarten und Validierungen in jeder Phase des Prozesses, von der Integration bis zur Berichterstellung.

- Automatisieren Sie Daten über direkte Verbindungen zu Quelldatenbanken oder über ein beliebiges zeichenbasiertes Dateiformat.

- Filtern Sie Prüfberichte nach Wesentlichkeitsschwellenwerten und stellen Sie so einmalige Überprüfungen an geeigneten Stellen im Prozess sicher.

- Möglichkeit zum Drilldown, Drillback und Drillthrough zu Transaktionsdetails für eine vollständige Rückverfolgbarkeit jeder Zahl.

Zusammenfassung

Anforderungen an Genauigkeit, Transparenz und Vertrauen sind in der Finanz- und Betriebsberichterstattung, -analyse und -planung angesichts des Detaillierungsniveaus, das zur Führung von Institutionen erforderlich ist, allgegenwärtig. Dementsprechend sollten Universitäten, die eine Strategie zur Verbesserung des Datenqualitätsmanagements entwickeln möchten, eine CPM-Softwareplattform mit integrierter Finanzdatenqualität in Betracht ziehen, um genauere Ergebnisse zu erzielen und Risiken zu reduzieren.

Mehr erfahren

Erfahren Sie mehr darüber, wie OneStream eine bessere Datenqualität erzielen und die Genauigkeit der Finanzergebnisse für die Hochschulbildung verbessern kann.

Mehr erfahrenHeutzutage ist Vertrauen in die Datenqualität von entscheidender Bedeutung. Anforderungen an Genauigkeit und Vertrauen sind in der finanziellen und betrieblichen Berichterstattung, Analyse und Planung angesichts des Detaillierungsniveaus, das zur Steuerung des Unternehmens erforderlich ist, allgegenwärtig. Das Wachstum der künstlichen Intelligenz (KI) und des maschinellen Lernens (ML) erfordert auch qualitativ hochwertige Daten auf granularer Ebene. Angesichts dieser Forderungen Das alte Sprichwort „Müll rein, Müll raus“ gilt heute mehr denn je.

Führungskräfte müssen ständig auf verschiedene – und sich weiterentwickelnde – Veränderungen reagieren und benötigen daher vertrauenswürdige, genaue und aktuelle Daten, um die richtigen Entscheidungen hinsichtlich aller erforderlichen Maßnahmen zu treffen. Daher müssen moderne Organisationen über eine klare Strategie für ein kontinuierliches, robustes Datenqualitätsmanagement verfügen. Warum? Nun, bessere Entscheidungen führen zu besseren Ergebnissen. Und hochwertige Daten geben Unternehmen das Vertrauen in Daten, um richtige Entscheidungen zu treffen und so eine bessere Leistung, genauere Ergebnisse und ein geringeres Risiko zu erzielen.

Warum ist Datenqualität wichtig?

Datenqualität ist wichtig, wie Untersuchungen zeigen. Entsprechend FensterFast neun von zehn Organisationen (10 %) gaben an, dass Datenqualitätsprobleme ein schwerwiegendes oder sehr schwerwiegendes Hindernis darstellten. Diese Auswirkungen führen zu einem Mangel an Vertrauen in die Daten und zur Verschwendung von Ressourcenzeit bei Finanz- und Betriebsprozessen.

Da Unternehmen auf modernere Technologien zurückgreifen, um künftig bessere Wege zu gehen, hat der Schwerpunkt auf dem Datenqualitätsmanagement in Unternehmenssystemen nur noch zugenommen. In einem Bericht über Schließen der Daten-Wert-Lücke, Accenture sagte: „Ohne Vertrauen in Daten können Unternehmen keine starke Datenbasis aufbauen.“ Dem Bericht zufolge vertrauen nur ein Drittel der Unternehmen ihren Daten ausreichend, um sie effektiv zur Wertschöpfung zu nutzen.

Kurz gesagt, die Bedeutung der Datenqualität wird immer deutlicher. Da Organisationen immer komplexer werden und die Datenmengen immer größer werden, verlagert sich die Aufmerksamkeit natürlich auf die Qualität der verwendeten Daten. Ganz zu schweigen davon, dass Unternehmen bei der Erforschung und Einführung fortschrittlicherer Funktionen wie KI und ML zunächst ihre Daten untersuchen und dann Maßnahmen ergreifen müssen, um eine effektive Datenqualität sicherzustellen. Warum sind diese Schritte notwendig? Einfach ausgedrückt: Die besten Ergebnisse von KI, ML und anderen fortschrittlichen Technologien hängen von Anfang an vollständig von guten, sauberen und qualitativ hochwertigen Daten ab.

Was verhindert eine gute Datenqualität?

In vielen Fällen waren alte CPM- und ERP-Systeme einfach nicht für die Zusammenarbeit konzipiert, was das Datenqualitätsmanagement erschwerte. Solche Systeme blieben in der Regel auch als isolierte Anwendungen mit jeweils eigenem Zweck bestehen. Zwischen den Systemen besteht häufig keine oder nur geringe Konnektivität, sodass Benutzer Daten manuell von einem System abrufen, manuell umwandeln und dann in ein anderes System laden müssen.

Dieser Mangel an robusten Datenqualitätsfunktionen führt zu einer Vielzahl von Problemen. Hier sind nur einige davon:

- Schlechte Dateneingabe mit eingeschränkter Validierung, was das Vertrauen in die Zahlen beeinträchtigt.

- Eine hohe Anzahl manueller Aufgaben führt zu einer Verschlechterung der Gesamtdatenqualität und erhöhter Latenz bei den Prozessen

- Keine Datenherkunft, wodurch Drill-Down- und Drill-Back-Funktionen verhindert werden und der Zugriff auf umsetzbare Informationen für jede Zahl mehr Zeit und manuellen Aufwand erfordert.

Die Lösung kann so einfach sein wie der Nachweis, wie viel Zeit durch den Umstieg auf neuere Tools und Technologien eingespart werden kann. Durch solche Übergänge kann die Reduzierung des Zeitaufwands die Qualität der Arbeit erheblich verbessern technische Daten durch effektive Integration mit in das System selbst integrierter Validierung und Kontrolle.

Was ist die Lösung?

Einige glauben, dass das Pareto-Gesetz – dass 20 % der Daten 80 % der Anwendungsfälle ermöglichen – für die Datenqualität gilt. Organisationen müssen daher drei Schritte unternehmen, bevor sie ein Projekt zur Verbesserung der Qualität von Finanzdaten annehmen:

- Qualität definieren – Bestimmen Sie, was Qualität für die Organisation bedeutet, vereinbaren Sie die Definition und legen Sie Kennzahlen fest, um das Niveau zu erreichen, bei dem sich alle sicher fühlen.

- Optimieren Sie die Datenerfassung – Stellen Sie sicher, dass die Anzahl unterschiedlicher Systeme minimiert wird und die Integrationen erstklassige Technologie mit Konsistenz in den Datenintegrationsprozessen nutzen.

- Identifizieren Sie die Bedeutung von Daten – Wissen Sie, welche Daten für das Unternehmen am kritischsten sind, und beginnen Sie dort – mit den 20 % – und fahren Sie erst fort, wenn das Unternehmen dazu bereit ist.

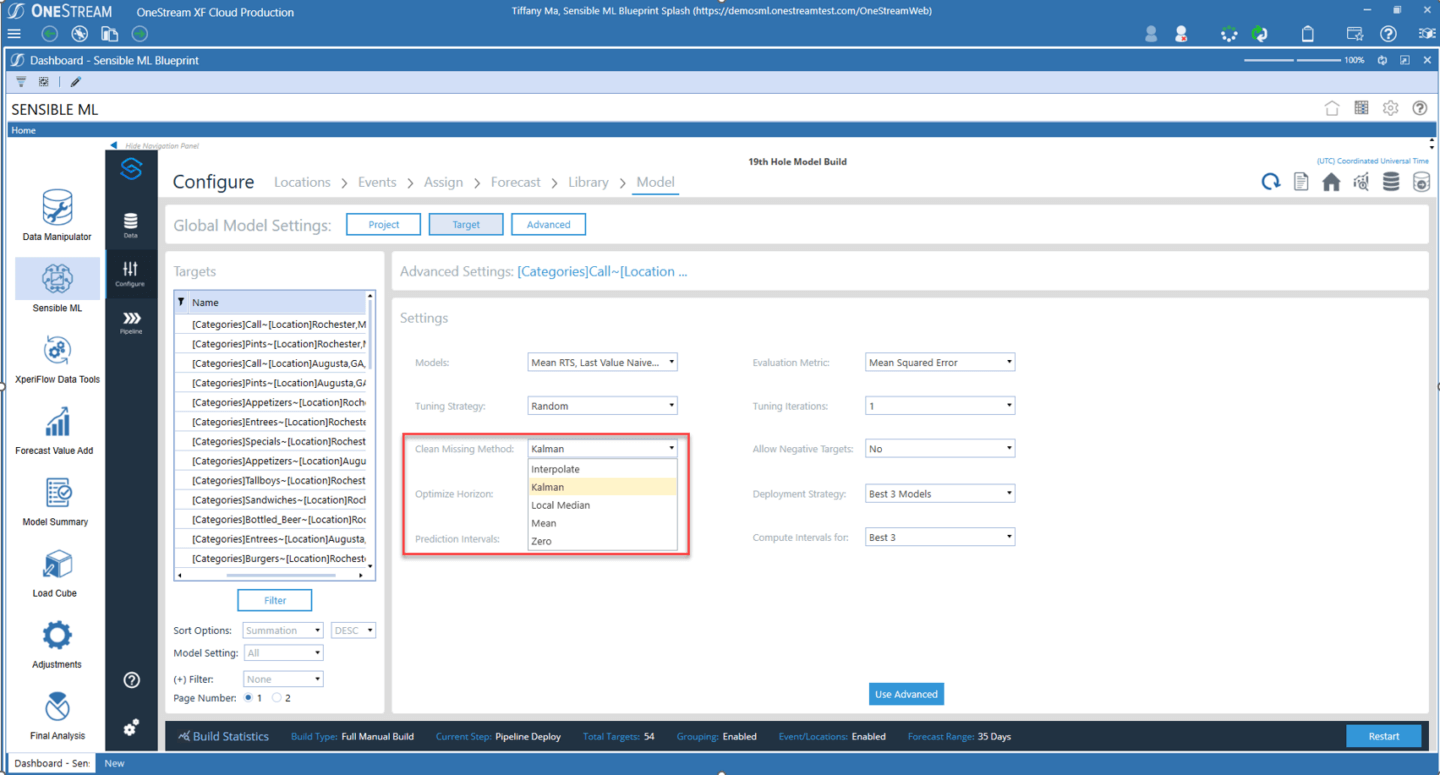

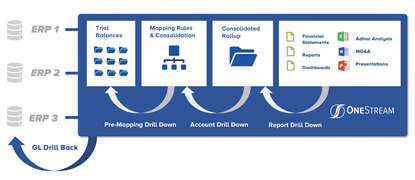

Im Kern ein voll integriertes CPM-Softwareplattform mit eingebaut Die Qualität der Finanzdaten (siehe Abbildung 1) ist für Unternehmen von entscheidender Bedeutung, um eine effektive Transformation im Finanz- und Geschäftsbereich voranzutreiben. Eine wichtige Anforderung ist die Bereitstellung einer 100-prozentigen Transparenz von Berichten bis hin zu Datenquellen – das bedeutet, dass alle Finanz- und Betriebsdaten klar sichtbar und leicht zugänglich sein müssen. Wichtige Finanzprozesse sollten automatisiert werden. Darüber hinaus würde die Verwendung einer einzigen Schnittstelle bedeuten, dass das Unternehmen seine wichtigsten Finanz- und Betriebsdaten mit vollständiger Integration in alle ERPs und anderen Systeme nutzen kann.

Abbildung 1: Integriertes Finanzdaten-Qualitätsmanagement in OneStream

Die Lösung sollte auch geführte Workflows beinhalten, um Geschäftsanwender vor Komplexität zu schützen. Wie? Indem wir sie auf einzigartige Weise durch alle Datenverwaltungs-, Verifizierungs-, Analyse-, Zertifizierungs- und Sperrprozesse führen.

Warum OneStream für Datenqualitätsmanagement?

Die einheitliche Plattform von OneStream bietet marktführende Datenintegrationsfunktionen mit nahtlosen Verbindungen zu mehreren Quellen. Diese Funktionen bieten beispiellose Flexibilität und Einblick in den Datenlade- und Integrationsprozess.

OneStreams Datenqualitätsmanagement ist kein Modul oder separates Produkt, sondern vielmehr ein Kernbestandteil der einheitlichen Plattform von OneStream. Die Plattform bietet strenge Kontrollen, um Vertrauen und Zuverlässigkeit in die Datenqualität zu schaffen, indem sie Unternehmen Folgendes ermöglicht:

- Verwalten Sie Datenqualitätsrisiken mithilfe vollständig überprüfbarer Integrationskarten und Validierungen in jeder Phase des Prozesses, von der Integration bis zur Berichterstellung.

- Automatisieren Sie Daten über direkte Verbindungen zu Quelldatenbanken oder über ein beliebiges zeichenbasiertes Dateiformat.

- Filtern Sie Prüfberichte nach Wesentlichkeitsschwellenwerten und stellen Sie so einmalige Überprüfungen an geeigneten Stellen im Prozess sicher.

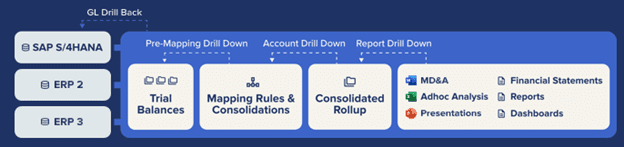

Das OneStream Integration Framework und vorgefertigte Konnektoren bieten eine direkte Integration mit jedem offenen GL/ERP- oder anderen Quellsystem (siehe Abbildung 1). Diese Fähigkeit bietet wichtige Vorteile:

- Schnelle, effiziente Direct-to-Source-Systemintegrationsprozesse.

- Möglichkeit zum Drilldown, Drillback und Drillthrough zu Transaktionsdetails für eine vollständige Rückverfolgbarkeit jeder Zahl.

- Direkte Integration mit Drillback zu über 250 ERP-, HCM-, CRM- und anderen Systemen (z. B. Oracle, PeopleSoft, JDE, SAP, Infor, Microsoft AX/Dynamics und mehr).

Wir liefern 100%igen Kundenerfolg

Hier ist ein Beispiel für eine Organisation, die die Datenintegration optimiert und die Datenqualität verbessert hat:

„Vor OneStream mussten wir uns mit den Projektdaten in allen einzelnen ERP-Systemen befassen“, sagte Joost van Kooten, Projektcontroller bei Huisman. „OneStream hilft dabei, unsere Daten überprüfbar und erweiterbar zu machen. Es ermöglicht uns, unser Geschäft zu verstehen und standardisierte Prozesse innerhalb eines globalen Systems zu schaffen. Wir vertrauen den Daten in OneStream, daher gibt es keine Meinungsverschiedenheiten über die Genauigkeit. Wir können uns auf den Vertrag konzentrieren und nicht auf die Korrektur der Daten.“

Wie alle OneStream-Kunden stellte Huisman fest, dass das Vertrauen, „eine Version der Wahrheit“ zu haben, mit OneStream durchaus möglich ist.

Mehr erfahren

Wenn Ihre Finanzorganisation daran gehindert wird, ihren wahren Wert zu entfalten, ist es vielleicht an der Zeit, Ihre internen Systeme und Prozesse zu bewerten und mit der Identifizierung von Verbesserungsmöglichkeiten zu beginnen. Um zu erfahren, wie das geht, lesen Sie unser Whitepaper Komplexität im Financial Close überwinden.

Lesen Sie das White PaperEinleitung

In der geschäftigen Welt der künstlichen Intelligenz (KI) bringt ein Sprichwort die Essenz der Arbeit perfekt auf den Punkt: „Müll rein, Müll raus.“ Warum? Dieses Mantra unterstreicht eine Wahrheit, die angesichts der Aufregung um neue Technologien und Algorithmen, die in FP&A-Teams zum Einsatz kommen, oft unterschätzt wird: Die Datenqualität ist ein entscheidender Faktor für den Erfolg oder Misserfolg jedes maschinellen Lernprojekts (ML).

Big Data, oft als „neues Öl“ bezeichnet, treibt die hochentwickelten ML-Engines an, die die Entscheidungsfindung branchen- und prozessübergreifend vorantreiben. Aber genauso wie ein echter Motor mit minderwertigem Kraftstoff nicht effektiv laufen kann, werden ML-Modelle, die auf Daten schlechter Qualität trainiert werden, zweifellos schlechtere Ergebnisse liefern. Mit anderen Worten: Damit sich KI in FP&A-Prozessen als erfolgreich erweist, ist die Datenqualität von entscheidender Bedeutung. Weitere Informationen finden Sie in unserem ersten Beitrag aus unserer Reihe „KI für FP&A“.

Die Bedeutung der Datenqualität verstehen

Datenwissenschaftler geben aus 50%-80% Sie verbringen viel Zeit damit, Daten zu sammeln, zu bereinigen und aufzubereiten, bevor sie zur Gewinnung wertvoller Erkenntnisse genutzt werden können. Diese Zeitinvestition ist ein Beweis dafür, warum „Müll rein, Müll raus“ keine Warnung, sondern eine Regel ist, nach der man im Bereich von KI und ML leben muss. Insbesondere für FP&A zeigt diese Regel, warum Einsparungen bei der Datenqualität zu ungenauen Prognosen, verzerrten Ergebnissen und einem Vertrauensverlust in bahnbrechende KI- und ML-Systeme führen können.

Daten mit sinnvollem ML freisetzen

Im aktuellen digitalen Zeitalter haben Unternehmen einen beispiellosen Zugriff auf riesige Datenmengen. Die Daten bilden eine entscheidende Grundlage für wichtige Geschäftsentscheidungen. Um jedoch sicherzustellen, dass die den Mitarbeitern zur Verfügung stehenden Daten zuverlässig, sichtbar, sicher und skalierbar sind, müssen Unternehmen erhebliche Investitionen in Datenmanagementlösungen tätigen. Warum? Minderwertige Daten können katastrophale Folgen haben, die Millionen kosten können. Wenn die zum Training von ML-Modellen verwendeten Daten unvollständig oder ungenau sind, könnte dies zu ungenauen Vorhersagen mit daraus resultierenden Geschäftsentscheidungen führen, die zu Umsatzeinbußen führen. Wenn beispielsweise schlechte Daten zu falschen Nachfrageprognosen führen, kann dies dazu führen, dass das Unternehmen zu wenig oder zu viel des Produkts produziert, was zu Umsatzeinbußen, überhöhten Lagerkosten oder Eillieferungen und Überstunden führt.

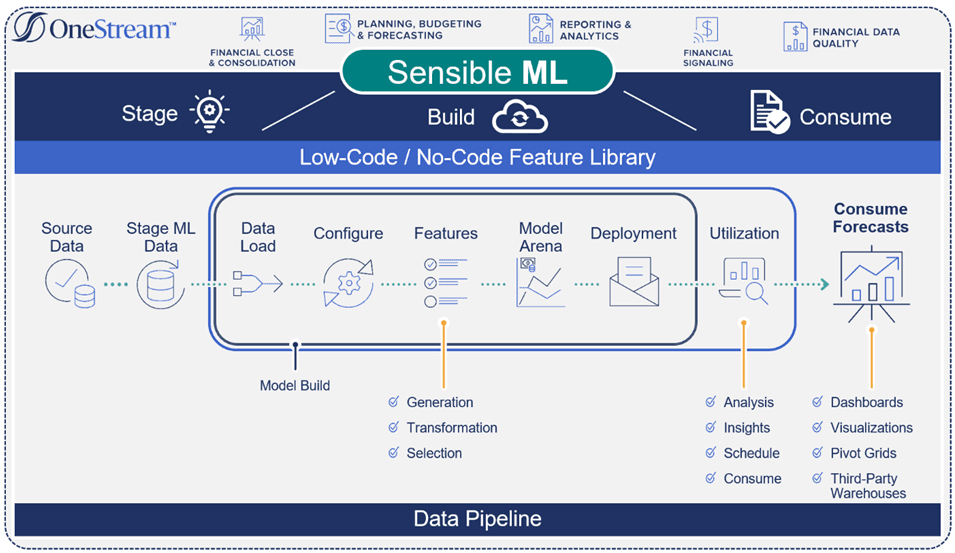

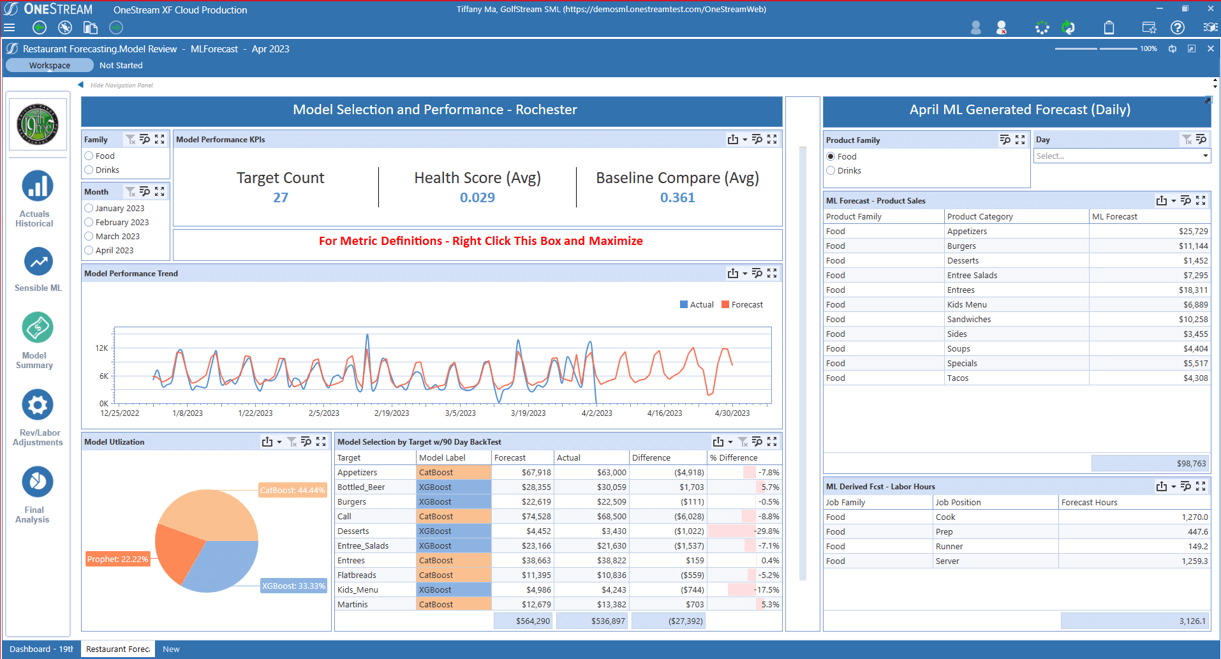

Im Gegensatz zu den „meisten“ Predictive-Analytics-Prognosemethoden, die Prognosen auf der Grundlage historischer Ergebnisse und Statistiken erstellen, OneStreams Sinnvolles ML beinhaltet wahr Geschäftserkenntnisse. Zu diesen Erkenntnissen gehören Faktoren wie Ereignisse, Preise, Wettbewerbsdaten und Wetter – die alle zu genaueren und robusteren Prognosen beitragen (siehe Abbildung 1).

Abbildung 1: Sinnvoller ML-Prozessablauf

Daten durchgängig verwalten

FP&A- und Betriebsdaten spielen eine entscheidende Rolle für den Erfolg jedes Prognoseszenarios für maschinelles Lernen. Um jedoch zweckgebundene Datenflüsse zu erstellen, die sich effizient skalieren lassen und außergewöhnliche Benutzererlebnisse bieten, sind fortschrittliche Lösungen – wie Sensible ML – erforderlich. Sinnvolles ML kann wichtige Entscheidungen im gesamten Datenlebenszyklus beschleunigen und automatisieren, von der Datenquelle bis zum Verbrauch (siehe Abbildung 2).

Erweiterte Datenflussfunktionen fördern Folgendes:

- Vertrauen der Governance von Daten durch Gewährleistung des Datenschutzes, Einhaltung organisatorischer Standards und transparenter Rückverfolgbarkeit der Datenherkunft.

- Angereichert interne Daten mit externen Quellen durch das Hinzufügen externer Variablen, die Verbesserungen vorantreiben (z. B. indem Einzelhändler externe Variablen zu vorhandenen Daten hinzufügen, um ein besseres Profil zu erstellen und die Bedürfnisse der Kunden nach Empfehlungen, Upselling und Cross-Selling zu erkennen).

- Beschleunigte Datenverarbeitung durch kontinuierliche Überwachung der Qualität, Aktualität und des beabsichtigten Kontexts der Daten.

Abbildung 2: Sinnvolle ML-Pipeline

Sensible ML nutzt die integrierten Datenverwaltungsfunktionen von OneStream, um Quelldaten und Geschäftsintuitionen zu erfassen. Wie? Integrierte Konnektoren rufen automatisch externe Daten wie Wetter, Zinssätze und andere makroökonomische Indikatoren ab, die im Modellbildungsprozess verwendet werden können. Während Sensible ML dann automatisch die externen Datenquellen testet, ohne dass ein Benutzereingriff erforderlich ist, Der Nutzer entscheidet letztlich, welche Daten er nutzt.

Verwendung der integrierten Funktionen von Sensible ML Datenqualität

Sensible ML kann detaillierte Betriebsdaten aus jeder Quelle einbringen, einschließlich Point-of-Sale-Systemen (POS), Data Warehouses (DW), Enterprise Resource Planning-Systemen (ERP) und mehrdimensionalen Würfeldaten.

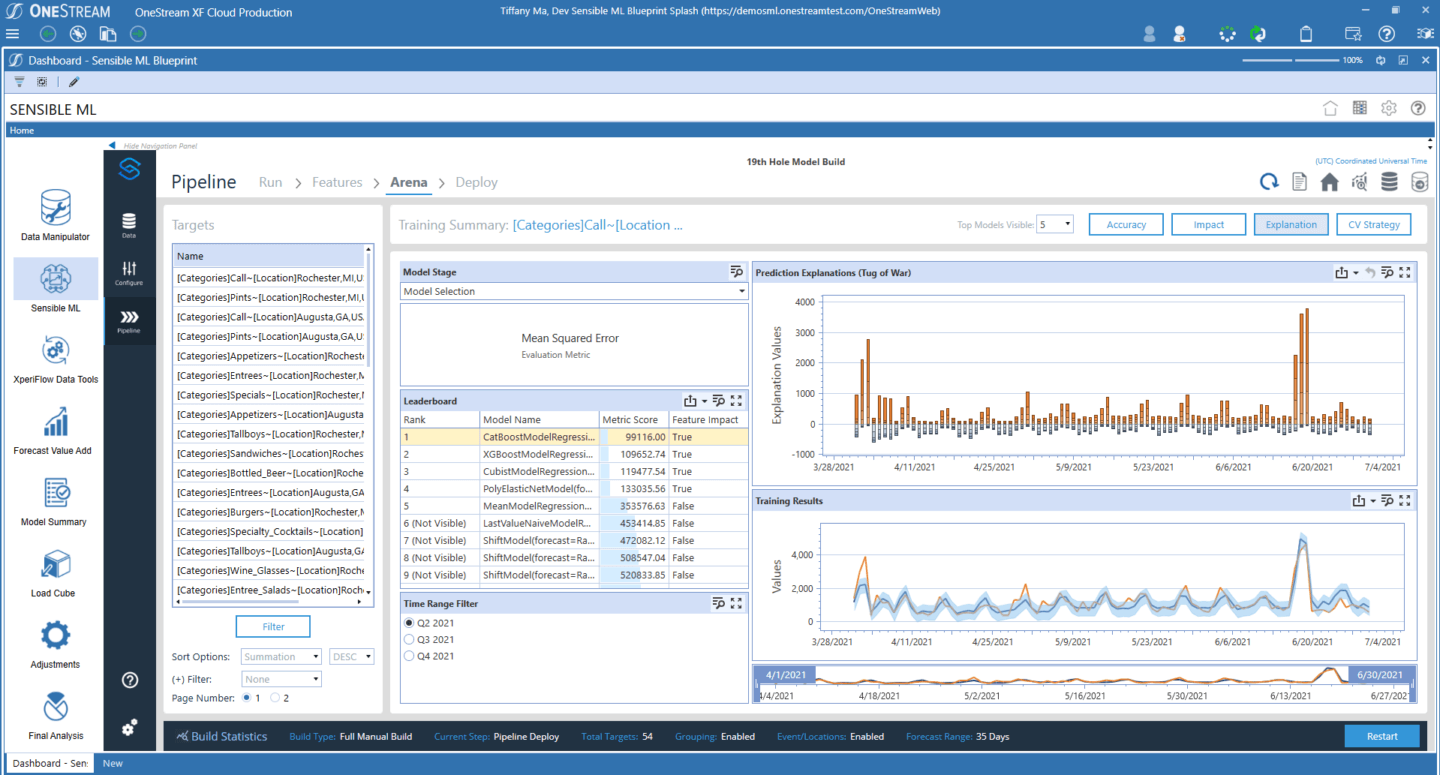

Die Datenqualitätsfunktionen in Sensible ML gehören zu den robustesten Funktionen, die auf dem FP&A-Markt verfügbar sind. Zu diesen Funktionen gehören Validierungen und Bestätigungen vor und nach dem Laden der Daten, eine vollständige Prüfung und volle Flexibilität bei der Datenbearbeitung. Darüber hinaus überwacht das Datenmanagement von Sensible ML das typische Verhalten der Datenkuration und sendet dann Warnungen, wenn Anomalien auftreten (siehe Abbildung 3). Hier ein paar Beispiele:

- Datenaktualität – Sind die Daten rechtzeitig eingetroffen?

- Datenvolumen - Gibt es zu viele oder zu wenige Zeilen?

- Datenschema – Hat sich die Datenorganisation geändert?

Abbildung 3: Automatische ML-Datenbereinigung von Sensible ML

In Sensible ML bietet eine intuitive Benutzeroberfläche Dropdown-Menüs mit den leistungsstärksten und effektivsten Datenbereinigungsmethoden, sodass Geschäftsanwender mit beliebigen Kenntnissen die gesamte Datenpipeline von Anfang bis Ende ausführen können.

Zusammenfassung

Die Sicherstellung der Datenqualität ist nicht nur ein Kästchen, das beim maschinellen Lernen angekreuzt werden muss. Vielmehr ist die Datenqualität das Fundament, auf dem das gesamte Gebäude steht. Da die Grenzen dessen, was mit ML möglich ist, ständig erweitert werden, wird das uralte Sprichwort „Müll rein, Müll raus“ immer noch gelten. Unternehmen müssen daher danach streben, der Datenqualität die Aufmerksamkeit zu schenken, die ihr zu Recht gebührt. Schließlich geht es in der Zukunft des maschinellen Lernens nicht nur um komplexere Algorithmen oder schnellere Berechnungen. Die Erstellung genauer, fairer und zuverlässiger Modelle – die auf hochwertigen Daten basieren – ist ebenfalls für effektives ML unerlässlich.

Mehr erfahren

Um mehr über den End-to-End-Datenfluss und die Interaktion von FP&A mit Daten zu erfahren, bleiben Sie auf dem Laufenden für weitere Beiträge aus unserer Sensible ML-Blogserie. Sie können auch unser Whitepaper herunterladen hier.

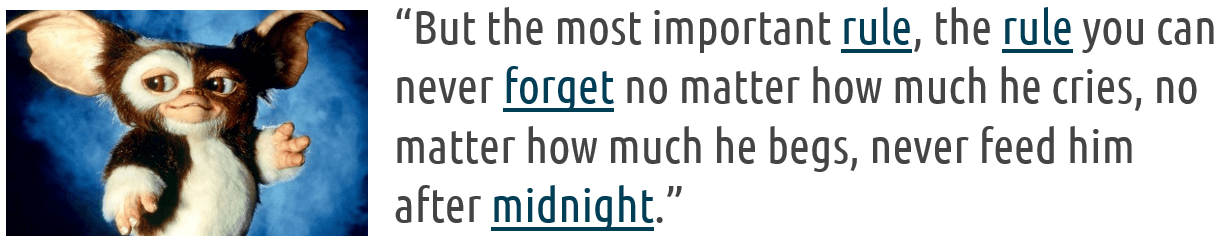

Unternehmen überall verlassen sich auf Daten, um fundierte Entscheidungen zu treffen und durch Datenmanagement das Endergebnis zu verbessern. Aber bei der riesigen Datenmenge von heute können die Dinge schnell außer Kontrolle geraten und Datengremlins hervorbringen (dh kleine Taschen mit unzusammenhängenden, nicht verwalteten Daten), die verheerende Schäden in der Organisation anrichten.

Erinnern Sie sich an diese entzückenden Kreaturen, die sich in der Horrorkomödie von 1984 in zerstörerische, schelmische Kreaturen verwandelten, als sie nach Mitternacht gefüttert wurden Gremlins? (siehe Abbildung 1)

Auf die gleiche Weise können Datengremlins – auch bekannt als "Technische Schulden" – können entstehen, wenn Ihre Systeme nicht flexibel genug sind, um Finanzen zu liefern. Die effektive Verwaltung von Daten, um zu verhindern, dass Datengremlins Chaos anrichten, ist in jeder modernen Organisation von entscheidender Bedeutung – und das erfordert zunächst, den Aufstieg von Datengremlins zu verstehen.

Haben Sie Datengremlins?

Wie entstehen Datengremlins und wie breiten sie sich so schnell aus? Die Anfänge begannen mit Excel. Mitarbeiter in der Finanz- und Betriebsabteilung erhielten große Stapel von Berichten mit grünen Balken (siehe Abbildung 2). Erinnern Sie sich nicht an die? Sie sahen aus wie das Bild unten und wurden in großen Räumen abgelegt und gestapelt.

Wenn Sie Daten benötigten, zogen Sie den Bericht, tippten die Daten erneut in Excel ein, fügten einige Formatierungen und Berechnungen hinzu, druckten die Tabelle und legten sie in den Posteingang Ihres Chefs. Ihr Chef würde dann prüfen und Vorschläge und Ergänzungen machen, bis er sicher ist (ein relativer Begriff hier!), dass die gemeinsame Nutzung der Tabelle mit dem oberen Management nützlich wäre, und voila, ein Gremlin ist geboren.

Und Gremlins sind schlecht für die Organisation.

Der Aufstieg der Datengremlins

Datengremlins sind kein neues Phänomen, aber eines, das schwerwiegende Auswirkungen auf das Unternehmen haben kann, was zu verschwendeter Zeit und Ressourcen, entgangenen Einnahmen und einem beschädigten Ruf führt. Aus diesem Grund ist eine robuste Datenverwaltungsstrategie unerlässlich, um zu verhindern, dass Datengremlins Chaos anrichten.

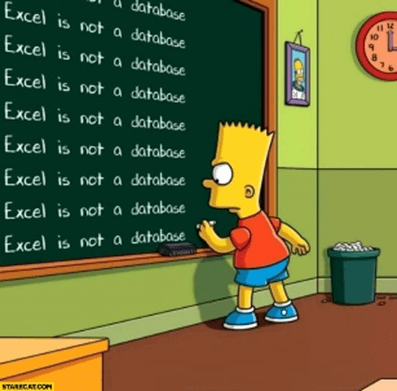

Als Systeme und Integration ausgefeilter wurden und Hauptbücher zu einem zuverlässigen Buch der Aufzeichnungen wurden, sollten Datengremlins aus der Existenz verschwinden. Jedoch müssen auch haben sie? Nein, nicht einmal ein bisschen. Tatsächlich wuchsen die Datengremlins schneller als je zuvor, teilweise aufgrund des Aufstiegs der beliebtesten Schaltfläche in jedem Bericht, überall zu der Zeit – Sie haben es erraten – der „Exportieren in .CSV“ Taste. Das Erstellen neuer Gremlins wurde noch einfacher und schneller, und das Management begann, immer mehr Analysen zu verlangen, die leicht in Tabellenkalkulationen erstellt werden konnten (siehe Abbildung 3). Um der Nachfrage im Jahr 2006 gerecht zu werden, Microsoft Die Anzahl der Datenzeilen, die ein einzelnes Blatt haben kann, wurde auf eine Million Zeilen erhöht. Eine Million! Und die Leute jubelten!

In diesen Millionen-Zeilen-Tabellen waren jedoch Fehler vergraben, nicht nur in einigen Tabellen, sondern in fast ALLEN. Die Spreadsheets hatten keine übergeordnete Governance und konnten in keiner Weise automatisch überprüft werden. Infolgedessen würden diese Fehler Monate und Jahre andauern. Jeder Berater, der diese Tabellenkalkulationen erlebt hat, wird Geschichten von Leuten bestätigen, die „+1,000,000“ als Last-Minute-Anpassung zu einer Formel hinzugefügt und dann vergessen haben, den Zusatz später zu entfernen. Große Unternehmen meldeten falsche Nummern auf der Straße, und Menschen verloren wegen solcher Fehler Arbeitsplätze.

Im Laufe der Zeit wurden die Tools immer ausgefeilter – von MS Excel und MS Access bis hin zu Abteilungsplanungslösungen sowie Anaplan, Essbase, Vena Solutions, Workday Adaptive und andere. Doch keiner hält dem Grad an Zuverlässigkeit stand, den die IT erreichen soll. Die Kontrollen und Audits sind nichts im Vergleich zu was Enterprise Resource Planning (ERP-)Lösungen bieten. Warum breiten sich solche Tools also weiter aus? Wer füttert sie sozusagen nach Mitternacht? Der wahre Grund ist, dass diese Abteilungsplanungssysteme wie ein Hammer sind. Jedes Mal, wenn ein neues Modell oder ein Analysebedarf auftaucht, heißt es: „Bauen wir einen weiteren Würfel.“ Auch wenn diese bestimmte Datenstruktur nicht die beste Antwort ist, hat die Finanzabteilung einen Hammer, und sie werden etwas damit einschlagen. Und warum sollten sie ihre Sorgfalt darauf verwenden, die Verbreitung von Gremlins zu verstehen? (Siehe Abbildung 4)

Die Beziehung lässt sich am besten als „kompliziert“ beschreiben. ERPs und Data Warehouses sind sichere, verwaltete Umgebungen, bieten Finanz- oder Betriebsabteilungen jedoch fast keine Flexibilität, um anspruchsvolle Berichte oder Analysen durchzuführen, die nicht von der IT für sie erstellt wurden. Anfragen nach neuen Berichten werden häufig über ein Ticketsystem gestellt, und je besser die IT diese Anfragen erfüllen kann, desto länger wird die Ticketwarteschlange. Plötzlich macht das Team nur noch Berichte, und die Finanzabteilung denkt: „Wie zum Teufel gibt es ein Team von Leuten in der IT, die sich nicht darauf konzentrieren, das Geschäft effizienter zu machen?“

Die von den Mega-ERP-Anbietern vorgeschlagene Antwort lautet, damit aufzuhören. Endbenutzer brauchen diese Daten, diesen Grad an Granularität oder diese Flexibilität nicht wirklich. Sie müssen lernen, zu vereinfachen und sich nicht um triviale Dinge zu kümmern. Beispielsweise benötigen Endbenutzer keinen Einblick in das, was bei einer rechtlichen Konsolidierung oder einer ausgefeilten Prognose passiert. „Vertrauen Sie uns einfach. Wir werden es tun“, sagen ERP-Anbieter.

Hier ist das Problem: Finanzen hat die Aufgabe, die richtigen Daten zur richtigen Zeit mit der richtigen Analyse zu liefern. Was ist das Ergebnis, wenn man ERP-Anbietern nur „vertraut“? Noch mehr Datengremlins. Mehr manuelle Abstimmungen. Weniger Sicherheit und Kontrolle über die kritischsten Daten für das Unternehmen. Mit anderen Worten, ein Unternehmen kann leicht 30 Millionen US-Dollar für ein sicheres, gut konzipiertes ERP-System ausgeben, das das Gremlin-Problem nicht löst – was unterstreicht, warum Unternehmen den Datenverwaltungsprozess kontrollieren müssen.

Die Bedeutung der Kontrolle des Datenmanagements und der Reduzierung der technischen Schulden

Effektives Datenmanagement ermöglicht es Unternehmen, fundierte Entscheidungen auf der Grundlage genauer und zuverlässiger Daten zu treffen. Aber Regelung Datenmanagement verhindert Datengremlins und reduziert technische Schulden. Datenqualitätsprobleme werden von den Gremlins fortgeführt und können entstehen, wenn keine angemessenen Datenverwaltungsverfahren vorhanden sind. Diese Probleme können unvollständige, widersprüchliche oder ungenaue Daten umfassen, die zu falschen Schlussfolgerungen, schlechter Entscheidungsfindung und Ressourcenverschwendung führen.

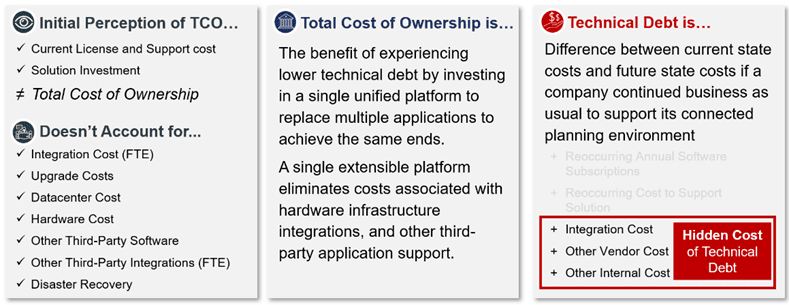

Eines der größten Versäumnisse im Umgang mit Datengremlins besteht darin, sich nur auf den Return on Investment (ROI) zu konzentrieren und die voll belasteten technischen Schulden abzulehnen (siehe Abbildung 5). Viele Finanzteams verwenden Leistungsmessungen wie Total Cost of Ownership (TCO) und ROI, um zu qualifizieren, dass die Lösung gut für das Unternehmen ist, aber selten geht die Organisation tiefer – über die Leistungsmessung hinaus, um Möglichkeiten zur Reduzierung von Implementierungs- und Wartungsverschwendung einzubeziehen. Leider berücksichtigt diese Ansicht der Leistungsmessung nicht die versteckten Komplexitäten und Kosten, die mit den negativen Auswirkungen des Datengremlin-Wachstums verbunden sind.

Technische Schuld ist MEHR als die Gesamtbetriebskosten

Leider können Datengremlins in jeder Phase des Datenmanagementprozesses auftreten, von der Datenerfassung bis zur Analyse und Berichterstellung. Diese Gremlins können durch verschiedene Faktoren verursacht werden, wie z. B. menschliches Versagen, Systemstörungen oder sogar böswillige Aktivitäten. Beispielsweise könnte ein Datengremlin ein fehlendes oder falsches Feld in einer Datenbank sein, was zu ungenauen Berechnungen oder Berichten führt.

Willst du Beweise? Denken Sie nur an den langen, langsamen Prozess, den Sie und Ihr Team durchlaufen, wenn Sie Informationen zwischen fragmentierten Quellen und Tools aufspüren, anstatt die Ergebnisse zu analysieren und Ihren Geschäftspartnern beim Handeln zu helfen. Kommt Ihnen dieser langwierige Prozess bekannt vor?

Die gute Nachricht ist, dass es eine andere Option gibt. Die Vereinheitlichung dieser vielfältigen Prozesse und Tools kann für mehr Automatisierung sorgen, die Komplexität der Vergangenheit beseitigen und die vielfältigen Anforderungen selbst der komplexesten Organisationen erfüllen, sowohl heute als auch in Zukunft. Der Schlüssel ist der Aufbau einer flexiblen, aber geregelten Umgebung, die es ermöglicht, Probleme und neue Analysen innerhalb des Frameworks zu erstellen – keine Gremlins.

Sonnenlicht auf die Datengremlins

Bei OneStream haben wir diese komplizierte Beziehung während unserer gesamten Karriere gelebt und verwaltet. Wir haben sogar Gremlins erstellt, als die Antwort auf alles war: „Eine weitere Tabelle erstellen“. Aber wir haben die Gremlins in Tabellenkalkulationen eliminiert, nur um sie durch Abteilungs-Apps oder Cubes zu ersetzen, die einfach größere, fiesere Gremlins sind. Unsere Kampfnarben haben uns gelehrt, dass Gremlins zwar einfach zu bedienen und zu verwalten, aber nicht die Lösung sind. Stattdessen vermehren sie sich und verursachen neue und größere, schwer zu lösende Probleme des endlosen Datenabgleichs.

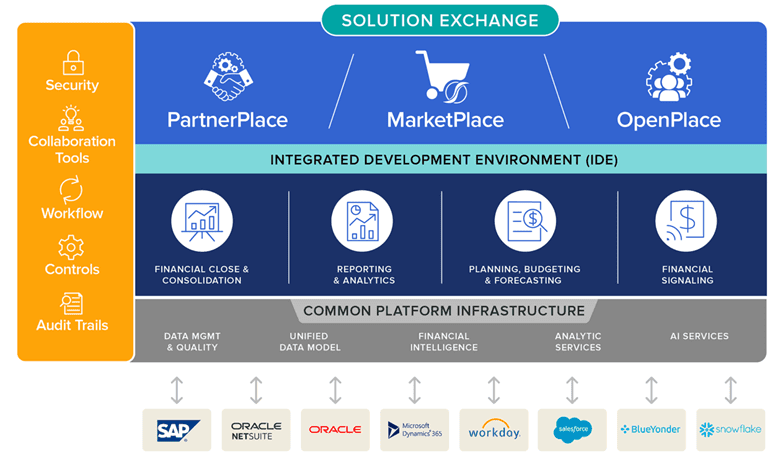

Aus diesem Grund, One Stream wurde von Grund auf entwickelt und gebaut, um Gremlins zu eliminieren, einschließlich der Notwendigkeit für sie in der Zukunft (siehe Abbildung 6). OneStream kombiniert die gesamte Sicherheit, Governance und Prüfung, die erforderlich sind, um genaue Daten zu gewährleisten – und erledigt dies alles an einem Ort, ohne dass Sie von außerhalb gehen müssen, während die Flexibilität innerhalb des zentral definierten Frameworks genutzt werden kann. In OneStream können Unternehmen Extensible Dimensionality nutzen, um Endbenutzern einen Mehrwert zu bieten, damit sie „ihr Ding machen“ können, ohne dies vorantreiben zu müssen Schaltfläche „In .CSV exportieren“..

OneStream ist auch eine Plattform im wahrsten Sinne des Wortes. Die Plattform bietet eine direkte Datenintegration in Quelldaten, einen Drillback zu diesen Daten sowie flexible, benutzerfreundliche Reporting- und Dashboarding-Tools.

Dadurch kann die IT die nicht wertschöpfenden Kosten für die Erstellung von Berichten UND die Gremlins eliminieren – alles auf einen Schlag.

Schließlich ist unsere Plattform die einzige EPM-Plattform, die es Organisationen ermöglicht, ihre Funktionalität direkt auf der Plattform zu entwickeln. Das ist richtig – OneStream ist ein Vollständige Entwicklungsplattform Hier können Unternehmen alle Plattformressourcen für Integration und Berichterstellung nutzen, die Unternehmen benötigen, um ihr eigenes geistiges Eigentum (IP) bereitzustellen. Sie können sogar die IP in der Plattform verschlüsseln oder mit anderen teilen.

Mit anderen Worten, OneStream ermöglicht es Unternehmen, ihre Daten effektiv zu verwalten. In unserem E-Book auf Qualitätsmanagement von Finanzdatenhaben wir die drei wichtigsten Ziele für ein effektives Qualitätsmanagement von Finanzdaten mit CPM geteilt:

- Vereinfachte Datenintegration – Die direkte Integration in ein beliebiges offenes GL/ERP-System ermöglicht es Benutzern, einen Drillback und Drillthrough zu Quelldaten durchzuführen.

- Verbesserte Datenintegrität – Leistungsstarke Validierungen und Bestätigungen vor und nach dem Laden von Daten, die sicherstellen, dass in jedem Schritt des Prozesses die richtigen Daten verfügbar sind.

- Erhöhte Transparenz – 100 % Transparenz und Audit-Trails für Daten, Metadaten und Sichtbarkeit von Prozessänderungen vom Bericht bis zur Quelle.

Zusammenfassung

Datengremlins können den Geschäftsbetrieb stören und schwerwiegende Auswirkungen auf das Geschäft haben, sodass es für Unternehmen unerlässlich ist, ihre Datenverwaltungsprozesse zu kontrollieren, bevor Datengremlins auftauchen. Durch die Entwicklung einer Datenverwaltungsstrategie, die Investition in robuste Datenverwaltungssysteme, die Durchführung regelmäßiger Datenprüfungen, die Schulung von Mitarbeitern in Best Practices für die Datenverwaltung und einen Disaster-Recovery-Plan können Unternehmen datenbezogenen Problemen vorbeugen und die Geschäftskontinuität sicherstellen.

Mehr erfahren

Laden Sie unser Whitepaper mit dem Titel „Connected Planning vereinheitlichen oder versteckte Kosten in Kauf nehmen"

Maschinelles Lernen (ML) hat das Potenzial, das Enterprise Performance Management (EPM) zu revolutionieren, indem es Unternehmen Echtzeit-Einblicke und Vorhersagefunktionen über Planungs- und Prognoseprozesse hinweg bietet. Mit der Fähigkeit, riesige Datenmengen zu verarbeiten, können ML-Algorithmen Organisationen dabei helfen, Muster, Trends und Beziehungen zu erkennen, die sonst unbemerkt bleiben würden. Und da sich die Technologie weiterentwickelt und verbessert, werden sich in Zukunft wahrscheinlich noch größere Vorteile ergeben, da das Finanzwesen die Leistungsfähigkeit von ML nutzt, um finanzielle Ziele zu erreichen.

Begleiten Sie uns, wenn wir Sensible ML for EPM – Future of Finance at Your Fingertips untersuchen.

Der Wechsel zu Intelligent Finance

Ob künstliche Intelligenz (KI) und ML eine Rolle in den Unternehmensplanungsprozessen spielen werden, ist für CFOs keine Frage mehr. Heute konzentriert sich die Frage stattdessen darauf, wie ML so operationalisiert werden kann, dass optimale Ergebnisse und Skalierung erzielt werden. Die Antwort ist, wo es schwierig wird.

Warum? Geschäftliche Agilität ist in der sich schnell verändernden Welt der Planung von entscheidender Bedeutung. Um schnell zu denken und zuerst zu handeln, müssen Unternehmen Herausforderungen meistern, die die Notwendigkeit umfassen, das Geschäft schnell auszubauen, die zukünftige Nachfrage genau vorherzusagen, unvorhergesehene Marktbedingungen zu antizipieren und vieles mehr. Die zunehmenden Datenmengen im gesamten Unternehmen erschweren es Entscheidungsträgern jedoch, sich auf die erforderlichen Daten zu konzentrieren und die richtigen Erkenntnisse zu extrapolieren, um die Planungszyklen und -ergebnisse positiv zu beeinflussen. Um das Problem weiter zu verschärfen, nutzen viele fortschrittliche Analyseprozesse und -tools nur historische Daten auf hoher Ebene, was Entscheidungsträger dazu zwingt, von Grund auf neu zu prognostizieren, wenn unvorhersehbare Marktveränderungen eintreten.

Aber mit KI und ML können Business-Analysten die relevantesten internen/externen Variablen analysieren und korrelieren. Und die Variablen tragen dann zur Prognosegenauigkeit und Leistung in den Vertriebs-, Lieferketten-, Personal- und Marketingprozessen bei, die Finanzpläne und Ergebnisse umfassen.

Diese Dynamik unterstreicht, warum jetzt die Zeit für Intelligent Finance ist.

In den kommenden Wochen werden wir einen Vierteiler teilen Blog Serie, die den Weg zu einer ML-gestützten intelligenten Planung diskutiert. Hier ist ein kleiner Vorgeschmack auf die Schlüsselthemen unserer Reihe „Sensibles ML für EPM“:

- Teil 1: 4 Triebkräfte für Veränderungen. Diese Kräfte haben das Potenzial, ML zu beschleunigen und Organisationen weg von deskriptiven und diagnostischen Analysen (die erklären, was passiert ist und warum) und hin zu prädiktiven und präskriptiven Analysen zu bewegen

- Teil 2: Genauigkeit und Transparenz erhöhen. Unternehmen sind heute mehr denn je bestrebt, ihre Finanzpläne agiler, genauer und transparenter zu gestalten, um wettbewerbsfähig zu bleiben. Und Sensible ML kann helfen. Es ermöglicht Eingaben von Benutzern, die näher am Unternehmen sind, um Geschäftsintuition in das Modell einfließen zu lassen, was die Genauigkeit erhöhen und sicherstellen kann, dass alle verfügbaren Informationen berücksichtigt werden. (siehe Bild 1)

- Teil 3: Schlüsselfunktionen für intelligente Planung. Sensible ML unterscheidet sich von „den meisten“ Prognosefunktionen für prädiktive Analysen (die sich frühere Ergebnisse und Statistiken ansehen und Prognosen auf der Grundlage dessen erstellen, was in der Vergangenheit passiert ist). Speziell, Sinnvolles MLhat die Fähigkeit, nicht nur frühere Ergebnisse zu betrachten, sondern auch zusätzliche Geschäftsintuition zu berücksichtigen – wie Ereignisse, Preise, Wettbewerbsinformationen und Wetter – um präzisere/belastbarere Prognosen zu erstellen.

- Teil 4: Erfolgsgeschichten von Kunden. Jeder Kunde muss eine Referenz und ein Erfolg sein. Das Leitbild von OneStream bestimmt alles, was wir tun. Ein tieferer Blick auf Kunden, die von den Vorteilen der Nutzung von Sensible ML profitiert haben, kann jedem Unternehmen helfen, echte vorausschauende Erkenntnisse zu gewinnen.

Unabhängig davon, wo Sie sich auf Ihrer Finanzreise befinden, unsere Reihe „Sensible ML für EPM“ wurde entwickelt, um Erkenntnisse aus der Erfahrung des Teams von Branchenexperten von OneStream zu teilen. Wir sind uns natürlich bewusst, dass jede Organisation einzigartig ist – also bewerten Sie bitte, was für Sie am wichtigsten ist, basierend auf den spezifischen Bedürfnissen Ihrer Organisation.

Zusammenfassung

Das Streben nach ML-gestützten Plänen ist nichts Neues. Um jedoch inmitten des zunehmenden Tempos des Wandels und der technologischen Disruption wettbewerbsfähig zu bleiben, müssen Finanzleiter anders denken, um endlich die Komplexität zu überwinden, die der traditionellen Unternehmensplanung innewohnt. ML hat das Potenzial, EPM erheblich zu verbessern, indem es Unternehmen Echtzeit-Einblicke und prädiktive Analysen bietet. Organisationen müssen jedoch Herausforderungen meistern (z. B. sicherstellen, dass gute Datenqualität und Auswahl des richtigen ML-Algorithmus), um erfolgreich zu sein. Da sich ML weiterentwickelt, werden wahrscheinlich immer mehr Organisationen seine Leistungsfähigkeit nutzen, um bessere finanzielle und operative Ergebnisse zu erzielen.

Organisationen jeder Größe stehen mehrere Herausforderungen bevor, aber eine der wichtigsten Entscheidungen wird die Implementierung der richtigen ML-Lösung sein – eine, die alle Aspekte von effektiv aufeinander abstimmen kann Planung und die Organisation ihren strategischen Zielen näher bringen. Sensible ML beantwortet diesen Anruf. Es bringt Leistung und Raffinesse in Organisationen, um die Transparenz zu fördern und die Geschwindigkeit von Prognoseprozessen mit beispielloser Transparenz und Ausrichtung auf die Geschäftsleistung zu erhöhen.

Mehr erfahren

Um mehr über den Wert von Sensible ML zu erfahren, laden Sie unser Whitepaper mit dem Titel „Sinnvolles Machine Learning für CPM – Future Finance an Ihren Fingerspitzen" Beim Klicken hier. Und vergessen Sie nicht, weitere Beiträge aus unserer Blog-Reihe zum maschinellen Lernen einzuschalten!

Vertrauen in die Datenqualität ist heute mehr denn je gefragt. Führungskräfte müssen ständig auf eine Vielzahl von Änderungen reagieren und mit genauen und zeitnahen Daten versorgt werden, um die richtigen Entscheidungen über die zu ergreifenden Maßnahmen zu treffen. Daher ist es wichtiger denn je, dass Unternehmen eine klare Strategie für das kontinuierliche Qualitätsmanagement von Finanzdaten (FDQM) haben. Warum? Bessere Ergebnisse resultieren aus besseren Entscheidungen. Und qualitativ hochwertige Daten geben Unternehmen das nötige Vertrauen, um alles richtig zu machen. Dieses Vertrauen in die Daten führt letztendlich zu einer besseren Leistung und reduziert das Risiko.

Warum ist Datenqualität wichtig?

Wie die Forschung gezeigt hat, ist die Datenqualität aus mehreren Hauptgründen von Bedeutung. Laut Gartner[1] kostet schlechte Datenqualität Unternehmen durchschnittlich 12.9 Millionen US-Dollar pro Jahr. Diese Kosten entstehen nicht nur durch die Verschwendung von Ressourcenzeit in finanziellen und betrieblichen Prozessen, sondern auch – und noch wichtiger – durch verpasste Einnahmemöglichkeiten.

Da sich Unternehmen besserer Technologie zuwenden, um eine bessere Zukunftsausrichtung zu erreichen, hat der Schwerpunkt, der auf das Qualitätsmanagement von Finanzdaten in Unternehmenssystemen gelegt wird, nur noch zugenommen. Gartner prognostizierte außerdem, dass bis 2022 70 % der Unternehmen die Datenqualitätsniveaus anhand von Metriken rigoros verfolgen und die Qualität um 60 % verbessern würden, um Betriebsrisiken und Kosten erheblich zu senken.

In einem Bericht über das Schließen der Daten-Wert-Lücke sagte Accenture[2], dass „Organisationen ohne Vertrauen in Daten keine starke Datengrundlage aufbauen können“. Dem Bericht zufolge vertraut nur ein Drittel der Unternehmen ihren Daten genug, um sie effektiv zu nutzen und einen Mehrwert daraus zu ziehen.

Kurz gesagt, die Bedeutung der Datenqualität wird vielen Organisationen immer klarer – ein überzeugendes Argument für eine Änderung in Finanzberichterstattung Softwareauswertungen. Es gibt jetzt eine echte Dynamik, um die historischen Barrieren niederzureißen und mit neuer Zuversicht voranzukommen.

Abbau der Barrieren für die Datenqualität

Das Qualitätsmanagement von Finanzdaten war für viele Unternehmen schwierig, wenn nicht sogar unmöglich. Warum? Nun, in vielen Fällen waren ältere Corporate Performance Management (CPM)- und ERP-Systeme einfach nicht so konzipiert, dass sie auf natürliche Weise zusammenarbeiten, und blieben stattdessen tendenziell als isolierte Anwendungen mit jeweils eigenem Zweck getrennt. Zwischen den Systemen besteht nur eine geringe oder keine Konnektivität, sodass Benutzer häufig gezwungen sind, Daten manuell von einem System abzurufen, die Daten manuell zu transformieren und sie dann in ein anderes System zu laden – was viel Zeit in Anspruch nimmt und mit dem Risiko einer geringeren Datenqualität einhergeht.

Es gibt auch oft einen Mangel an Front-Office-Kontrollen, was zu einer Vielzahl von Problemen führt:

- Schlechte Dateneingabe und eingeschränkte Validierung.

- Ineffiziente Datenarchitektur mit mehreren veralteten IT-Systemen.

- Fehlende geschäftliche Unterstützung für den Wert der Datentransformation.

- Unzureichende Aufmerksamkeit auf Führungsebene hindert eine Organisation daran, die effektiven Bausteine zu legen Qualität der Finanzdaten.

All dies trägt zu erheblichen Hindernissen bei der Gewährleistung einer guten Datenqualität bei. Hier sind die Top 3 Barrieren:

- Mehrere getrennte Systeme – Mehrere Systeme und isolierte Anwendungen erschweren das zeitnahe Zusammenführen, Aggregieren und Standardisieren von Daten. Einzelne Systeme werden zu unterschiedlichen Zeiten hinzugefügt, oft unter Verwendung unterschiedlicher Technologien und unterschiedlicher dimensionaler Strukturen.

- Daten von schlechter Qualität – Daten in Quellsystemen sind oft unvollständig, inkonsistent oder veraltet. Außerdem kopieren viele Integrationsmethoden einfach Daten komplett mit allen vorhandenen Fehlern – ohne Validierungen oder Governance.

- Executive-Buy-in – Das Fehlen von Executive Buy-in könnte auf Wahrnehmung oder Herangehensweise zurückzuführen sein. Schließlich erfordert eine effektive Datenqualitätsstrategie Konzentration und Investitionen. Bei so vielen konkurrierenden Projekten in jedem Unternehmen muss die Argumentation für eine Strategie überzeugend sein und den Wert, den Datenqualität liefern kann, effektiv demonstrieren.

Doch selbst wenn solche Hindernisse anerkannt werden, kann es äußerst schwierig sein, die Finanz- und Betriebsteams dazu zu bringen, ihre Softwaretools für die Finanzberichterstattung und traditionelle Arbeitsweisen aufzugeben. Die Barrieren sind jedoch oft nicht so schwer zu überwinden, wie manche glauben.

Die Lösung kann so einfach sein, wie zu zeigen, wie viel Zeit durch den Wechsel zu neueren Tools und Technologien gespart werden kann. Durch solche Übergänge kann die Reduzierung des Zeitaufwands zu einer dramatischen Verbesserung der Qualität der technische Daten durch effektive Integration mit Validierung und Kontrolle, die in das System selbst integriert sind.

Die Lösung

Es gibt einige, die glauben, dass das Pareto-Gesetz für die Datenqualität gilt: Normalerweise ermöglichen 20 % der Daten 80 % der Anwendungsfälle. Es ist daher entscheidend, dass eine Organisation diese 3 Schritte befolgt, bevor sie ein Projekt zur Verbesserung der Finanzdatenqualität beginnt:

- Qualität definieren – Bestimmen Sie, was Qualität für die Organisation bedeutet, einigen Sie sich auf die Definition und legen Sie Metriken fest, um das Niveau zu erreichen, mit dem sich alle sicher fühlen.

- Optimieren Sie die Datenerfassung – Stellen Sie sicher, dass die Anzahl unterschiedlicher Systeme minimiert wird und die Integrationen Weltklasse-Technologie mit Konsistenz zu den Datenerfassungsprozessen verwenden.

- Identifizieren Sie die Bedeutung von Daten – Wissen Sie, welche Daten für die Organisation am kritischsten sind, und beginnen Sie dort – mit den 20 %. Fahren Sie dann fort, wenn die Organisation bereit ist.

Im Kern ein voll integriertes CPM-Softwareplattform mit eingebaut Die Qualität von Finanzdaten (siehe Abbildung 1) ist für Unternehmen von entscheidender Bedeutung, um eine effektive Transformation im Finanzbereich und in allen Geschäftsbereichen voranzutreiben. Eine Schlüsselanforderung ist die 100-prozentige Transparenz von Berichten bis zu Datenquellen – das heißt, alle Finanz- und Betriebsdaten müssen klar sichtbar und leicht zugänglich sein. Wichtige Finanzprozesse sollten automatisiert werden, und die Verwendung einer einzigen Schnittstelle würde bedeuten, dass das Unternehmen seine zentralen Finanz- und Betriebsdaten mit vollständiger Integration in alle ERPs und andere Systeme nutzen kann.

Die Lösung sollte auch geführte Workflows beinhalten, um Geschäftsanwender vor Komplexität zu schützen, indem sie auf einzigartige Weise durch alle Datenverwaltungs-, Verifizierungs-, Analyse-, Zertifizierungs- und Sperrprozesse geführt werden.

OneStream bietet all das und mehr. Mit einer starken Grundlage in der Qualität von Finanzdaten ermöglicht OneStream Unternehmen, Daten aus mehreren Quellen zu integrieren und zu validieren und fundierte Entscheidungen auf der Grundlage genauer Finanz- und Betriebsergebnisse zu treffen. Das Finanzdaten-Qualitätsmanagement von OneStream ist kein Modul oder separates Produkt, sondern eingebaut der Kern der OneStream-Plattform – Bereitstellung strenger Kontrollen, um das Vertrauen und die Zuverlässigkeit zu gewährleisten, die zur Gewährleistung qualitativ hochwertiger Daten erforderlich sind.

In unserem E-Book auf Qualitätsmanagement von Finanzdaten haben wir die folgenden 3 Ziele für ein effektives Finanzdatenqualitätsmanagement mit CPM geteilt:

- Vereinfachen Sie die Datenintegration – Direkte Integration in jedes offene GL/ERP-System und Ermöglichung von Drillback und Drillthrough zu Quelldaten.

- Verbessern Sie die Datenintegrität – Leistungsstarke Validierungen und Bestätigungen vor und nach dem Laden von Daten stellen sicher, dass in jedem Schritt des Prozesses die richtigen Daten verfügbar sind.

- Erhöhen Sie die Transparenz – 100 % Transparenz und Audit-Trails für Daten, Metadaten und Sichtbarkeit von Prozessänderungen vom Bericht bis zur Quelle.

Wir liefern 100%igen Kundenerfolg

Hier ist ein Beispiel für ein Unternehmen, das die Datenerfassung optimiert und die Datenqualität im Finanzabschluss-, Konsolidierungs- und Berichterstattungsprozess verbessert hat, indem es die einheitliche Plattform von OneStream nutzt.

MEC-Holding GmbH – mit Hauptsitz in Bad Soden, Deutschland – fertigt und liefert industrielle Schweißzusätze und Dienstleistungen, Schneidsysteme und medizinische Instrumente für OEMs in Deutschland und international. Das Unternehmen ist in drei Einheiten tätig: Castolin Eutectic Systems, Messer Cutting Systems und BIT Analytical Instruments.

MEC hat 36 Länder, die monatlich Bericht erstatten, darunter über 70 Einheiten und 15 lokale Währungen, sodass der finanzielle Konsolidierungs- und Berichtsprozess ein hohes Volumen an unternehmensübergreifenden Aktivitäten umfasst. Mit OneStream ist die Datenerfassung jetzt viel einfacher, da geführte Workflows die Benutzer durch ihre Aufgaben führen. Benutzer laden Testsalden selbst hoch, anstatt sie an das Unternehmen zu senden, was den Prozess beschleunigt und die Datenqualität sicherstellt. Außerdem war das neue System für Benutzer mit begrenztem Training sehr einfach zu erlernen und zu übernehmen.

MEC stellte fest, dass das Vertrauen, „eine Version der Wahrheit“ zu haben, mit OneStream durchaus möglich ist.

Mehr erfahren

Wenn Ihre Finanzorganisation daran gehindert wird, ihren wahren Wert freizusetzen, ist es vielleicht an der Zeit, Ihre internen Systeme und Prozesse zu bewerten und mit der Identifizierung von Verbesserungsmöglichkeiten zu beginnen. Wie das geht, erfahren Sie in unserem Whitepaper „Comquering Complexity in the Financial Close“.

Financial Data Quality Management (FDQM) wurde von den meisten Anbietern von Corporate Performance Management (CPM) oft nur als nachträglicher Einfall entwickelt oder einfach als Option präsentiert. Eigentlich sollte es die Grundlage eines jeden CPM-Systems sein. Wieso den? Nun, robuste FDQM-Fähigkeiten reduzieren nicht nur Fehler und ihre Folgen, sondern auch Ausfallzeiten durch Unterbrechungen in Prozessen und die damit verbundenen Kosten für Ineffizienz.

Ein effektives FDQM bedeutet, neben standardisierten, definierten und wiederholbaren Prozessen strenge Auditkontrollen bereitzustellen, um maximales Vertrauen und Zuverlässigkeit in jeden Geschäftsbenutzerprozess zu gewährleisten. Effektives FDQM ermöglicht es einem Unternehmen auch, Finanzabschluss- und Budgetierungszyklen zu verkürzen und Endbenutzern wichtige Informationen schneller und einfacher zur Verfügung zu stellen.

Fortsetzung unserer Den Close-Blog neu erfinden In dieser Serie untersuchen wir, warum das Qualitätsmanagement von Finanzdaten eine wesentliche Anforderung in der heutigen Umgebung der Unternehmensberichterstattung ist. Eine schlechte Datenqualität kann zu Fehlern oder Auslassungen in Jahresabschlüssen führen, die häufig zu Compliance-Strafen, Vertrauensverlust von Stakeholdern und möglicherweise zu einer Verringerung des Marktwerts führen.

Zunehmendes Interesse am Qualitätsmanagement von Finanzdaten

Unternehmen erkennen jetzt, dass FDQM von entscheidender Bedeutung ist. Wieso den? Finanzteams müssen nicht nur sicherstellen, dass die Finanzberichterstattung korrekt ausgegeben wird, sondern auch, dass alle zukunftsgerichteten Daten und Leitlinien vollständig durch „qualitative“ tatsächliche Ergebnisse gestützt werden.

Ein alter Ausdruck, der im Zusammenhang mit der Finanzberichterstattung verwendet wird, fasst diese Idee gut zusammen: „Wenn Sie Müll reinwerfen, bekommen Sie Müll raus.

Ein Mangel an robusten Datenintegrationsfunktionen schafft eine Vielzahl von Problemen. Hier sind nur einige:

- Manuelle Schritte, die Ressourcen und Zeit verschwenden

- Risiko von Fehlern

- Schlechte finanzielle Entscheidungen

- Fehlende Rückverfolgbarkeit

- Mangelnde Überprüfbarkeit

In vielen Fällen wurden ältere CPM- und ERP-Systeme einfach nicht für die natürliche Zusammenarbeit entwickelt und bleiben als isolierte Anwendungen mit jeweils eigenem Zweck getrennt. Häufig besteht zwischen den Systemen nur eine geringe oder keine Konnektivität, und Benutzer sind gezwungen, Daten manuell von einem System abzurufen, die Daten manuell zu transformieren und sie dann in ein anderes System zu laden.

Da Organisationen immer komplexer werden und die Datenmengen immer größer werden, ist es nur natürlich, die Aufmerksamkeit auf die Qualität der eingegebenen Daten zu richten. Ganz zu schweigen davon, dass Organisationen mit der Erforschung und Einführung fortschrittlicherer Fähigkeiten – wie künstlicher Intelligenz (KI) und maschinellem Lernen (ML) – gezwungen sind, zuerst ihre Daten zu prüfen und dann Maßnahmen zu ergreifen, um eine effektive Datenqualität sicherzustellen. Warum sind diese Schritte notwendig? Einfach ausgedrückt, die besten Ergebnisse von KI, ML und anderen fortschrittlichen Technologien hängen von Anfang an vollständig von guten, sauberen Qualitätsdaten ab.

Was ist die Lösung?

Eine vollständig integrierte CPM/EPM-Plattform mit FDQM im Kern ist für Unternehmen von entscheidender Bedeutung, um eine effektive Transformation im Finanzwesen und in allen Geschäftsbereichen voranzutreiben. Eine Schlüsselanforderung ist 100 % Transparenz von den Berichten bis zu den Quellen – alle Finanz- und Betriebsdaten müssen klar sichtbar und leicht zugänglich sein. Wichtige Finanzprozesse sollten automatisiert werden, und die Verwendung einer einzigen Schnittstelle würde bedeuten, dass das Unternehmen seine zentralen Finanz- und Betriebsdaten mit vollständiger Integration in alle ERPs und andere Systeme nutzen kann.

Die Lösung muss auch geführte Arbeitsabläufe beinhalten, um Geschäftsanwender vor Komplexität zu schützen, indem sie auf einzigartige Weise durch alle Datenverwaltungs-, Verifizierungs-, Analyse-, Zertifizierungs- und Sperrprozesse geführt werden.

Benutzer sollten in der Lage sein, ein effektives FDQM und eine Verifizierung durch standardisierte und vereinfachte Datenerfassung und -analyse mit Berichten bei jedem Schritt im Arbeitsablauf zu erreichen. Die Workflows müssen so geleitet werden, dass sie standardisierte, definierte und wiederholbare Prozesse für maximales Vertrauen und Zuverlässigkeit in einem von Geschäftsbenutzern gesteuerten Prozess bereitstellen. Was ist das Endergebnis? Die Vereinfachung von Geschäftsprozessen und die Reduzierung von Fehlern und Ineffizienzen im gesamten Unternehmen.

Warum OneStream?

Die starken Grundlagen von OneStream im FDQM-Bereich ermöglichen eine beispiellose Flexibilität und Transparenz des Datenlade- und -integrationsprozesses.

OneStreams Qualitätsmanagement von Finanzdaten ist kein Modul oder separates Produkt, sondern ein Kernbestandteil der einheitlichen Plattform von OneStream, die strenge Kontrollen bietet, um Vertrauen und Zuverlässigkeit in die Qualität Ihrer Daten zu gewährleisten. Wie? Das Qualitätsrisiko für Finanzdaten wird mithilfe vollständig überprüfbarer Systemintegrationskarten verwaltet, und Validierungen werden verwendet, um Übermittlungen von Remote-Standorten zu kontrollieren. Daten können über direkte Verbindungen zu Quelldatenbanken oder über ein beliebiges Dateiformat geladen werden. Auditberichte können basierend auf Wesentlichkeitsschwellen gefiltert werden, wodurch einmalige Überprüfungen an geeigneten Stellen im Prozess gewährleistet sind.

Im Wesentlichen bietet die einheitliche Plattform von OneStream marktführende Datenintegrationsfunktionen mit nahtlosen Verbindungen zu mehreren Quellen.

OneStream Integration Connectors bieten eine direkte Integration mit allen offenen GL/ERP- oder anderen Quellsystemen und bieten die folgenden Vorteile:

- Bietet schnelle und effiziente Direct-to-Source-Systemintegrationsprozesse mit integrierter robotergesteuerter Prozessautomatisierung (RPA).

- Drilldown, Drillback und Drillthrough zu Transaktionsdetails, einschließlich Journaleinträgen.

- Bietet direkte Integration mit Drillback zu über 250 ERP-, HCM-, CRM- und anderen Systemen (z. B. Oracle, PeopleSoft, JDE, SAP, Infor, Microsoft AX/Dynamics und mehr).

100 % Kundenerfolg

AAA-Lebensversicherung implementierte OneStream, um alle ihre Anforderungen an Finanzkonsolidierung, Berichterstellung, Budgetierung und Analyse zu unterstützen. Seitdem hat AAA Life den Finanzabschlussprozess rationalisiert und nicht nur die Sichtbarkeit der Daten, sondern auch die Transparenz der Ergebnisse erheblich verbessert. Sie können jetzt von den berechneten oder konsolidierten Zahlen von OneStream bis zurück zum Transaktions-ERP-System aufschlüsseln, um schnelle Antworten auf kritische Fragen zu erhalten.

Der Traum von „einer Version der Wahrheit“ ist mit OneStream durchaus möglich.

Mehr erfahren

Laden Sie unser Whitepaper herunter, um mehr darüber zu erfahren, wie Sie den Finanzabschluss mit der konkurrenzlosen Leistung der Intelligent Finance Platform von OneStream neu gestalten können. Und vergessen Sie nicht, sich weitere Beiträge aus unserer Blog-Serie „Re-Imagining the Financial Close“ anzusehen.

Die CFOs und Controller von heute müssen ihre kritischen, unternehmensweiten Finanzdaten und -prozesse so effektiv wie möglich verwalten. Diese Daten müssen zeitnah, genau und leicht zugänglich sein, um aufschlussreiche Berichte und Analysen zu ermöglichen, um einen Wettbewerbsvorteil zu wahren. Dementsprechend müssen ihre Corporate Performance Management (CPM)-Lösungen robust und skalierbar sein und eine vollständige Integration mit ihren ERP-, HCM-, CRM- und anderen Systemen ermöglichen.

Egal, ob Sie sich nach einer EPM-Lösung umsehen oder zu einer neuen Lösung wechseln möchten – die Drillthrough-Funktion von OneStream ist die Funktionalität, von der Sie nie wussten, dass Sie sie benötigen.

Viele Anbieter behaupten, komplexe Konsolidierungen handhaben zu können, aber es gibt einige signifikante Unterschiede zwischen der zugrunde liegenden Engine, die zum Ausführen benötigt wird Aggregation von Finanzdaten und die Engine, die verwendet wird, um direkte Aggregation oder einfache Konsolidierungen auszuführen. Jeder Anbieter, der Microsoft Analysis Services, Oracle Essbase, Cognos, TM1, SAP Hanna oder eine ähnliche reine Aggregations-Engine verwendet, wird mit zahlreichen Herausforderungen konfrontiert sein, um den Kern zu bewältigen finanzielle Konsolidierung Bedarf. Lassen Sie uns dies genauer untersuchen.