Hoy en día, la confianza en la calidad de los datos es de vital importancia, ya que los líderes de la educación superior deben responder a diversas presiones políticas y económicas. Los colegios y universidades también están bajo el microscopio para garantizar la responsabilidad fiscal y al mismo tiempo servir mejor a los estudiantes. Ahora más que nunca, los equipos de Finanzas de educación superior necesitan datos confiables, precisos y oportunos para tomar las decisiones correctas para cada escuela.

Los consejos universitarios también piden a las instituciones que proporcionen más transparencia y rendición de cuentas.. Esta solicitud significa que tener una estrategia clara para una gestión sólida y continua de la calidad de los datos es más importante que nunca. ¿Por qué? Mejores decisiones crean mejores resultados. Y los datos de alta calidad brindan a las instituciones la confianza en los datos para tomar decisiones correctas, lo que, a su vez, impulsa un mejor apoyo a los estudiantes, resultados más precisos y un menor riesgo.

¿Por qué es importante la calidad de los datos?

La investigación ha demostrado que la calidad de los datos importa. De acuerdo a Ventana, casi nueve de cada 10 organizaciones (89%) informaron que los problemas de calidad de los datos eran una barrera impactante o muy impactante para su organización. Los impactos provocan una falta de confianza en los datos y una pérdida de tiempo de recursos en los procesos financieros y operativos.

De hecho, muchas instituciones buscan basarse más en datos. De acuerdo a La crónica de la educación superior, el 97% de los administradores universitarios encuestados cree que la educación superior necesita utilizar mejor los datos y el análisis para tomar decisiones estratégicas.

A medida que las instituciones se vuelven más complejas, también crece la necesidad de centrarse en la calidad de los datos. Como dice el refrán, “basura entra, basura sale” (ver Figura 1), por lo que crear una base sólida de datos gobernados es imperativo para la toma de decisiones basada en datos. Tener una fuente de datos confiable en toda la institución a la que se pueda hacer referencia es imperativo para alinear los equipos.

¿Qué impide una buena calidad de los datos?

En muchos casos, las instituciones se enfrentan a las restricciones de procesos financieros desconectados, sistemas heredados y herramientas de análisis ineficientes. Esta burocracia ha alimentado la falta de agilidad, procesos engorrosos y una toma de decisiones aislada. En pocas palabras, las soluciones implementadas no están diseñadas para funcionar juntas y, por lo tanto, dificultan la gestión de la calidad de los datos.

A menudo existe poca o ninguna conectividad entre los sistemas, lo que obliga a los usuarios a recuperar datos manualmente de un sistema, transformarlos manualmente y luego cargarlos en otro sistema sin dejar trazabilidad. Esta falta de capacidades sólidas de calidad de datos crea una multitud de problemas. Éstos son sólo algunos:

- Entrada deficiente de datos con validación limitada, lo que afecta la confianza en las cifras.

- Gran cantidad de tareas manuales, lo que reduce la calidad general de los datos y agrega latencia a los procesos.

- Sin linaje de datos, lo que impide las capacidades de profundización y profundización y agrega tiempo y esfuerzo manual al acceder a información procesable para cada número.

La solución a sistemas desconectados puede ser tan simple como hacer la transición a herramientas y tecnologías más nuevas. ¿Por qué? Tienen una integración más efectiva y validación y control integrados en comparación con soluciones anteriores, lo que ahorrará tiempo y eliminará tareas manuales.

¿Cual es la solución?

Algunos creen que la ley de Pareto (que el 20% de los datos permite el 80% de los casos de uso) se aplica a la calidad de los datos. Por lo tanto, las instituciones deben tomar tres pasos antes de adoptar cualquier proyecto para mejorar la calidad de los datos financieros:

- Definir calidad: Determine qué significa calidad para el colegio o la universidad, acuerde la definición y establezca métricas para alcanzar el nivel con el que todos se sientan seguros.

- Agilizar la recopilación de datos: Asegúrese de que se minimice la cantidad de sistemas dispares y que las integraciones utilicen tecnología de clase mundial con coherencia en los procesos de integración de datos.

- Identificar la importancia de los datos: Sepa qué datos son los más críticos para la organización y comience allí (con el 20%) y continúe solo cuando la organización esté lista.

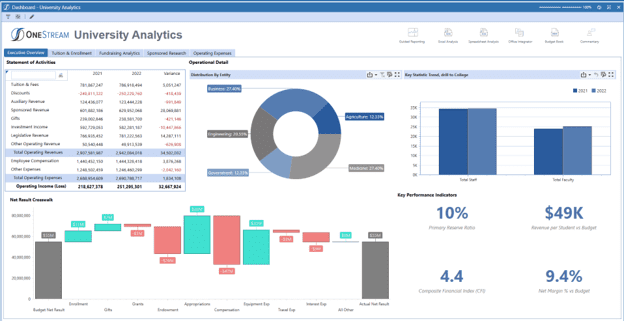

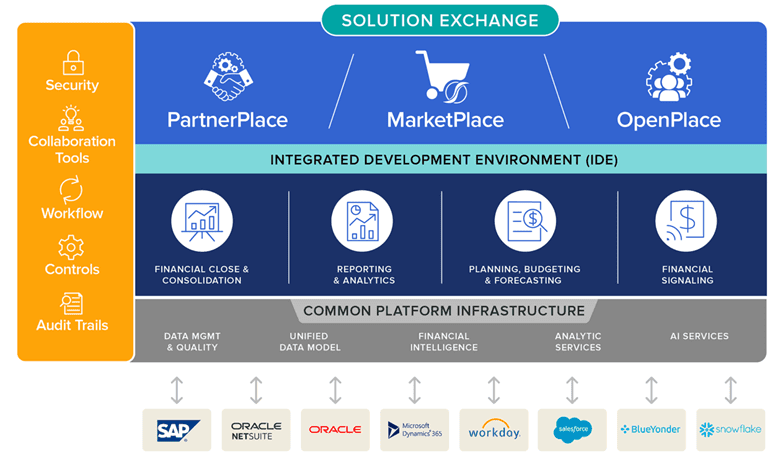

En esencia, un sistema totalmente integrado Plataforma financiera como OneStream con datos financieros integrados es fundamental para que las universidades impulsen una transformación efectiva en Finanzas y diferentes funciones y servicios. ¿Qué requisitos clave se deben considerar? Aquí hay algunas funciones clave:

- Visibilidad del 100% desde informes hasta fuentes de datos, para que todos los datos financieros y operativos sean visibles y fácilmente accesibles.

- Una fuente de verdad para todos los datos financieros y operativos.

- Flujos de trabajo guiados para proteger a los usuarios de la complejidad y los descuidos manuales.

¿Por qué OneStream para la gestión de la calidad de los datos?

La plataforma unificada de OneStream ofrece capacidades de integración de datos líderes en el mercado con conexiones perfectas a múltiples fuentes, incluidos Finanzas, Recursos Humanos y sistemas estudiantiles. Esas capacidades brindan flexibilidad y visibilidad incomparables en el proceso de carga e integración de datos.

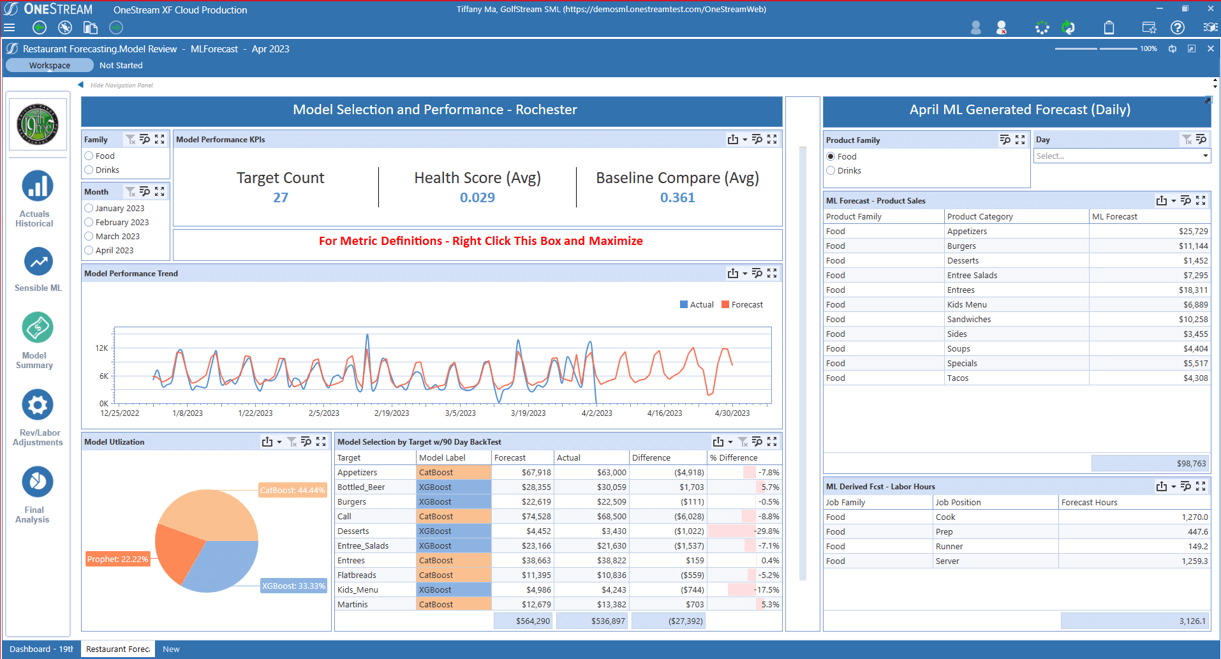

De OneStream gestión de la calidad de los datos es una parte central de la plataforma unificada de OneStream (ver Figura 2). Al proporcionar controles estrictos para brindar confianza y confiabilidad en la calidad de los datos, la plataforma permite a las organizaciones hacer lo siguiente:

- Administre los riesgos de calidad de los datos utilizando validaciones y mapas de integración totalmente auditables en cada etapa del proceso, desde la integración hasta la generación de informes.

- Automatice los datos a través de conexiones directas a bases de datos de origen o mediante cualquier formato de archivo basado en caracteres.

- Filtre los informes de auditoría según los umbrales de materialidad, garantizando revisiones únicas en los puntos apropiados del proceso.

- Capacidad para profundizar, profundizar y profundizar en detalles transaccionales para una trazabilidad completa de cada número.

Conclusión

Las demandas de precisión, transparencia y confianza están siempre presentes en los informes, análisis y planificación financieros y operativos, dado el nivel de detalle necesario para guiar a las instituciones. En consecuencia, las universidades que buscan crear una estrategia para mejorar la gestión de la calidad de los datos deberían considerar una plataforma de software CPM con calidad de datos financieros incorporada para lograr resultados más precisos y reducir el riesgo.

Más información

Obtenga más información sobre cómo OneStream puede producir una mejor calidad de datos y mejorar la precisión de los resultados financieros para la educación superior.

Más informaciónHoy en día, la confianza en la calidad de los datos es de vital importancia. Las demandas de precisión y confianza están siempre presentes en los informes, análisis y planificación financieros y operativos, dado el nivel de detalle necesario para guiar el negocio. El crecimiento de la inteligencia artificial (IA) y el aprendizaje automático (ML) también exige datos de calidad a nivel granular. Ante esas demandas, El viejo dicho de “basura entra, basura sale” se aplica hoy más que nunca.

Los ejecutivos deben responder constantemente a diversos cambios (y en evolución) y, por lo tanto, necesitan datos confiables, precisos y oportunos para tomar las decisiones correctas con respecto a cualquier acción necesaria. Por lo tanto, las organizaciones modernas deben tener una estrategia clara para una gestión sólida y continua de la calidad de los datos. ¿Por qué? Bueno, mejores decisiones crean mejores resultados. Y los datos de alta calidad brindan a las organizaciones la confianza en los datos para tomar decisiones correctas que impulsen un mejor rendimiento, resultados más precisos y riesgos reducidos.

¿Por qué es importante la calidad de los datos?

La calidad de los datos importa, como lo demuestran las investigaciones. De acuerdo a Ventana, casi nueve de cada 10 organizaciones (89%) informaron que los problemas de calidad de los datos eran una barrera impactante o muy impactante. Esos impactos provocan una falta de confianza en los datos y una pérdida de tiempo de recursos en los procesos financieros y operativos.

A medida que las organizaciones recurren a tecnologías más modernas para ayudar a impulsar mejores direcciones futuras, el énfasis en la gestión de la calidad de los datos en los sistemas empresariales no ha hecho más que aumentar. en un informe sobre cerrando la brecha entre datos y valor, Accenture dijo que "sin confianza en los datos, las organizaciones no pueden construir una base de datos sólida". Según el informe, sólo un tercio de las empresas confía lo suficiente en sus datos como para utilizarlos de forma eficaz para obtener valor.

En definitiva, la importancia de la calidad de los datos es cada vez más clara. A medida que las organizaciones se vuelven más complejas y los volúmenes de datos crecen cada vez más, la atención se desplaza naturalmente hacia la calidad de los datos que se utilizan. Sin mencionar que a medida que se exploran y adoptan capacidades más avanzadas (como la IA y el aprendizaje automático), las organizaciones deben primero examinar sus datos y luego tomar medidas para garantizar una calidad efectiva de los datos. ¿Por qué son necesarios estos pasos? En pocas palabras, los mejores resultados de la IA, el aprendizaje automático y otras tecnologías avanzadas dependen completamente de datos de buena calidad y limpios desde el principio.

¿Qué impide una buena calidad de los datos?

En muchos casos, los sistemas CPM y ERP heredados simplemente no se crearon para funcionar juntos, lo que dificultaba la gestión de la calidad de los datos. Estos sistemas también tendían a permanecer separados como aplicaciones aisladas, cada una con su propio propósito. A menudo, existe poca o ninguna conectividad entre los sistemas, lo que obliga a los usuarios a recuperar datos manualmente de un sistema, transformarlos manualmente y luego cargarlos en otro sistema.

Esta falta de capacidades sólidas de calidad de datos crea una multitud de problemas. Éstos son sólo algunos:

- Entrada deficiente de datos con validación limitada, lo que afecta la confianza en las cifras.

- Gran cantidad de tareas manuales, lo que reduce la calidad general de los datos y agrega latencia a los procesos.

- Sin linaje de datos, lo que impide las capacidades de profundización y profundización y agrega tiempo y esfuerzo manual para acceder a información procesable para cada número.

La solución puede ser tan simple como demostrar cuánto tiempo se puede ahorrar mediante la transición a herramientas y tecnologías más nuevas. A través de tales transiciones, reducir la inversión de tiempo puede mejorar dramáticamente la calidad del datos a través de una integración efectiva con validación y control integrados en el propio sistema.

¿Cual es la solución?

Algunos creen que la ley de Pareto (que el 20% de los datos permite el 80% de los casos de uso) se aplica a la calidad de los datos. Por lo tanto, las organizaciones deben seguir tres pasos antes de adoptar cualquier proyecto para mejorar la calidad de los datos financieros:

- Definir calidad – Determinar qué significa calidad para la organización, acordar la definición y establecer métricas para alcanzar el nivel con el que todos se sientan seguros.

- Optimice la recopilación de datos – Garantizar que se minimice el número de sistemas dispares y que las integraciones utilicen tecnología de clase mundial con coherencia en los procesos de integración de datos.

- Identificar la importancia de los datos. – Sepa qué datos son los más críticos para la organización y comience allí (con el 20%) y continúe solo cuando la organización esté lista.

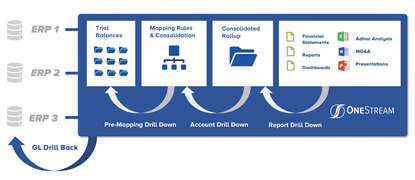

En esencia, un sistema totalmente integrado plataforma de software CPM incorporado La calidad de los datos financieros (consulte la Figura 1) es fundamental para que las organizaciones impulsen una transformación efectiva en todas las finanzas y líneas de negocio. Un requisito clave es proporcionar una visibilidad del 100 % desde los informes hasta las fuentes de datos, lo que significa que todos los datos financieros y operativos deben ser claramente visibles y fácilmente accesibles. Los procesos financieros clave deben automatizarse. Además, utilizar una única interfaz significaría que la empresa puede utilizar sus datos operativos y financieros centrales con una integración total con todos los ERP y otros sistemas.

Figura 1: Gestión de calidad de datos financieros integrada en OneStream

La solución también debe incluir flujos de trabajo guiados para proteger a los usuarios comerciales de la complejidad. ¿Cómo? Guiándolos de manera única a través de todos los procesos de gestión, verificación, análisis, certificación y bloqueo de datos.

¿Por qué OneStream para la gestión de la calidad de los datos?

La plataforma unificada de OneStream ofrece capacidades de integración de datos líderes en el mercado con conexiones perfectas a múltiples fuentes. Esas capacidades brindan flexibilidad y visibilidad incomparables en el proceso de carga e integración de datos.

De OneStream gestión de la calidad de los datos no es un módulo o producto separado, sino más bien una parte central de la plataforma unificada de OneStream. La plataforma proporciona controles estrictos para brindar confianza y confiabilidad en la calidad de los datos al permitir a las organizaciones hacer lo siguiente:

- Administre los riesgos de calidad de los datos utilizando validaciones y mapas de integración totalmente auditables en cada etapa del proceso, desde la integración hasta la generación de informes.

- Automatice los datos a través de conexiones directas a bases de datos de origen o mediante cualquier formato de archivo basado en caracteres.

- Filtre los informes de auditoría según los umbrales de materialidad, garantizando revisiones únicas en los puntos apropiados del proceso.

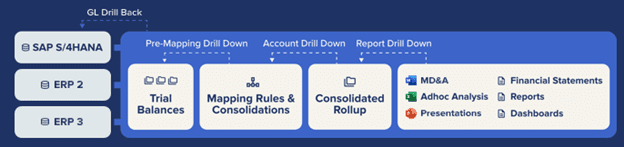

El marco de integración OneStream y los conectores prediseñados ofrecen integración directa con cualquier GL/ERP abierto u otro sistema fuente (consulte la Figura 1). Esa capacidad proporciona beneficios clave:

- Procesos rápidos y eficientes de integración de sistemas directos al origen.

- Capacidad para profundizar, profundizar y profundizar en detalles transaccionales para una trazabilidad completa de cada número.

- Integración directa con exploración de más de 250 sistemas ERP, HCM, CRM y otros (por ejemplo, Oracle, PeopleSoft, JDE, SAP, Infor, Microsoft AX/Dynamics y más).

Con un 100 % de casos de éxito en clientes

A continuación se muestra un ejemplo de una organización que ha simplificado la integración de datos y mejorado la calidad de los datos:

"Antes de OneStream, teníamos que profundizar en los datos del proyecto en todos los sistemas ERP individuales", dijo Joost van Kooten, controlador de proyectos de Huisman. “OneStream ayuda a que nuestros datos sean auditables y ampliables. Nos permite comprender nuestro negocio y crear procesos estandarizados dentro de un sistema global. Confiamos en los datos de OneStream, por lo que no hay desacuerdos sobre la precisión. Podemos centrarnos en el contrato, no en arreglar los datos”.

Como todos los clientes de OneStream, Huisman descubrió que la confianza de tener “una versión de la verdad” es completamente posible con OneStream.

Más información

Si su organización financiera no puede liberar su verdadero valor, tal vez sea el momento de evaluar sus sistemas y procesos internos y comenzar a identificar áreas de mejora. Para saber cómo, lea nuestro documento técnico. Conquistando la Complejidad en el Cierre Financiero.

Descargar el Libro BlancoIntroducción

En el bullicioso mundo de la inteligencia artificial (IA), un dicho resume a la perfección la esencia del trabajo: "entra basura, sale basura". ¿Por qué? Este mantra subraya una verdad que a menudo se subestima en medio de la emoción de las tecnologías emergentes y los algoritmos utilizados en los equipos de FP&A: la calidad de los datos es un factor decisivo para el éxito o el fracaso de cualquier proyecto de aprendizaje automático (ML).

Los macrodatos, a menudo denominados el "petróleo nuevo", alimentan los sofisticados motores de aprendizaje automático que impulsan la toma de decisiones en todos los sectores y procesos. Pero así como un motor real no puede funcionar de manera efectiva con combustible deficiente, los modelos ML entrenados con datos de baja calidad sin duda producirán resultados inferiores. En otras palabras, para que la IA en los procesos de FP&A tenga éxito, la calidad de los datos es esencial. Siga leyendo para obtener más información en nuestra primera publicación de nuestra serie AI para FP&A.

Comprender la importancia de la calidad de los datos

Los científicos de datos gastan 50% -80% de su tiempo recopilando, limpiando y preparando datos antes de que puedan usarse para crear información valiosa. Esta inversión de tiempo es un testimonio de por qué "entra basura, sale basura" no es una advertencia sino una regla a seguir en el ámbito de la IA y el ML. Particularmente para FP&A, esa regla demuestra por qué escatimar en la calidad de los datos puede conducir a pronósticos inexactos, resultados sesgados y una pérdida de confianza en los innovadores sistemas de IA y ML.

Libere los datos con ML sensible

En la era digital actual, las empresas tienen un acceso sin precedentes a grandes cantidades de datos. Los datos sientan una base crucial para tomar decisiones comerciales importantes. Pero para garantizar que los datos disponibles para los empleados sean confiables, visibles, seguros y escalables, las empresas deben realizar inversiones sustanciales en soluciones de administración de datos. ¿Por qué? Los datos deficientes pueden desencadenar resultados catastróficos que podrían costar millones. Si los datos utilizados para entrenar modelos de ML están incompletos o son inexactos, esto podría dar lugar a predicciones inexactas con decisiones comerciales consecuentes que conducen a la pérdida de ingresos. Por ejemplo, si los datos erróneos provocan pronósticos incorrectos sobre la demanda, esto podría llevar a que la empresa produzca demasiado o demasiado poco del producto, lo que resultaría en pérdidas de ventas, costos excesivos de inventario o envíos apresurados y horas extra de mano de obra.

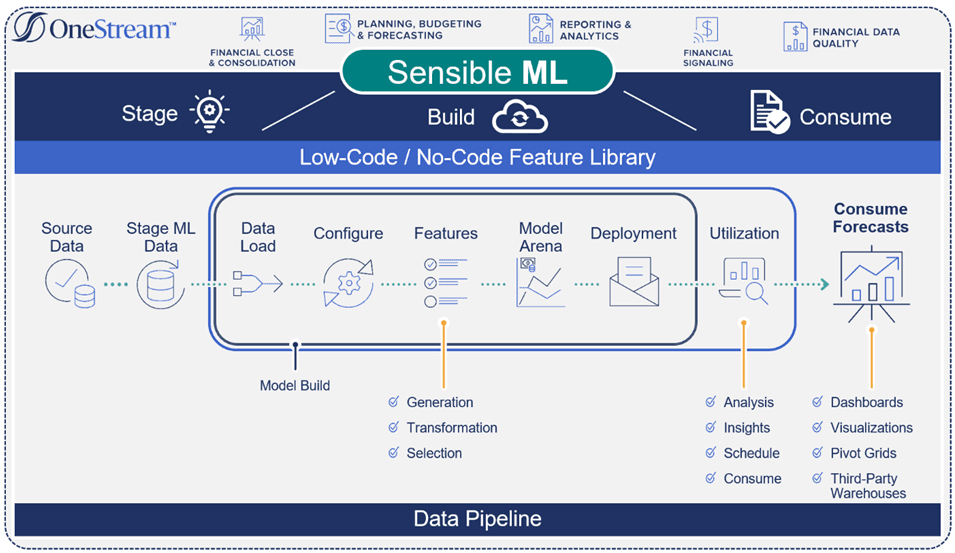

Contrariamente a la “mayoría” de los métodos de pronóstico de análisis predictivo, que generan pronósticos basados en resultados históricos y estadísticas, De OneStream Aprendizaje automático sensato incorpora cierto ideas de negocios. Estos conocimientos incluyen factores como eventos, precios, datos competitivos y el clima, todo lo cual contribuye a un pronóstico más preciso y sólido (consulte la Figura 1).

Figura 1: Flujo de proceso de ML sensible

Gestión de datos de extremo a extremo

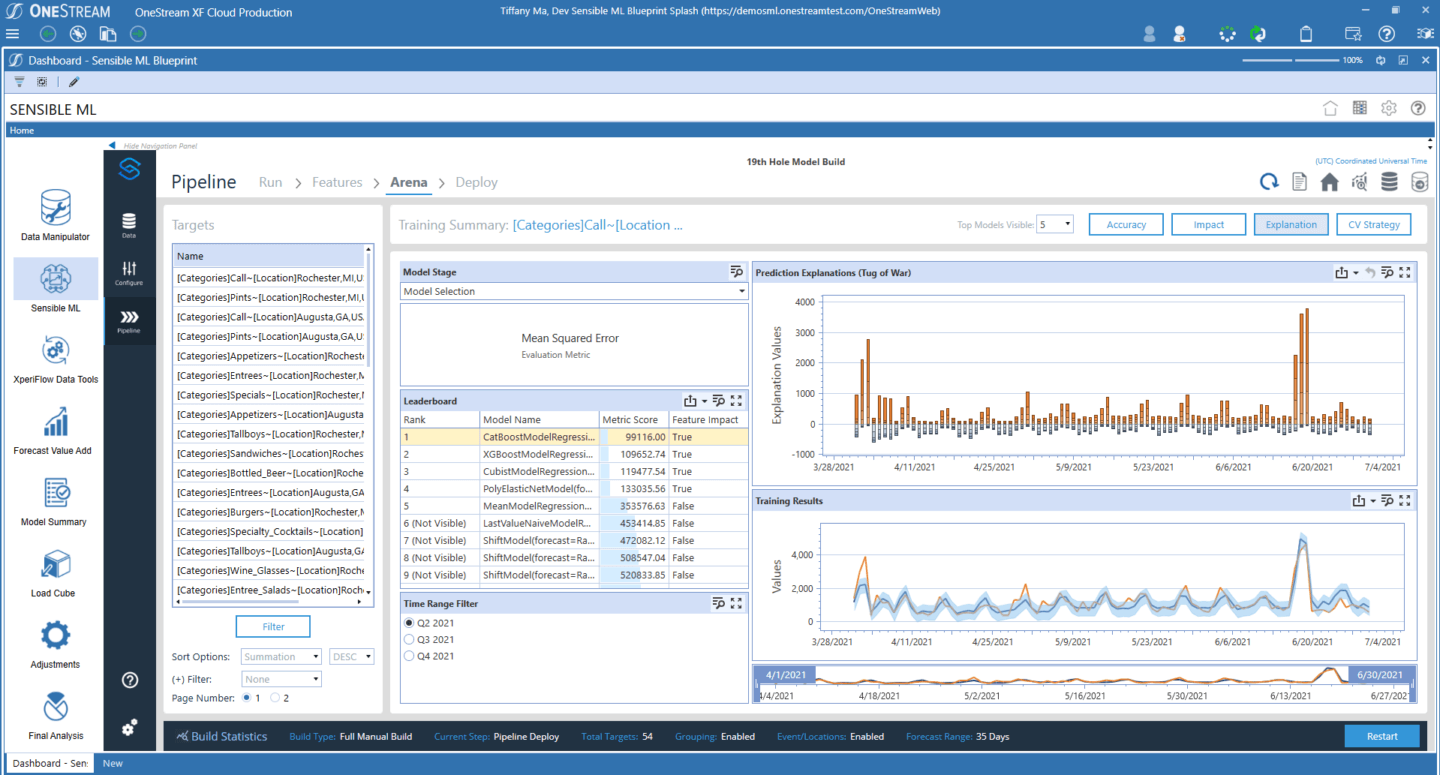

FP&A y los datos operativos juegan un papel fundamental en el éxito de cualquier escenario de pronóstico de aprendizaje automático. Sin embargo, para crear flujos de datos especialmente diseñados que puedan escalar de manera eficiente y brindar experiencias de usuario excepcionales, se necesitan soluciones avanzadas, como Sensible ML. Sensible ML puede acelerar y automatizar decisiones cruciales a lo largo del ciclo de vida de los datos, desde la fuente de datos hasta el consumo (consulte la Figura 2).

Las capacidades avanzadas de flujo de datos fomentan lo siguiente:

- Confía en existentes gobierno de datos al garantizar la privacidad de los datos, el cumplimiento de los estándares organizacionales y la trazabilidad transparente del linaje de datos.

- Enriquecido datos internos con fuentes externas agregando variables externas que impulsan las mejoras (p. ej., los minoristas agregan variables externas a los datos existentes para perfilar mejor y reconocer las necesidades de los clientes en cuanto a recomendaciones, ventas adicionales y ventas cruzadas).

- Acelerado proceso de datos al monitorear continuamente la calidad, la oportunidad y el contexto previsto de los datos.

Figura 2: Canalización de ML sensible

Sensible ML aprovecha las capacidades de gestión de datos integradas de OneStream para ingerir datos de origen e intuición empresarial. ¿Cómo? Los conectores incorporados recuperan automáticamente datos externos como el clima, las tasas de interés y otros indicadores macroeconómicos que se pueden usar en el proceso de creación de modelos. Si bien Sensible ML prueba automáticamente las fuentes de datos externas sin la intervención del usuario, los usuarios finalmente deciden qué datos usar.

Uso de Sensible ML integrado Calidad de los Datos

Sensible ML puede traer datos operativos detallados de cualquier fuente, incluidos los sistemas de punto de venta (POS), almacenes de datos (DW), sistemas de planificación de recursos empresariales (ERP) y datos de cubos multidimensionales.

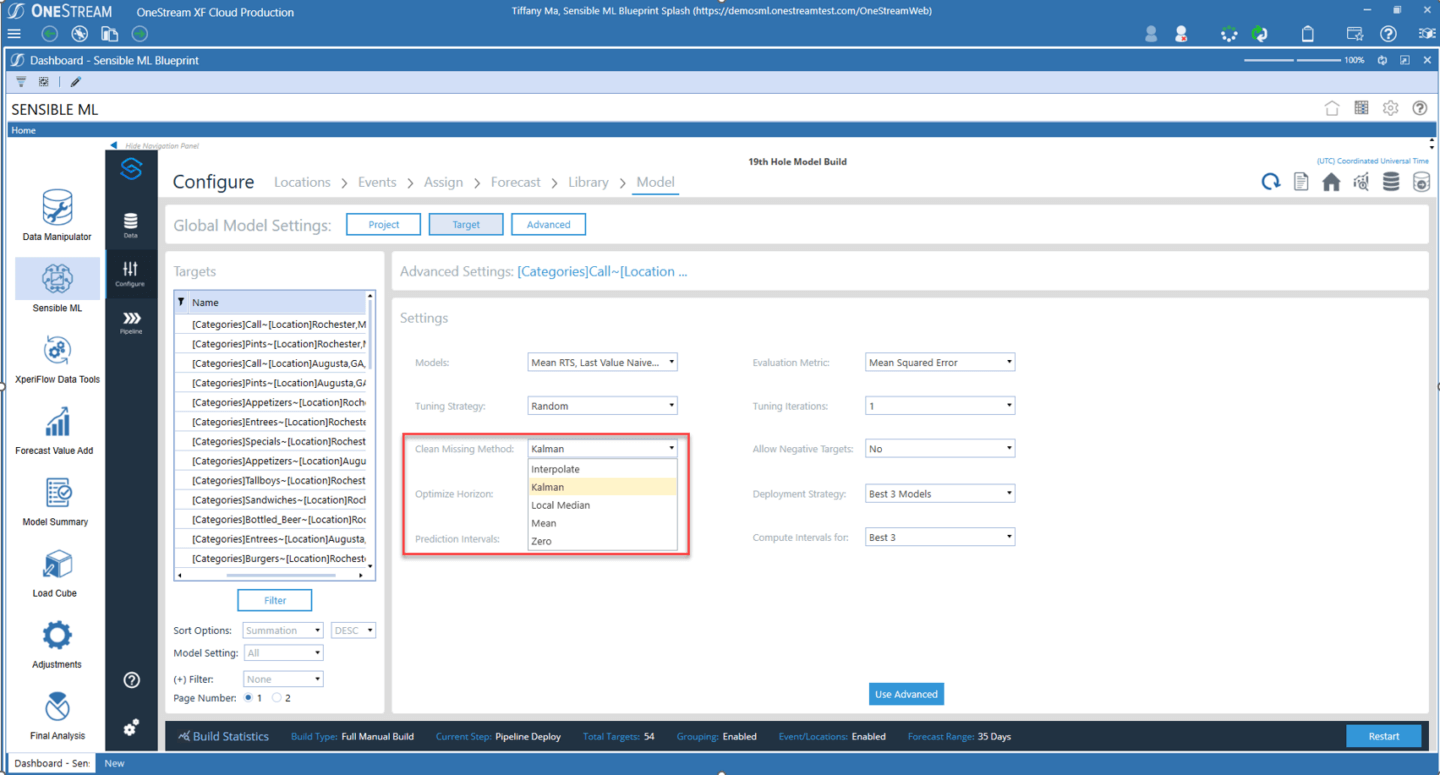

Las capacidades de calidad de datos en Sensible ML brindan algunas de las capacidades más sólidas disponibles en el mercado de FP&A. Esas capacidades incluyen validaciones y confirmaciones previas y posteriores a la carga de datos, auditoría completa y flexibilidad total en la manipulación de datos. Además, la gestión de datos de Sensible ML supervisa el comportamiento típico de la conservación de datos y luego envía alertas cuando se producen anomalías (consulte la figura 3). Aquí están algunos ejemplos:

- Actualización de datos: ¿Llegaron los datos cuando debían?

- Volumen de datos – ¿Hay demasiadas o muy pocas filas?

- Esquema de datos – ¿Cambió la organización de los datos?

Figura 3: limpieza de datos de Auto ML de Sensible ML

En Sensible ML, una interfaz intuitiva ofrece menús desplegables con los métodos de limpieza de datos más efectivos y de mayor rendimiento, lo que permite a los usuarios comerciales de cualquier conjunto de habilidades ejecutar toda la canalización de datos de principio a fin.

Conclusión

Garantizar la calidad de los datos no es solo una casilla que se debe marcar en el viaje de aprendizaje automático. Más bien, la calidad de los datos es la base sobre la que se asienta todo el edificio. A medida que los límites de lo que es posible con ML se amplían continuamente, el antiguo adagio "basura entra, basura sale" seguirá aplicándose. Por lo tanto, las empresas deben esforzarse por brindar a la calidad de los datos la atención que merece. Después de todo, el futuro del aprendizaje automático no se trata solo de algoritmos más complejos o computación más rápida. La producción de modelos precisos, justos y confiables, construidos en base a datos de alta calidad, también es esencial para un aprendizaje automático eficaz.

Más información

Para obtener más información sobre el flujo de datos de extremo a extremo y cómo FP&A interactúa con los datos, esté atento a las publicaciones adicionales de nuestra serie de blogs Sensible ML. También puede descargar nuestro libro blanco esta página.

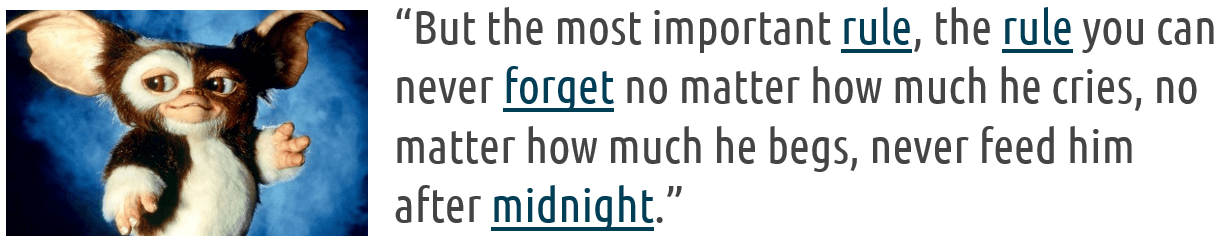

Las organizaciones de todo el mundo confían en los datos para tomar decisiones informadas y mejorar los resultados mediante la gestión de datos. Pero con la gran cantidad de datos actual, las cosas pueden salirse de control rápidamente y generar gremlins de datos (es decir, pequeños bolsillos de datos desconectados y no controlados) que causan estragos en la organización.

Recuerda esas criaturas adorables que se transformaron en criaturas destructivas y traviesas cuando se les dio de comer después de la medianoche en la película de comedia de terror de 1984. Gremlins? (ver Figura 1)

De la misma manera, los gremlins de datos, también conocidos como "deuda técnica" – puede surgir si sus sistemas no son flexibles para permitir que las finanzas entreguen. La gestión eficaz de los datos para evitar que los gremlins de datos causen estragos es crucial en cualquier organización moderna, y eso requiere primero comprender el aumento de los gremlins de datos.

¿Tienes gremlins de datos?

¿Cómo surgen los gremlins de datos y cómo proliferan tan rápidamente? Los primeros comienzos comenzaron con Excel. Las personas en finanzas y operaciones obtendrían grandes cantidades de informes de barras verdes (consulte la figura 2). ¿No recuerdas esos? Se parecían a la imagen de abajo y estaban archivados y apilados en habitaciones grandes.

Cuando necesitaba datos, extraía el informe, volvía a escribir los datos en Excel, agregaba algunos formatos y cálculos, imprimía la hoja de cálculo y la dejaba en la bandeja de entrada de su jefe. Luego, su jefe revisaría y haría sugerencias y adiciones hasta que estuviera seguro (¡un término relativo aquí!) Que compartir la hoja de cálculo con la alta gerencia sería útil, y listo, nace un gremlin.

Y los gremlins son malos para la organización.

El auge de los gremlins de datos

Los gremlins de datos no son un fenómeno nuevo, pero pueden afectar gravemente a la organización, lo que lleva a la pérdida de tiempo y recursos, la pérdida de ingresos y una reputación dañada. Por esa razón, tener una estrategia sólida de gestión de datos es esencial para evitar que los gremlins de datos causen estragos.

A medida que los sistemas y la integración se volvieron más sofisticados y los libros mayores se convirtieron en un libro de registro confiable, los gremlins de datos deberían haber desaparecido. Pero ¿Hicieron ellos? No, ni siquiera un poco. De hecho, los gremlins de datos crecieron más rápido que nunca, en parte debido al aumento del botón más popular en cualquier informe, en cualquier momento, lo adivinó, el "Exportar a .CSV" botón. La creación de nuevos gremlins se volvió aún más fácil y rápida, y la gerencia comenzó a pedir habitualmente cada vez más análisis que pudieran crearse fácilmente en hojas de cálculo (consulte la Figura 3). Para satisfacer la demanda en 2006, Microsoft aumentó el número de filas de datos que una sola hoja podría tener a un millón de filas. ¡Un millón! ¡Y la gente aplaudió!

Sin embargo, los errores estaban enterrados en esas hojas de cálculo de millones de filas, no solo en algunas hojas de cálculo, sino en casi TODAS ellas. Las hojas de cálculo no tenían un control general y no podían verificarse automáticamente de ninguna manera. Como resultado, esos errores vivirían durante meses y años. Cualquier consultor que haya experimentado con esas hojas de cálculo confirmará las historias de personas que agregaron "+1,000,000" a una fórmula como un ajuste de último minuto y luego se olvidaron de eliminar la adición más tarde. Las principales empresas informaron números incorrectos a la calle y la gente perdió trabajos por tales errores.

Con el paso del tiempo, las herramientas se volvieron más sofisticadas, desde MS Excel y MS Access hasta soluciones de planificación departamental como Anaplan, Essbase, Vena Solutions, Workday Adaptive y otros. Sin embargo, ninguno está a la altura del nivel de confiabilidad que debe lograr TI. Los controles y auditorías no son nada comparados con lo que planificación de recursos empresariales (ERP) proporcionan soluciones. Entonces, ¿por qué continúan proliferando tales herramientas? ¿Quién los alimenta después de la medianoche, por así decirlo? La verdadera razón es que estos sistemas de planificación departamental son como un martillo. Cada vez que surge un nuevo modelo o una necesidad de análisis, es "Construyamos otro cubo". Incluso si esa estructura de datos en particular no es la mejor respuesta, Finanzas tiene un martillo y van a golpear algo con él. ¿Y por qué deberían hacer su diligencia para comprender la proliferación de Gremlins? (Véase la figura 4)

La relación se puede describir mejor como "complicada". Los ERP y los almacenes de datos son entornos seguros y administrados, pero casi no ofrecen flexibilidad para que Finanzas u Operaciones realicen informes o análisis sofisticados que TI no haya creado para ellos. Las solicitudes de nuevos informes se realizan, a menudo a través de un sistema de tickets, y cuanto mejor sea TI para satisfacer estas solicitudes, más larga será la cola de tickets. De repente, el equipo no hace nada más que informar, y eso deja a Finanzas pensando: "¿Cómo diablos hay un equipo de personas en TI que no se enfoca en hacer que el negocio sea más eficiente?"

La respuesta sugerida por los proveedores de mega ERP es dejar de hacer eso. Los usuarios finales realmente no necesitan esos datos, ese nivel de granularidad o esa flexibilidad. Necesitan aprender a simplificar y no preocuparse por cosas triviales. Por ejemplo, los usuarios finales no necesitan visibilidad de lo que sucede en una consolidación legal o un pronóstico sofisticado. “Confía en nosotros. Lo haremos”, dicen los proveedores de ERP.

Aquí está el problema: Finanzas tiene la tarea de entregar los datos correctos en el momento correcto con el análisis correcto. ¿Cuál es el resultado de simplemente “confiar” en los proveedores de ERP? Incluso más gremlins de datos. Más conciliaciones manuales. Menos seguridad y control sobre los datos más críticos para la empresa. En otras palabras, una organización puede gastar fácilmente $30 millones en un sistema ERP seguro y bien diseñado que no soluciona el problema de los gremlins, lo que enfatiza por qué las organizaciones deben controlar el proceso de administración de datos.

La importancia de controlar la gestión de datos y reducir la deuda técnica

La gestión eficaz de datos permite a las empresas tomar decisiones informadas basadas en datos precisos y fiables. Pero CONTROL datos de gestión es lo que previene los gremlins de datos y reduce la deuda técnica. Los gremlins perpetúan los problemas de calidad de los datos y pueden surgir cuando no se aplican las prácticas adecuadas de gestión de datos. Estos problemas pueden incluir datos incompletos, inconsistentes o inexactos, lo que lleva a conclusiones incorrectas, mala toma de decisiones y desperdicio de recursos.

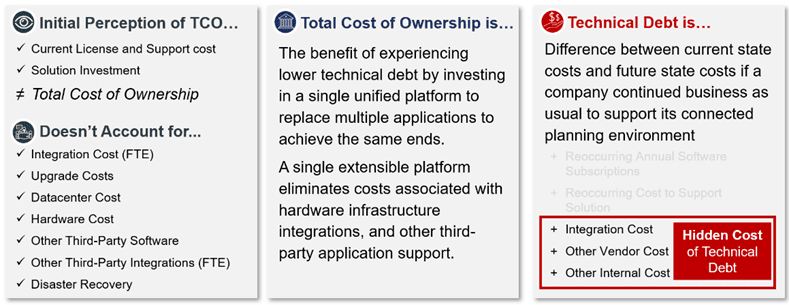

Uno de los mayores descuidos cuando se trata de gremlins de datos es centrarse únicamente en el retorno de la inversión (ROI) y descartar la deuda técnica totalmente cargada (consulte la Figura 5). Muchos equipos de finanzas usan medidas de rendimiento como el costo total de propiedad (TCO) y el ROI para calificar que la solución es buena para la organización, pero rara vez la organización profundiza más, más allá de las medidas de rendimiento para incluir oportunidades para reducir el desperdicio de implementación y mantenimiento. Desafortunadamente, esta visión de las mediciones de rendimiento no tiene en cuenta las complejidades ocultas y los costos asociados con los impactos negativos del crecimiento del gremlin de datos.

La deuda técnica es MÁS que el costo total de propiedad

Desafortunadamente, los gremlins de datos pueden ocurrir en cualquier etapa del proceso de gestión de datos, desde la recopilación de datos hasta el análisis y la generación de informes. Estos gremlins pueden ser causados por varios factores, como errores humanos, fallas del sistema o incluso actividad maliciosa. Por ejemplo, un gremlin de datos podría ser un campo faltante o incorrecto en una base de datos, lo que daría como resultado cálculos o informes inexactos.

Quiere una prueba? Solo piense en el proceso largo y lento en el que usted y su equipo se involucran al rastrear información entre fuentes y herramientas fragmentadas en lugar de analizar los resultados y ayudar a sus socios comerciales a actuar. ¿Te suena familiar este proceso prolongado?

La buena noticia es que existe otra opción. La unificación de estos múltiples procesos y herramientas puede proporcionar una mayor automatización, eliminar las complejidades del pasado y cumplir con los diversos requisitos de incluso la organización más compleja, tanto hoy como en el futuro. La clave es construir un entorno flexible pero gobernado que permita que se creen problemas y nuevos análisis dentro del marco, sin Gremlins.

Luz del sol sobre los gremlins de datos

En OneStream, hemos vivido y manejado esta complicada relación durante toda nuestra carrera. Incluso hicimos gremlins cuando la respuesta para todo era "construir otra hoja de cálculo". Pero hemos eliminado los gremlins en las hojas de cálculo solo para reemplazarlos con aplicaciones o cubos departamentales que son gremlins más grandes y desagradables. Nuestras cicatrices de batalla nos han enseñado que los gremlins, si bien son fáciles de usar y administrar, no son la respuesta. En cambio, proliferan y causan problemas más nuevos y más grandes y difíciles de resolver de reconciliación de datos sin fin.

Por esta razón, la fue diseñado y construido desde cero para eliminar gremlins, incluida la necesidad de ellos en el futuro (consulte la Figura 6). OneStream combina toda la seguridad, la gobernanza y la auditoría necesarias para garantizar datos precisos, y lo hace todo en un solo lugar sin necesidad de salir de las instalaciones, al tiempo que permite aprovechar la flexibilidad dentro del marco definido de forma centralizada. En OneStream, las organizaciones pueden aprovechar la dimensionalidad extensible para proporcionar valor a los usuarios finales para que "hagan lo suyo" sin tener que presionar el Botón “Exportar a .CSV”.

OneStream es también una plataforma en el verdadero sentido de la palabra. La plataforma proporciona integración de datos directa a los datos de origen, desglose de esos datos y herramientas de informes y tableros flexibles y fáciles de usar.

Eso le permite a TI eliminar el costo sin valor agregado de la creación de informes Y los gremlins, todo de una sola vez.

Finalmente, nuestra plataforma es la única plataforma EPM que permite a las organizaciones desarrollar su funcionalidad directamente en la plataforma. Así es, OneStream es un plataforma de desarrollo completo donde las organizaciones pueden aprovechar todos los recursos de la plataforma de integración y generación de informes necesarios para que las organizaciones entreguen su propia propiedad intelectual (PI). Incluso pueden cifrar la IP en la plataforma o compartirla con otros.

OneStream, en otras palabras, permite a las organizaciones administrar sus datos de manera efectiva. En nuestro libro electrónico sobre gestión de calidad de datos financieros, compartimos los 3 objetivos principales para una gestión eficaz de la calidad de los datos financieros con CPM:

- Integración de datos simplificada – La integración directa a cualquier sistema GL/ERP abierto permite a los usuarios profundizar y profundizar en los datos de origen.

- Integridad de datos mejorada: Potentes validaciones y confirmaciones previas y posteriores a la carga de datos que garantizan que los datos correctos estén disponibles en cada paso del proceso.

- Mayor transparencia – 100% de transparencia y registros de auditoría para datos, metadatos y visibilidad de cambios de procesos desde el informe hasta la fuente.

Conclusión

Los gremlins de datos pueden interrumpir las operaciones comerciales y provocar graves implicaciones comerciales, por lo que es esencial que las organizaciones controlen sus procesos de gestión de datos antes de que surjan los gremlins de datos. Al desarrollar una estrategia de gestión de datos, invertir en sistemas sólidos de gestión de datos, realizar auditorías de datos regulares, capacitar a los empleados sobre las mejores prácticas de gestión de datos y tener un plan de recuperación ante desastres, las organizaciones pueden prevenir problemas relacionados con los datos y garantizar la continuidad del negocio.

Más información

Para obtener más información sobre cómo las organizaciones se están alejando de sus gremlins de datos, descargue nuestro documento técnico titulado "Unifique la planificación conectada o enfrente el costo oculto."

El aprendizaje automático (ML) tiene el potencial de revolucionar la gestión del rendimiento empresarial (EPM) al proporcionar a las organizaciones información en tiempo real y capacidades predictivas en los procesos de planificación y previsión. Con la capacidad de procesar grandes cantidades de datos, los algoritmos de ML pueden ayudar a las organizaciones a identificar patrones, tendencias y relaciones que de otro modo pasarían desapercibidos. Y a medida que la tecnología continúa evolucionando y mejorando, es probable que surjan beneficios aún mayores en el futuro a medida que Finanzas aproveche el poder de ML para lograr objetivos financieros.

Únase a nosotros mientras examinamos Sensible ML para EPM: el futuro de las finanzas al alcance de su mano.

El cambio a las finanzas inteligentes

Para los directores financieros, si la inteligencia artificial (AI) y el ML jugarán un papel en los procesos de planificación empresarial ya no es una pregunta. Hoy en día, la pregunta se centra en cambio en cómo poner en funcionamiento el aprendizaje automático de manera que arroje resultados y una escala óptimos. La respuesta es donde las cosas se ponen difíciles.

¿Por qué? La agilidad empresarial es fundamental en el mundo de la planificación que cambia rápidamente. Para pensar rápido y moverse primero, las organizaciones deben superar desafíos que abarcan la necesidad de hacer crecer rápidamente el negocio, predecir con precisión la demanda futura, anticipar circunstancias de mercado imprevistas y más. Sin embargo, los crecientes volúmenes de datos en toda la organización dificultan que los responsables de la toma de decisiones se concentren en los datos necesarios y extrapolen los conocimientos adecuados para impactar positivamente en los ciclos de planificación y los resultados. Para agravar aún más el problema, muchos procesos y herramientas de análisis avanzados solo aprovechan datos históricos de alto nivel, lo que obliga a los responsables de la toma de decisiones a volver a pronosticar desde cero cada vez que se producen cambios imprevistos en el mercado.

Pero con AI y ML, los analistas comerciales pueden analizar y correlacionar las variables internas/externas más relevantes. Y las variables luego contribuyen a la precisión del pronóstico y el rendimiento en los procesos de ventas, cadena de suministro, recursos humanos y marketing que comprenden los planes y resultados financieros.

Esas dinámicas subrayan por qué ahora es el momento de las finanzas inteligentes.

En las próximas semanas, compartiremos un informe de cuatro partes blog serie que analiza el camino hacia la planificación inteligente impulsada por ML. Aquí hay un adelanto de los temas clave en nuestra serie Sensible ML para EPM:

- Parte 1: 4 fuerzas impulsoras del cambio. Estas fuerzas tienen el potencial de acelerar el aprendizaje automático y alejar a las organizaciones de los análisis descriptivos y de diagnóstico (que explican qué sucedió y por qué) hacia los análisis predictivos y prescriptivos.

- Parte 2: aumentar la precisión y la transparencia. Hoy más que nunca, las organizaciones buscan ser más ágiles, precisas y transparentes con sus planes financieros para mantenerse competitivas. Y Sensible ML puede ayudar. Permite la entrada de usuarios más cercanos a la empresa para infundir intuición empresarial en el modelo, lo que puede aumentar la precisión y garantizar que se tenga en cuenta toda la información disponible. (ver figura 1)

- Parte 3: Capacidades clave para la planificación inteligente. Sensible ML es diferente a "la mayoría" de las capacidades de pronóstico de análisis predictivo (observando resultados y estadísticas anteriores y generando pronósticos basados en lo que sucedió en el pasado). Específicamente, Aprendizaje automático sensatotiene la capacidad no solo de observar resultados anteriores, sino también de asumir intuición comercial adicional, como eventos, precios, información competitiva y el clima, para ayudar a generar pronósticos más precisos y sólidos.

- Parte 4: Historias de éxito de clientes. Cada cliente debe ser una referencia y un éxito. La declaración de misión de OneStream impulsa todo lo que hacemos. Echar un vistazo más profundo a los clientes que han cosechado los beneficios de aprovechar Sensible ML puede ayudar a cualquier organización a obtener información predictiva real.

Independientemente de dónde se encuentre en su viaje financiero, nuestra serie Sensible ML para EPM está diseñada para compartir información de la experiencia del equipo de expertos de la industria de OneStream. Reconocemos, por supuesto, que cada organización es única, así que evalúe qué es lo más importante para usted en función de las necesidades específicas de su organización.

Conclusión

La aspiración de los planes basados en ML no es nada nuevo. Pero para seguir siendo competitivos en medio del ritmo cada vez mayor del cambio y la disrupción tecnológica, los líderes financieros deben pensar de manera diferente para finalmente conquistar las complejidades inherentes a la planificación empresarial tradicional. ML tiene el potencial de mejorar en gran medida EPM al proporcionar a las organizaciones información en tiempo real y análisis predictivo. Sin embargo, las organizaciones deben superar desafíos (p. ej., garantizar una buena calidad de los datos y seleccionando el algoritmo ML correcto) para lograr el éxito. A medida que ML continúa evolucionando, es probable que cada vez más organizaciones aprovechen su poder para impulsar mejores resultados financieros y operativos.

Se avecinan varios desafíos para organizaciones de todos los tamaños, pero una de las decisiones más importantes será implementar la solución de ML correcta, una que pueda alinear de manera efectiva todos los aspectos de planificar y elevar a la organización hacia sus metas estratégicas. Sensible ML responde a esa llamada. Aporta poder y sofisticación a las organizaciones para impulsar la transparencia y aumentar la velocidad de los procesos de previsión con una transparencia y una alineación sin precedentes con el rendimiento empresarial.

Más información

Para obtener más información sobre el valor de Sensible ML, descargue nuestro documento técnico titulado "Aprendizaje automático sensible para CPM: finanzas futuras al alcance de su mano" haciendo click esta página. ¡Y no se olvide de sintonizar publicaciones adicionales de nuestra serie de blogs de aprendizaje automático!

Hoy en día, la confianza en la calidad de los datos es más necesaria que nunca. Los ejecutivos deben responder constantemente a una multitud de cambios y contar con datos precisos y oportunos para tomar las decisiones correctas sobre qué acciones tomar. Por lo tanto, es más importante que nunca que las organizaciones tengan una estrategia clara para la gestión continua de la calidad de los datos financieros (FDQM). ¿Por qué? Bueno, mejores resultados resultan de mejores decisiones. Y los datos de alta calidad brindan a las organizaciones la confianza necesaria para hacerlo bien. Esta confianza en los datos, en última instancia, impulsa un mejor rendimiento y reduce el riesgo.

¿Por qué es importante la calidad de los datos?

La calidad de los datos es importante por varias razones clave, como lo demuestra la investigación. Según Gartner,[1] la mala calidad de los datos cuesta a las organizaciones una media de 12.9 millones de dólares al año. Esos costos se acumulan no solo por el tiempo de recursos desperdiciado en los procesos financieros y operativos, sino también, y lo que es más importante, por las oportunidades de ingresos perdidas.

A medida que las organizaciones recurren a una mejor tecnología para ayudar a impulsar una mejor dirección futura, el énfasis puesto en la gestión de la calidad de los datos financieros en los sistemas empresariales solo ha aumentado. Gartner también predijo que, para 2022, el 70 % de las organizaciones realizarían un seguimiento riguroso de los niveles de calidad de los datos a través de métricas, mejorando la calidad en un 60 % para reducir significativamente los riesgos y costos operativos.

En un informe sobre cómo cerrar la brecha entre el valor y los datos, Accenture[2] dijo que “sin confianza en los datos, las organizaciones no pueden construir una base de datos sólida”. Solo un tercio de las empresas, según el informe, confía en sus datos lo suficiente como para usarlos de manera efectiva y obtener valor de ellos.

En resumen, la importancia de la calidad de los datos es cada vez más clara para muchas organizaciones, creando un caso convincente para un cambio en presentación de informes financieros evaluaciones de software. Ahora hay un impulso real para derribar las barreras históricas y avanzar con confianza renovada.

Rompiendo las Barreras a la Calidad de los Datos

La gestión de la calidad de los datos financieros ha sido difícil, si no virtualmente imposible, de lograr para muchas organizaciones. ¿Por qué? Bueno, en muchos casos, la gestión del rendimiento corporativo (CPM) y los sistemas ERP heredados simplemente no se crearon para funcionar juntos de forma natural y, en cambio, tendían a permanecer separados como aplicaciones aisladas, cada una con su propio propósito. Existe poca o ninguna conectividad entre los sistemas, por lo que los usuarios a menudo se ven obligados a recurrir a la recuperación manual de datos de un sistema, transformarlos manualmente y luego cargarlos en otro sistema, lo que requiere mucho tiempo y corre el riesgo de obtener datos de menor calidad.

También suele haber una falta de controles de atención al público que genera una serie de problemas:

- Entrada deficiente de datos y validación limitada.

- Arquitectura de datos ineficiente con múltiples sistemas de TI heredados.

- Falta de soporte comercial para el valor de la transformación de datos.

- La atención inadecuada a nivel ejecutivo impide que una organización establezca los cimientos efectivos para calidad de los datos financieros.

Todo eso contribuye a las barreras significativas para garantizar una buena calidad de los datos. Estas son las 3 principales barreras:

- Múltiples sistemas desconectados – Múltiples sistemas y aplicaciones en silos dificultan la combinación, agregación y estandarización de datos de manera oportuna. Los sistemas individuales se agregan en diferentes momentos, a menudo utilizando diferentes tecnologías y diferentes estructuras dimensionales.

- Datos de mala calidad – Los datos en los sistemas de origen a menudo están incompletos, son inconsistentes o están desactualizados. Además, muchos métodos de integración simplemente copian datos completos con cualquier error existente, sin validaciones ni control.

- Compra ejecutiva – El hecho de no obtener la aceptación de los ejecutivos podría deberse a la percepción o al enfoque. Después de todo, una estrategia efectiva de calidad de datos requiere enfoque e inversión. Con tantos proyectos en competencia en cualquier organización, el caso de una estrategia debe ser convincente y demostrar de manera efectiva el valor que puede brindar la calidad de los datos.

Sin embargo, incluso cuando se reconocen tales barreras, lograr que los equipos de Finanzas y Operaciones renuncien a sus herramientas de software de informes financieros y formas tradicionales de trabajar puede ser un gran desafío. Las barreras, sin embargo, a menudo no son tan difíciles de superar como algunos creen.

La solución puede ser tan simple como demostrar cuánto tiempo se puede ahorrar al hacer la transición a herramientas y tecnología más nuevas. A través de tales transiciones, reducir la inversión de tiempo puede resultar en una mejora dramática en la calidad de la datos a través de una integración efectiva con la validación y el control integrados en el propio sistema.

La Solución

Hay quienes creen que la ley de Pareto se aplica a la calidad de los datos: por lo general, el 20 % de los datos permite el 80 % de los casos de uso. Por lo tanto, es fundamental que una organización siga estos 3 pasos antes de embarcarse en cualquier proyecto para mejorar la calidad de los datos financieros:

- Definir calidad – Determinar qué significa calidad para la organización, acordar la definición y establecer métricas para alcanzar el nivel en el que todos se sientan seguros.

- Optimice la recopilación de datos – Garantizar que se minimice la cantidad de sistemas dispares y que las integraciones utilicen tecnología de clase mundial con consistencia en los procesos de recopilación de datos.

- Identificar la importancia de los datos. – Saber qué datos son los más críticos para la organización y empezar por ahí – con el 20 %. Luego continúe cuando la organización esté lista.

En esencia, un sistema totalmente integrado plataforma de software CPM incorporado la calidad de los datos financieros (consulte la Figura 1) es fundamental para que las organizaciones impulsen una transformación eficaz en Finanzas y Líneas de negocio. Un requisito clave es proporcionar una visibilidad del 100 % desde los informes hasta las fuentes de datos, lo que significa que todos los datos financieros y operativos deben ser claramente visibles y fácilmente accesibles. Los procesos financieros clave deben automatizarse y el uso de una sola interfaz significaría que la empresa puede utilizar sus datos operativos y financieros centrales con una integración total con todos los ERP y otros sistemas.

La solución también debe incluir flujos de trabajo guiados para proteger a los usuarios comerciales de la complejidad al guiarlos de manera única a través de todos los procesos de administración, verificación, análisis, certificación y bloqueo de datos.

OneStream ofrece todo eso y más. Con una base sólida en la calidad de los datos financieros, OneStream permite a las organizaciones integrar y validar datos de múltiples fuentes y tomar decisiones seguras basadas en resultados financieros y operativos precisos. La gestión de la calidad de los datos financieros de OneStream no es un módulo ni un producto independiente, sino incorporado en el núcleo de la plataforma OneStream: proporciona controles estrictos para brindar la confianza y la confiabilidad necesarias para garantizar datos de calidad.

En nuestro libro electrónico sobre Gestión de calidad de los datos financieros, compartimos los siguientes 3 objetivos para una gestión eficaz de la calidad de los datos financieros con CPM:

- Simplifique la integración de datos – Integración directa a cualquier sistema GL/ERP abierto y faculta a los usuarios para profundizar y profundizar en los datos de origen.

- Mejore la integridad de los datos – Las potentes validaciones y confirmaciones previas y posteriores a la carga de datos garantizan que los datos correctos estén disponibles en cada paso del proceso.

- Aumentar la transparencia – 100% de transparencia y registros de auditoría para datos, metadatos y visibilidad de cambios de procesos desde el informe hasta la fuente.

Con un 100 % de casos de éxito en clientes

Este es un ejemplo de una organización que simplificó la recopilación de datos y mejoró la calidad de los datos en el proceso de cierre financiero, consolidación e informes aprovechando la plataforma unificada de OneStream.

MEC Holding GmbH – con sede en Bad Soden, Alemania – fabrica y suministra consumibles y servicios de soldadura industrial, sistemas de corte e instrumentos médicos para OEM en Alemania e internacionalmente. La empresa opera a través de tres unidades: Castolin Eutectic Systems, Messer Cutting Systems y BIT Analytical Instruments.

MEC tiene informes mensuales de 36 países, incluidas más de 70 entidades y 15 monedas locales, por lo que el proceso de informes y consolidación financiera incluye un alto volumen de actividad entre empresas. Con OneStream, la recopilación de datos ahora es mucho más fácil con flujos de trabajo guiados que guían a los usuarios a través de sus tareas. Los usuarios cargan los balances de comprobación por su cuenta en lugar de enviarlos a la empresa, lo que acelera el proceso y garantiza la calidad de los datos. Además, el nuevo sistema fue muy fácil de aprender y adoptar para los usuarios con una capacitación limitada.

MEC descubrió que la confianza de tener 'una versión de la verdad' es completamente posible con OneStream.

Más información

Si su organización financiera se ve obstaculizada para liberar su verdadero valor, tal vez sea el momento de evaluar sus sistemas y procesos internos y comenzar a identificar áreas de mejora. Para saber cómo, lea nuestro documento técnico sobre Conquistar la complejidad en el cierre financiero.

La gestión de la calidad de los datos financieros (FDQM) a menudo se ha desarrollado como una mera ocurrencia tardía o se ha presentado simplemente como una opción por la mayoría de los proveedores de gestión del rendimiento corporativo (CPM). En realidad, debería ser la base de cualquier sistema CPM. ¿Por qué? Bueno, tener capacidades FDQM sólidas reduce no solo los errores y sus consecuencias, sino también el tiempo de inactividad causado por interrupciones en los procesos y los costos asociados de ineficiencia.

Tener una FDQM eficaz significa proporcionar controles de auditoría estrictos junto con procesos estándar, definidos y repetibles para lograr la máxima confianza y confiabilidad en cualquier proceso de usuario empresarial. La FDQM eficaz también permite a una organización acortar los ciclos de cierre financiero y presupuestario y obtener información crítica para los usuarios finales de forma más rápida y sencilla.

Continuando nuestro Re-imaginando el blog cercano Aquí, examinamos por qué la gestión de la calidad de los datos financieros es un requisito esencial en el entorno actual de informes corporativos. La mala calidad de los datos puede dar lugar a errores u omisiones en los estados financieros, que a menudo resultan en sanciones de cumplimiento, pérdida de confianza de las partes interesadas y, potencialmente, una reducción en el valor de mercado.

Mayor interés en la gestión de la calidad de los datos financieros

Las organizaciones ahora se están dando cuenta de que FDQM es fundamental. ¿Por qué? Los equipos de finanzas deben asegurarse no solo de que los informes financieros salgan por la puerta con precisión, sino también de que todos los datos y la orientación prospectivos estén totalmente respaldados por resultados reales de "calidad".

Una antigua expresión utilizada en torno a la presentación de informes financieros capta bien esta idea: "si se echa basura, se saca la basura".

La falta de capacidades sólidas de integración de datos crea una multitud de problemas. Éstos son solo algunos:

- Pasos manuales que desperdician recursos y tiempo

- Riesgo de errores

- Malas decisiones financieras

- Falta de trazabilidad

- Falta de auditabilidad

En muchos casos, los sistemas CPM y ERP heredados simplemente no se construyeron para trabajar juntos de forma natural y tienden a permanecer separados como aplicaciones en silos, cada una con su propio propósito. A menudo, existe poca o ninguna conectividad entre los sistemas, y los usuarios se ven obligados a recurrir a recuperar manualmente los datos de un sistema, transformarlos manualmente y luego cargarlos en otro sistema.

A medida que las organizaciones se vuelven cada vez más complejas y los volúmenes de datos crecen cada vez más, es natural prestar atención a la calidad de los datos que se ingresan. Sin mencionar que, a medida que se exploran y adoptan capacidades más avanzadas, como la inteligencia artificial (IA) y el aprendizaje automático (ML), las organizaciones se ven obligadas a examinar primero sus datos y luego tomar medidas para garantizar una calidad de datos efectiva. ¿Por qué son necesarios estos pasos? En pocas palabras, los mejores resultados de la inteligencia artificial, el aprendizaje automático y otras tecnologías avanzadas dependen por completo de datos de buena calidad y limpios desde el principio.

¿Cual es la solución?

Una plataforma CPM / EPM completamente integrada con FDQM en su núcleo es fundamental para que las organizaciones impulsen una transformación efectiva en Finanzas y líneas de negocio. Un requisito clave es la visibilidad del 100% desde los informes hasta las fuentes: todos los datos financieros y operativos deben ser claramente visibles y de fácil acceso. Los procesos financieros clave deben automatizarse y el uso de una única interfaz significaría que la empresa puede utilizar sus datos financieros y operativos básicos con una integración completa con todos los ERP y otros sistemas.

La solución también debe incluir flujos de trabajo guiados para proteger a los usuarios comerciales de la complejidad guiándolos de manera única a través de todos los procesos de administración, verificación, análisis, certificación y bloqueo de datos.

Los usuarios deben poder lograr una FDQM y una verificación efectivas a través de la recopilación y el análisis de datos estandarizados y simplificados con informes en cada paso del flujo de trabajo. Los flujos de trabajo deben guiarse para proporcionar procesos estándar, definidos y repetibles para la máxima confianza y confiabilidad en un proceso empresarial impulsado por el usuario. ¿Cuál es el resultado final? La simplificación de los procesos comerciales y la reducción de errores e ineficiencias en toda la empresa.

¿Por qué OneStream?

Los sólidos cimientos de OneStream en el campo de FDQM permiten una flexibilidad y visibilidad incomparables en el proceso de carga e integración de datos.

De OneStream Gestión de calidad de los datos financieros no es un módulo ni un producto separado, sino que es una parte fundamental de la plataforma unificada de OneStream, que proporciona controles estrictos para brindar confianza y confiabilidad en la calidad de sus datos. ¿Cómo? El riesgo de calidad de los datos financieros se gestiona mediante mapas de integración de sistemas totalmente auditables y las validaciones se utilizan para controlar los envíos desde sitios remotos. Los datos se pueden cargar a través de conexiones directas a bases de datos de origen o mediante cualquier formato de archivo. Los informes de auditoría se pueden filtrar en función de los umbrales de materialidad, lo que garantiza revisiones únicas en los puntos apropiados del proceso.

En esencia, la plataforma unificada de OneStream ofrece capacidades de integración de datos líderes en el mercado con conexiones fluidas a múltiples fuentes.

Los conectores de integración OneStream ofrecen integración directa con cualquier GL / ERP abierto u otros sistemas de origen, proporcionando los siguientes beneficios:

- Ofrece procesos de integración de sistemas directos a fuente rápidos y eficientes con automatización de procesos robóticos (RPA) incorporada.

- Profundiza, profundiza y desglosa los detalles transaccionales, incluidos los asientos del diario.

- Proporciona integración directa con drill back en más de 250 ERP, HCM, CRM y otros sistemas (por ejemplo, Oracle, PeopleSoft, JDE, SAP, Infor, Microsoft AX / Dynamics y más).

100% éxito del cliente

Seguro de vida AAA implementó OneStream para respaldar todas sus necesidades de consolidación financiera, informes, presupuestos y análisis. Desde entonces, AAA Life ha simplificado el proceso de cierre financiero y mejorado drásticamente no solo la visibilidad de los datos, sino también la transparencia de los resultados. Ahora pueden desglosar desde los números calculados o consolidados de OneStream hasta el sistema ERP transaccional para obtener respuestas rápidas a preguntas críticas.

El sueño de 'una versión de la verdad' es completamente posible con OneStream.

Más información

Para obtener más información sobre cómo puede volver a imaginar el cierre financiero con el poder inigualable de la plataforma financiera inteligente de OneStream, descargue nuestro documento técnico. Y no olvide sintonizar las publicaciones adicionales de nuestra serie de blogs Re-Imagining the Financial Close.

Los CFO y los controladores de hoy en día necesitan administrar sus procesos y datos financieros críticos de toda la empresa de la manera más efectiva posible. Esos datos deben ser oportunos, precisos y fácilmente accesibles para informes y análisis perspicaces para mantener una ventaja competitiva. En consecuencia, sus soluciones de gestión del rendimiento corporativo (CPM) deben ser robustas, escalables y proporcionar una integración total con sus sistemas ERP, HCM, CRM y otros.

Ya sea que esté buscando una solución EPM o buscando cambiar a una nueva solución, la capacidad de obtención de detalles de OneStream es la funcionalidad que nunca supo que necesitaba.

Muchos proveedores afirman manejar consolidaciones complejas, pero existen varias diferencias significativas entre el motor subyacente que se necesita para ejecutar agregación de datos financieros y el motor utilizado para ejecutar agregaciones directas o consolidaciones simples. Cualquier proveedor que utilice Microsoft Analysis Services, Oracle Essbase, Cognos, TM1, SAP Hanna o un motor de agregación directo similar enfrentará numerosos desafíos para abordar consolidación financiera requisitos Examinemos esto más de cerca.